Resumen

- La alucinación de la IA es real y puede ocurrir cuando un LLM llena vacíos con datos no relacionados.

- Tenga cuidado con las respuestas de la IA, valide siempre la información para evitar imprecisiones.

- Los LLM son herramientas útiles pero no siempre confiables, verifique las respuestas para evitar errores.

En lo que respecta a la IA, hay muchas cosas que no sabemos realmente. La ingeniería inversa de modelos de IA es una industria enorme y el campo en sí se denomina interpretabilidad mecanicista. Dicho esto, tenemos algunos conocimientos a nivel conceptual sobre cómo suceden algunas cosas, y una interesante con la que me encontré recientemente fue una extraña alucinación del GPT-3.5 de OpenAI cuando le pedí que tradujera una palabra al irlandés.

ChatGPT vs Microsoft Copilot vs Google Gemini: ¿Cuáles son las diferencias?

Si ha estado tratando de averiguar qué herramienta de IA generativa es mejor, ha llegado al lugar correcto.

Alucinaciones y relaciones

Las IA "relacionan" temas y conceptos entre sí

Como breve introducción, el irlandés es uno de los idiomas oficiales de Irlanda y suele etiquetarse erróneamente como "gaélico". El gaélico y el irlandés no son lo mismo, y el irlandés es la lengua materna de un pequeño subconjunto de la población irlandesa. Sin embargo, no soy de una región de habla irlandesa del país, por lo que tendría dificultades para conversar con un hablante nativo. Decidí jugar con ChatGPT para traducir palabras y frases al irlandés, en particular porque tenía curiosidad por saber si había sido entrenado con datos del idioma irlandés.

Teniendo esto en mente, una descripción general rudimentaria de cómo aprende un LLM es que, con un corpus masivo de datos, construye relaciones y conceptos entre los datos que contiene para comprender lo que hay dentro. Por lo general, no comprenderá algofuerade los datos, pero puede hacer conjeturas en función de lo que aprendió en el pasado. Luego, puede aprender patrones y descubrir cómo se relacionan las cosas entre sí, lo que a su vez permite indicaciones donde, esencialmente, repasa lo que ha aprendido en su red neuronal y cómo se relacionan esas palabras, y luego construye una respuesta en relación con eso.

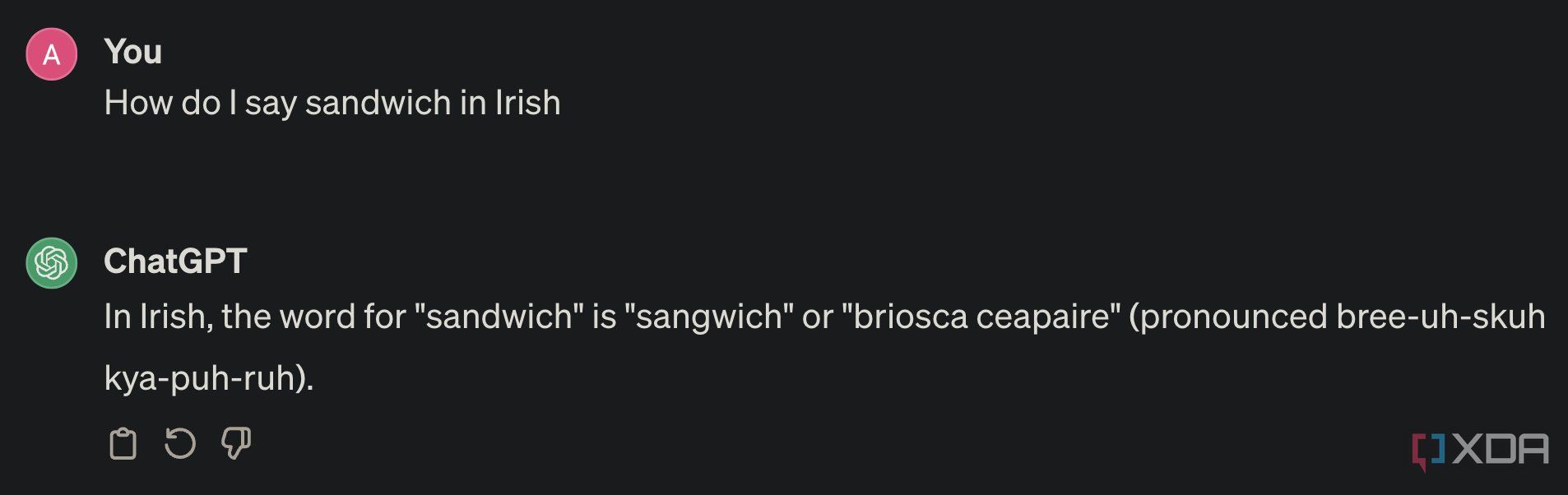

Cuando le pregunté sobre las palabras traducidas al irlandés, ChatGPT se comportó más o menos bien y parecía tener una comprensión general de los conceptos básicos del idioma. Sin embargo, cuando le pedí que tradujera "sandwich" al irlandés, me encontré con algo bastante gracioso. No solo tuvo dificultades, sino que directamente alucinó, y creo que sé exactamentepor quétuvo dificultades. Es un gran ejemplo de lo que puede suceder cuando se construye una relación en los datos que aprendió, pero es una relación lo suficientemente débil como para que también se filtren datos de otros lugares.

En primer lugar, la palabra irlandesa para "sándwich" es "ceapaire". Todo lo demás en la captura de pantalla anterior es incorrecto, pero fíjate específicamente en "sangwich". "Sangwich" es un término del argot irlandés para sándwich, y es solo una forma tonta de decirlo. En realidad no proviene de nada (excepto posibles acentos regionales), pero es algo que aparecerá en foros en línea como Reddit con frecuencia.

Sin embargo, lo que resulta interesante es que en los subreddits irlandeses, donde el término descriptivo para una persona de Irlanda es "irlandés" y el idioma también se llama "irlandés", me parece bastante probable que ChatGPT haya logrado combinar los dos en el contexto de este término de jerga. El término irlandés (personas) que se refiere a un sándwich como "sangwich" se confundió básicamente en el corpus de datos con el término de personas que se refieren a un sándwich, en irlandés (el idioma) como "sangwich". A partir de ahí, se cruzaron cables y aprendió esa asociación.

Es un pequeño ejemplo, y no he encontrado nada parecido, pero aun así es una alucinación interesante que muestra solo una forma en que puede suceder. La mejor manera de identificarlos es tratar de detectar inconsistencias y problemas en lo que sería el "borde" del conjunto de entrenamiento, y los idiomas más pequeños como el irlandés son la manera perfecta de exponerlos.

La alucinación de la IA es real y puede tener peores consecuencias

Tenga cuidado al utilizar una IA

Si bien este ejemplo es divertido, la alucinación de la IA es muy real. Cuando no están completamente entrenados en lo que les estás preguntando, simplemente llenarán los espacios vacíos con lo que tenga más "sentido" para la IA. En este caso, tenía una relación vaga que probablemente había construido a partir de las redes sociales. Lo mismo puede suceder en otros lugares. El hecho de que haya aprendido no significa que sea correcta, y tampoco significa que la respuesta que obtengas sea completamente precisa.

Cuando recibas una respuesta de un LLM sobre un tema con el que no estás familiarizado, asegúrate de investigar todas las afirmaciones que se hacen. Los LLM son excelentes herramientas para averiguar la fuente de algo o para utilizarlos como un motor de búsqueda superpoderoso, pero nunca confíes en ellos para obtener todas las respuestas correctas. A veces se equivocan y, si no cuestionas o verificas esas respuestas, podrías cometer el mismo error.

Ejecute LLM locales con facilidad en Mac y Windows gracias a LM Studio

Si desea ejecutar LLM en su PC o portátil, nunca ha sido más fácil hacerlo gracias al potente y gratuito LM Studio. Aquí le mostramos cómo usarlo