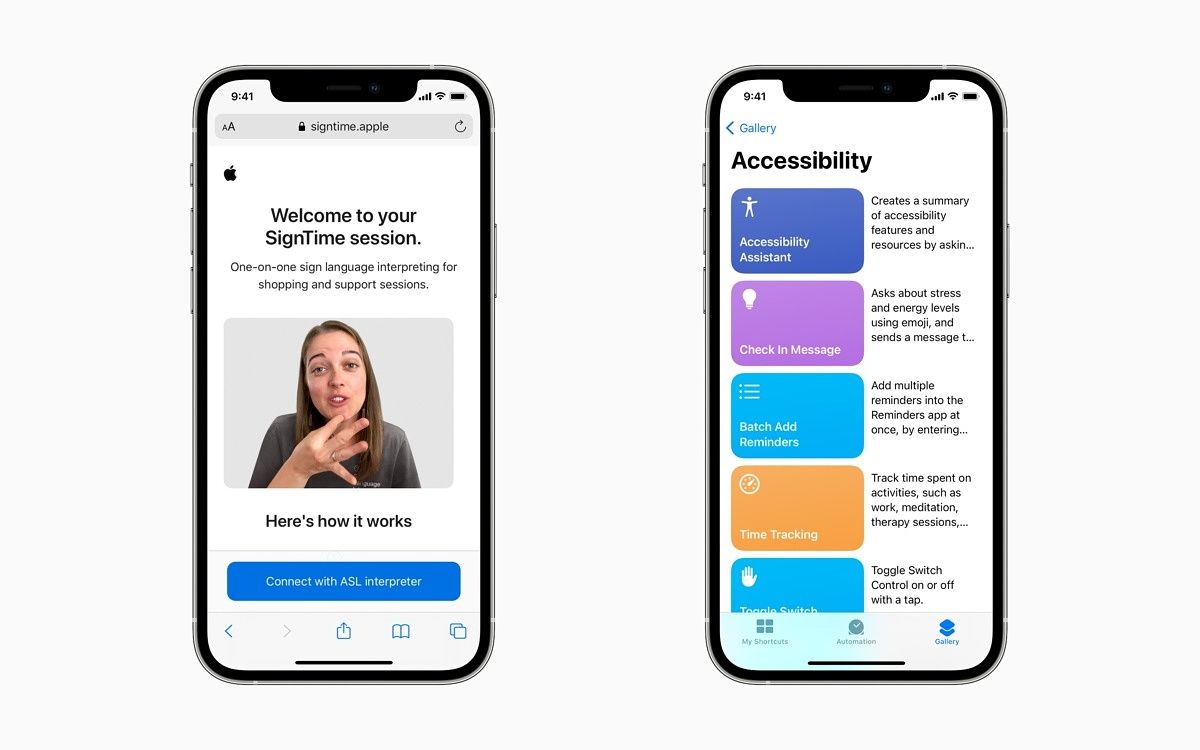

Apple ha anunciado una serie de nuevas funciones diseñadas para personas con discapacidades, entre ellas, un servicio de interpretación de lenguaje de señas personalizado llamado SignTime para realizar compras y ofrecer asistencia. El anuncio se produce unas semanas antes dela Conferencia Mundial de Desarrolladores de Apple, donde se espera que la empresa presente actualizaciones para iOS, watchOS y iPadOS.

Hablando de eso, muchas de las nuevas herramientaspresentadas por Applellegarán en actualizaciones que llegarán a las plataformas mencionadas más adelante este año. Algunas de las nuevas características incluyen opciones para Assistive Touch, VoiceOver, soporte para audífonos y una representación mejorada relacionada con la personalización de Memoji. Esta última característica representará a los usuarios con tubos de oxígeno, implantes cocleares y un casco blando para la cabeza.

En cuanto a SignTime, el nuevo servicio se lanzará el 20 de mayo en Estados Unidos, Reino Unido y Francia, y se espera que se amplíe a otros países en el futuro. La nueva función proporcionará a las personas sordas o con problemas de audición acceso a AppleCare y a la atención al cliente de los minoristas a través del lenguaje de señas americano (ASL), el lenguaje de señas británico (BSL) o el lenguaje de señas francés (FSL).

Apple también está incorporando Assistive Touch al Apple Watch para usuarios con diferencias en las extremidades superiores. La función utilizará sensores de movimiento integrados, como el giroscopio y el acelerómetro, junto con el aprendizaje automático del dispositivo, para detectar diferencias sutiles en el movimiento muscular. Esto permitirá a los usuarios controlar el Apple Watch, incluso responder llamadas entrantes y acceder al Centro de notificaciones, sin tener que tocar la pantalla ni los controles.

Una nueva función incorpora el seguimiento ocular al iPad. Apple dijo que, a finales de este año, los dispositivos MFi compatibles rastrearán hacia dónde mira una persona en la pantalla y el puntero se moverá para seguir la mirada de la persona. El contacto visual prolongado realiza una acción, como un toque, dijo Apple.

Apple también está presentando una actualización del programa de dispositivos auditivos MFi, agregando soporte para nuevos audífonos bidireccionales. Los micrófonos en estos audífonos permitirán a las personas sordas o con problemas de audición tener conversaciones telefónicas y por FaceTime con manos libres. Los dispositivos que admiten el programa actualizado de dispositivos auditivos estarán disponibles a finales de este año. Apple dijo que también está brindando soporte para reconocer audiogramas a Headphone Accommodations.

Además, Apple dijo que está introduciendo una nueva función de sonidos de fondo, que reproducirá sonidos de fondo para enmascarar el ruido ambiental no deseado. La compañía dijo que estos sonidos pueden minimizar las distracciones y ayudar a los usuarios a concentrarse, calmarse o descansar. Algunos de los sonidos incluyen "ruidos equilibrados, brillantes u oscuros, así como sonidos del océano, la lluvia o los arroyos". Apple dijo que estos sonidos se mezclarán o se atenuarán con otros sonidos de audio y del sistema.

Por último, una actualización permitirá a los usuarios explorar imágenes con VoiceOver. Los usuarios podrán explorar las imágenes de forma más exhaustiva, incluidos detalles sobre las personas, el texto, los datos de las tablas y otros objetos dentro de las imágenes.

Apple afirmó que estas nuevas funciones amplían los límites de la innovación y acercan la diversión y la funcionalidad de la tecnología de Apple a aún más personas. “La accesibilidad es un derecho fundamental y siempre estamos ampliando los límites de la innovación para que todos puedan aprender, crear y conectarse de nuevas maneras”, dijo el director ejecutivo de Apple, Tim Cook, en Twitter.