Resumen

- Apple compartió algunas nuevas funciones de accesibilidad que llegarán al iPhone, iPad y Vision Pro a finales de este año.

- La marca presentó seguimiento ocular, tecnología háptica musical, atajos vocales, señales de movimiento del vehículo y más.

- El próximo evento WWDC de Apple probablemente arrojará más luz sobre estas y próximas actualizaciones de software.

Apple está preparada para tener un gran año en 2024, ya que dará su primer paso real en el ámbito de la inteligencia artificial con sus próximos productos de hardware y software. Y aunque no sabemos exactamentequé va a ofrecer la marca, ha habido rumores de que podríaasociarse con algunos grandes nombrespara hacer realidad su visión.

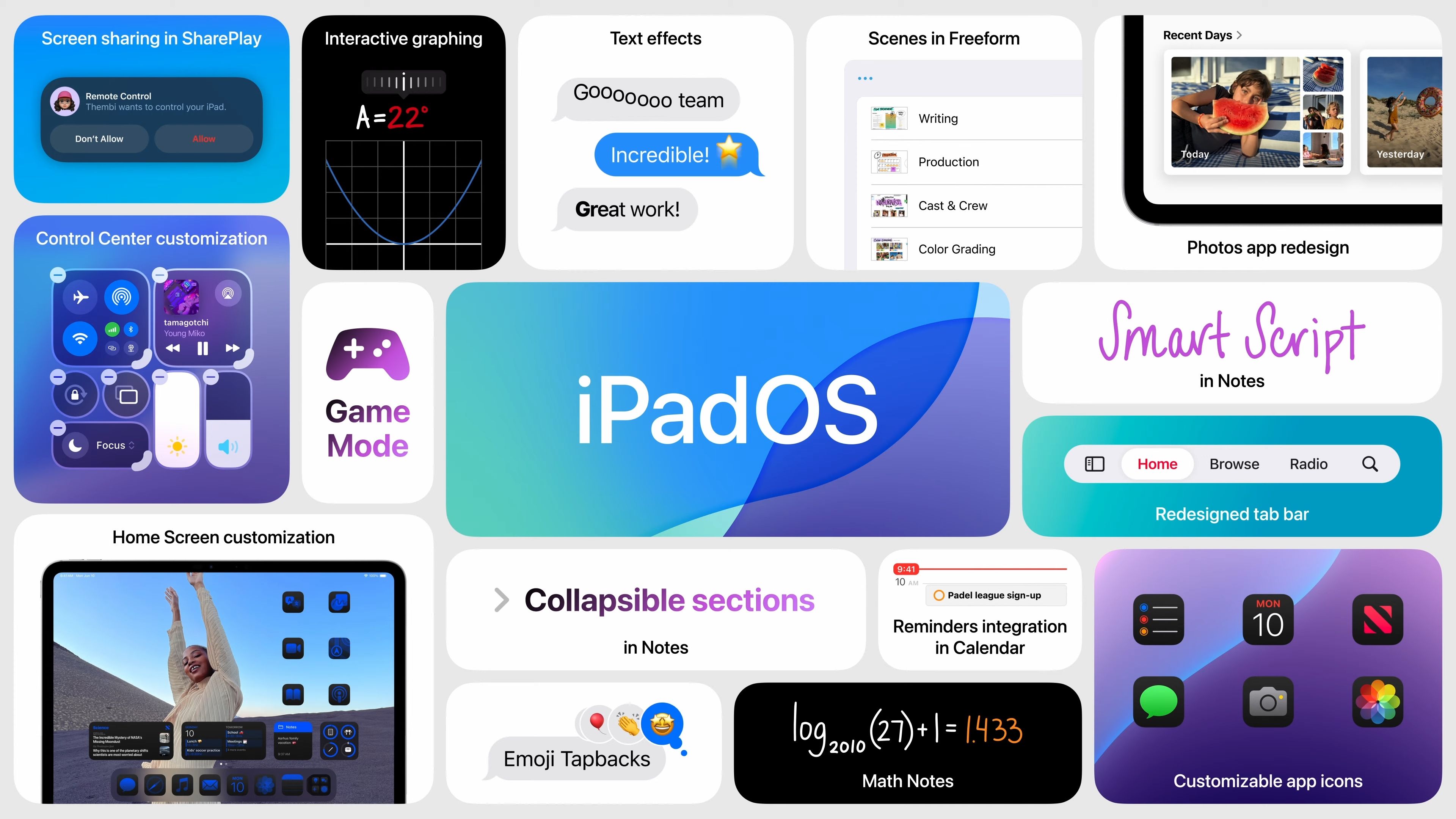

iPadOS 18: Todo lo que necesitas saber

¡La primera vista previa oficial de iPadOS 18 ya está aquí!

Dicho esto, la compañía está preparada para mostrar en qué ha estado trabajando durante su conferencia anual para desarrolladores, que se llevará acabo el 10 de junio. Pero antes del evento, Apple ha compartido algunas funciones futuras como Eye Tracking, Music Haptics, Vocal Shortcuts y más que implementará en una actualización futura que realmente podría cambiar la forma en que algunos interactúan con sus dispositivos Apple.

Nuevas funciones que realmente podrían marcar una gran diferencia

La marca ha recurrido a susitio webpara compartir las novedades sobre las nuevas funciones de accesibilidad que llegarán a los dispositivos a finales de este año. Quizás la característica más interesante del paquete será la nueva función Eye Tracking, que permitirá a los usuarios navegar en iPad y iPhone simplemente usando la vista. La función no parece requerir ningún hardware especial y utilizará las cámaras frontales existentes en estos dispositivos junto con un poco de ayuda de la IA. La marca afirma que esta función es fácil de configurar y se "calibrará en segundos", utilizando el aprendizaje automático en el dispositivo, y los datos se mantendrán "de forma segura en el dispositivo" sin compartirlos con Apple.

Music Haptics ofrecerá a los usuarios una nueva forma de experimentar la música con el Taptic Engine del iPhone, creando "toques, texturas y vibraciones refinadas para el audio de la música". Si bien esto funcionará con millones de canciones enApple Music, la marca afirma que la API estará disponible para que los desarrolladores la utilicen con sus propias aplicaciones para brindar más funciones de accesibilidad. Además, con Vocal Shortcuts, los usuarios podrán "personalizar enunciados" para iniciar atajos y tareas. Apple también mejorará el reconocimiento de voz para tener en cuenta todos los diferentes tipos de patrones de habla.

Además de lo anterior, Apple también agregará señales de movimiento del vehículo que ayudarán a reducir el mareo al intentar leer contenido en un vehículo en movimiento. Las señales de movimiento se mostrarán como una superposición, con pequeños puntos animados que aparecerán en los bordes de la pantalla para mostrar los cambios en la dirección del vehículo. CarPlay también tendrá algunas nuevas funciones de accesibilidad como Control de voz, Filtros de color y Reconocimiento de sonido. El Reconocimiento de sonido podrá alertar a los conductores y pasajeros sordos o con problemas de audición sobre sirenas y bocinas cercanas.

El visionOS de Apple también contará con nuevas funciones de accesibilidad, como "subtítulos en vivo para todo el sistema" que llenarán el sistema de menús y las aplicaciones compatibles. Y, por si todo esto no fuera suficiente, Apple también agregará una variedad de actualizaciones que se pueden ver en su totalidad en la lista a continuación.

- Para los usuarios ciegos o con baja visión,VoiceOverincluirá nuevas voces, un rotor de voz flexible, control de volumen personalizado y la capacidad de personalizar los atajos de teclado de VoiceOver en Mac.

- La lupaofrecerá un nuevo modo de lectura y la opción de iniciar fácilmente el modo de detección con el botón Acción.

- Los usuarios de Braille obtendrán una nueva forma de comenzar y permanecer enla entrada de pantalla Braillepara un control y edición de texto más rápido; disponibilidad en idioma japonés para la entrada de pantalla Braille; soporte para braille multilínea conDot Pad; y la opción de elegir diferentes tablas de entrada y salida.

- Para los usuarios con baja visión,Hover Typingmuestra un texto más grande al escribir en un campo de texto, y en la fuente y color preferidos del usuario.

- Para los usuarios que corren el riesgo de perder la capacidad de hablar,Personal Voiceestará disponible en chino mandarín. Los usuarios que tengan dificultades para pronunciar o leer oraciones completas podrán crear una voz personal utilizando frases abreviadas.

- Para los usuarios que no hablan,Live Speechincluirá categorías y compatibilidad simultánea conLive Captions.

- Para los usuarios con discapacidades físicas,Virtual Trackpadpara AssistiveTouch permite a los usuarios controlar su dispositivo utilizando una pequeña región de la pantalla como un trackpad redimensionable.

- Switch Controlincluirá la opción de usar las cámaras del iPhone y el iPad para reconocer los gestos de toque de los dedos como interruptores.

- El control por vozofrecerá soporte para vocabularios personalizados y palabras complejas.

Por supuesto, estas actualizaciones no llegarán hasta finales de este año, cuando Apple presente la última versión de iOS, iPadOS y visionOS. Y aunque se trata de una gran muestra de lo que está por venir, lo más probable es que escuchemos mucho más cuando Apple celebre su evento WWDC el 10 de junio. Y por lo que podemos ver hasta ahora, estamos ansiosos por escuchar lo que Apple tiene reservado para iPhone, iPad y Mac el próximo mes.