Bit by Bites una columna semanal que se centra en los avances técnicos todas las semanas en varios espacios. Mi nombre es Adam Conway y he estado cubriendo temas tecnológicos y siguiendo las últimas novedades durante una década. Si hay algo que te interesa y te gustaría que se cubra, puedes contactarme en[email protected].

Una de mis mayores quejas en lo que respecta a la proliferación de tecnología de IA generativa ha sido la atribución de "pensamiento" a aplicaciones comoChatGPT. Si bien al principio uno podría caer en el error de pensar que son capaces de razonar gracias a su capacidad de presentar información de manera clara y concisa en función de la información ingresada por el usuario, existen algunas formasmuy sencillasde exponer estas fallas.

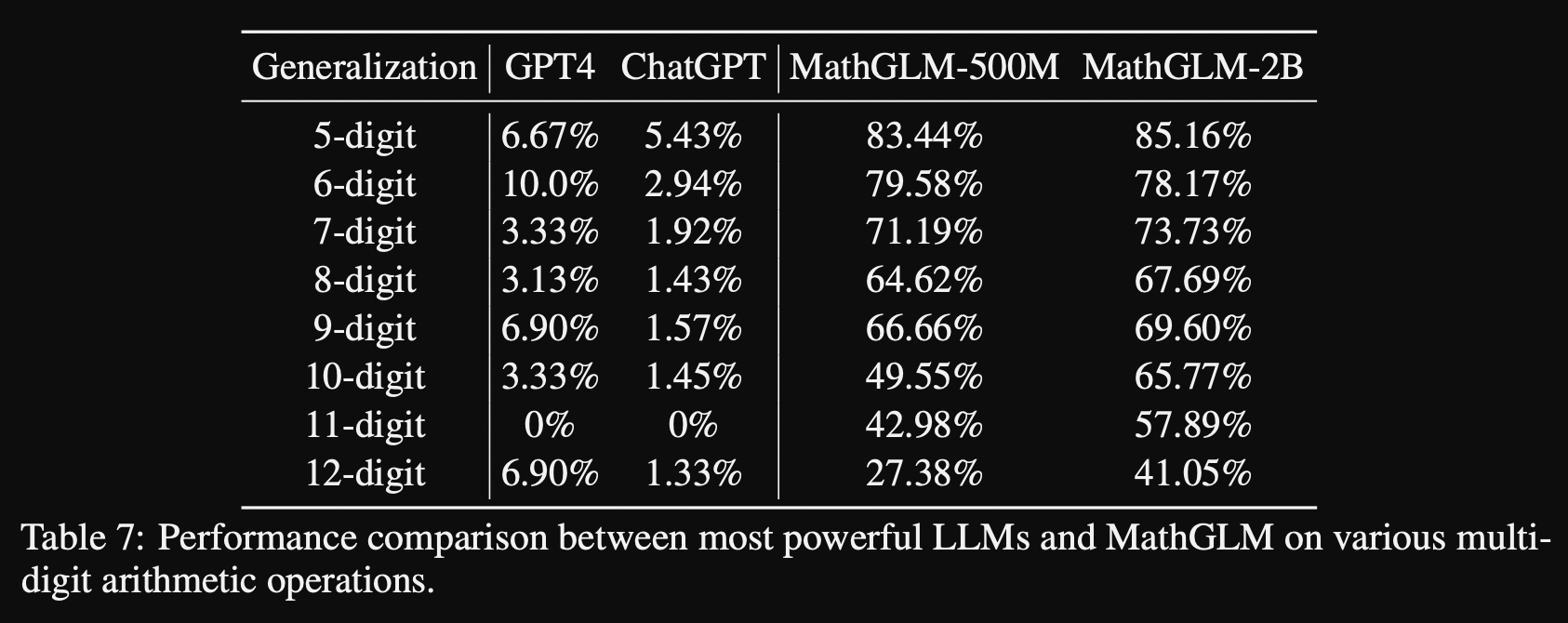

Por ejemplo, tomemos las matemáticas. Las matemáticas son una tarea inherentemente lógica que requiere una comprensión de números, operaciones y otras cosas basadas en la pregunta que se enfrenta. A menudo, si le pides a un LLM que resuelva una ecuación matemática lo suficientemente básica, podrá responderla... pero no es porque sea capaz de hacer algo lógico. No importa qué, 10,000*5 sigue siendo 50,000, y si un LLM se acerca a esa cifra pero no es esa, entonces sigue siendo la respuesta incorrecta. Una calculadora resolverá todos esos problemas con un 100% de precisión el 100% del tiempo.

Los LLM dan la ilusión de conocimiento

En realidad, son patrones y combinaciones.

En el mundo de la informática, los LLM tienenconocimientosen cierto sentido y se destacan por reconocer patrones. No son una base de datos tradicional, sino un modelo entrenado con grandes cantidades de datos de texto de millones de fuentes, lo que les permite generar respuestas contextualmente relevantes. Cuando un usuario proporciona una indicación, el LLM la interpreta y genera una respuesta basada en patrones probabilísticos aprendidos durante el entrenamiento. Estos patrones ayudan al LLM a predecir lo que es más probable que suceda a continuación en el contexto de la indicación, aprovechando su comprensión de las relaciones y estructuras del lenguaje en el que se ha entrenado.

Dicho esto, la "comprensión" se refiere a relaciones, estructuras y patrones, y no hay pensamiento lógico. En el mejor de los casos, un LLM puede interpretar los datos que recibe e intentar pasarlos a otro software capaz de realizar cálculos reales. En un artículo reciente publicado por seis ingenieros de Apple (actualmente en fase de preimpresión), la supuesta capacidad de razonamiento se pone en tela de juicio por el hecho de que esos LLM tienen dificultades para responder a las preguntas según la forma en que están formuladas. Enel artículo, esos ingenieros escriben:

Nuestra hipótesis es que esta disminución se debe al hecho de que los modelos LLM actuales no son capaces de realizar un razonamiento lógico genuino; en cambio, intentan replicar los pasos de razonamiento observados en sus datos de entrenamiento. Cuando agregamos una sola cláusula que parece relevante para la pregunta, observamos caídas significativas en el rendimiento (hasta un 65 %) en todos los modelos de última generación, aunque la cláusula agregada no contribuya a la cadena de razonamiento necesaria para llegar a la respuesta final.

Dado que ya sabíamos que los modelos LLM no eran capaces de razonar, este es un resultado que no sorprende en gran medida, pero es un estudio de alto perfil que lo desglosa y lo demuestra por primera vez, al tiempo que explicapor qué. Como también afirma el artículo:"[a]unque los modelos LLM pueden coincidir con patrones de razonamiento más abstractos, no alcanzan el verdadero razonamiento lógico. Pequeños cambios en los tokens de entrada pueden alterar drásticamente los resultados del modelo, lo que indica un fuerte sesgo de token y sugiere que estos modelos son muy sensibles y frágiles".

Incluso el modelo o1 de OpenAI no es realmente un "razonamiento". La publicación del blog de OpenAI que anunciaba el o1 se titulaba "Aprender a razonar con LLM", pero es un razonamiento falso. Los modelos o1 utilizan "tokens de razonamiento", donde estos tokens descomponen la indicación y consideran múltiples enfoques para generar respuestas. Después de generar esos tokens de razonamiento, se produce la respuesta visible y los tokens de razonamiento se descartan.

Sin embargo, eso no quiere decir que no nos estemos acercando. Como se supo más tarde,o1 se conocía internamente como Q*, y luego como Strawberry. Este es el modelo que causó revuelo dentro de OpenAI y llevó a la destitución del CEO de la empresa, Sam Altman, aunque más tarde regresó. o1 es otro modelo que los ingenieros de Apple sugieren que puede no ser tan capaz de razonar como parece a primera vista, pero está claro que con la agitación interna en OpenAI hay una gran preocupación por el futuro de estos modelos, incluida su potencial capacidadrealpara razonar en el futuro.

3 fallas críticas que explican por qué la IA nunca estará a la altura de las expectativas

La IA tiene algunos grandes problemas que muy probablemente le impedirán estar a la altura de las expectativas.

Los LLM pueden ayudar con el razonamiento, pero nunca se debe confiar en ellos

Google lo hizo funcionar

El hecho de que un LLM no pueda razonar por sí solo no significa que no pueda influir en un proceso de razonamiento lógico. Simplemente no puede funcionar por sí solo. Google emparejó un LLM previamente entrenado con un evaluador automático para evitar alucinaciones e ideas incorrectas, al que llamóFunSearch. Es esencialmente un proceso de iteración que combina la creatividad de un LLM con algo que puede hacer que retroceda un paso cuando va demasiado lejos en la dirección equivocada. Los LLM no son buenos en matemáticas, pero son buenos en ser creativos.

FunSearch funciona tomando una descripción de un problema matemático en forma de código. Esta descripción proporciona un procedimiento para evaluar el resultado e inicializar un conjunto de programas. En cada iteración de FunSearch, el sistema seleccionará algunos de los programas y los enviará a un LLM, como PaLM 2, para construir nuevos programas sobre esa base. Se seleccionan los mejores para iterarlos, lo que crea un ciclo de automejora.

En este caso, FunSearch logró encontrar los conjuntos de límites más grandes que superaban con creces a los más conocidos por algunos de los matemáticos más inteligentes del mundo. "Hasta donde sabemos, esto demuestra el primer descubrimiento científico -una nueva pieza de conocimiento verificable sobre un problema científico notorio- utilizando un LLM",escribieron los investigadores en un artículo publicado enNature.

En otras palabras, la próxima vez que utilice un LLM, reduzca sus expectativas. No espere lógica ni pensamiento, perosípatrones, estadísticas y una pizca de creatividad. Los LLM son herramientas útiles, como lo demuestra Google, pero una herramienta es tan buena como el grado en que el usuario comprende sus limitaciones. Pregúntele a ChatGPTcómohacer una ecuación matemática y obtendrá una gran respuesta, pero no le pida que la haga por usted.