Resumen

- Los LLM especializados como StarCoder2 ofrecen eficiencia y rendimiento para tareas específicas sin el volumen de herramientas generales.

- Los modelos más pequeños, como el Vicuna-7B, se están volviendo más populares porque son más fáciles de implementar y consumen menos recursos.

- El futuro de la IA se inclina hacia títulos LLM precisos y especializados, como aquellos centrados en la codificación.

Los modelos de lenguaje de gran tamaño (LLM, por sus siglas en inglés) son herramientas poderosas, y ChatGPT, Microsoft Copilot y Google Gemini siempre me sorprenden. Sus capacidades son extensas, pero no están exentas de fallas. Las alucinaciones son un gran problema con los LLM como estos, aunque las empresas son conscientes de ellas e intentan eliminarlas siempre que sea posible. Sin embargo, no creo que estos modelos sean el futuro de los LLM. Creo que el futuro de la IA son los modelos más pequeños y especializados, en lugar de las herramientas de propósito general que son estos.

ChatGPT vs Microsoft Copilot vs Google Gemini: ¿Cuáles son las diferencias?

Si ha estado tratando de averiguar qué herramienta de IA generativa es mejor, ha llegado al lugar correcto.

Los LLM especializados tienen menos requisitos de hardware

Modelos más pequeños con menos parámetros

Imagina que eres una empresa y quieres implementar un LLM interno que pueda ayudar a tus desarrolladores con la codificación. Podríaspagarpor la gama completa de GPT-4 Turbo, con los costos que se generan por cada transacción...opodrías emplear Nvidia, Hugging Face y StarCoder2 LLM de ServiceNow. Es significativamente más pequeño, con solo 15 mil millones de parámetros, es gratuito (aparte de los costos que se generan al ejecutarlo localmente) y funciona muy bien en tareas de codificación.

Si vamos un paso más allá, existen otros LLM de codificación que están especializadossoloen codificación y que también puedes utilizar. Es posible que aún no sean totalmente capaces de hacer todo lo que GPT-4 puede hacer, pero el trabajo en esta área crece continuamente y, como estos modelos son tan pequeños, se pueden lograr muchas cosas buenas con ellos. Cuando se trata de modelos extra pequeños con 7 mil millones de parámetros (o incluso menos), hay incluso más opciones.

Por ejemplo, si bien no es un modelo de uso especializado, Vicuna-7B es un modelo que se puede ejecutar en un teléfono inteligente Android si tiene suficiente memoria RAM. Los modelos más pequeños son más portátiles y, si se centran en un solo tema, se pueden entrenar para que seanmejoresque los LLM más grandes y versátiles como ChatGPT, Microsoft Copilot o Gemini de Google.

Es menos costoso entrenar un modelo más grande

Es más fácil para las empresas construir sus propios

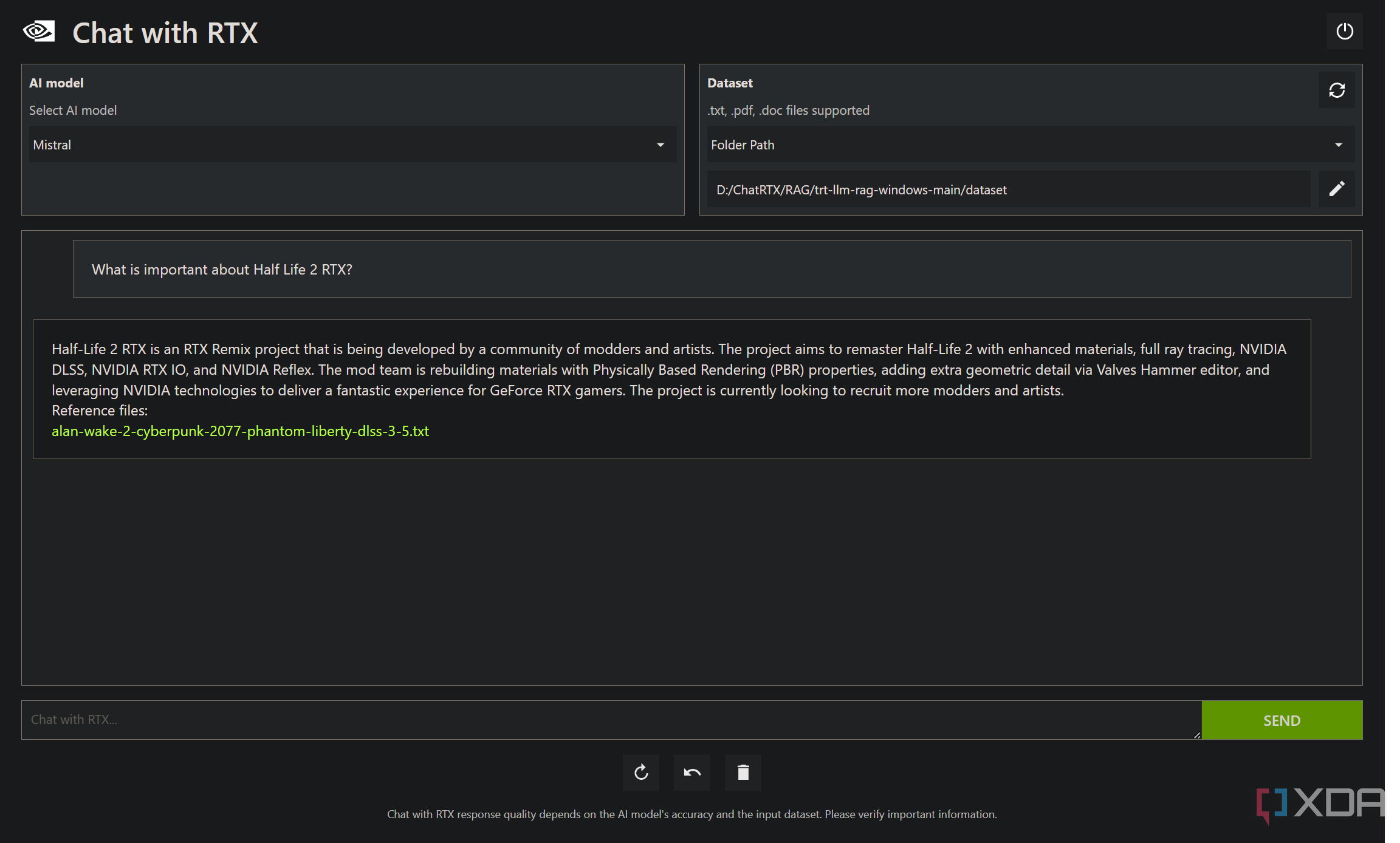

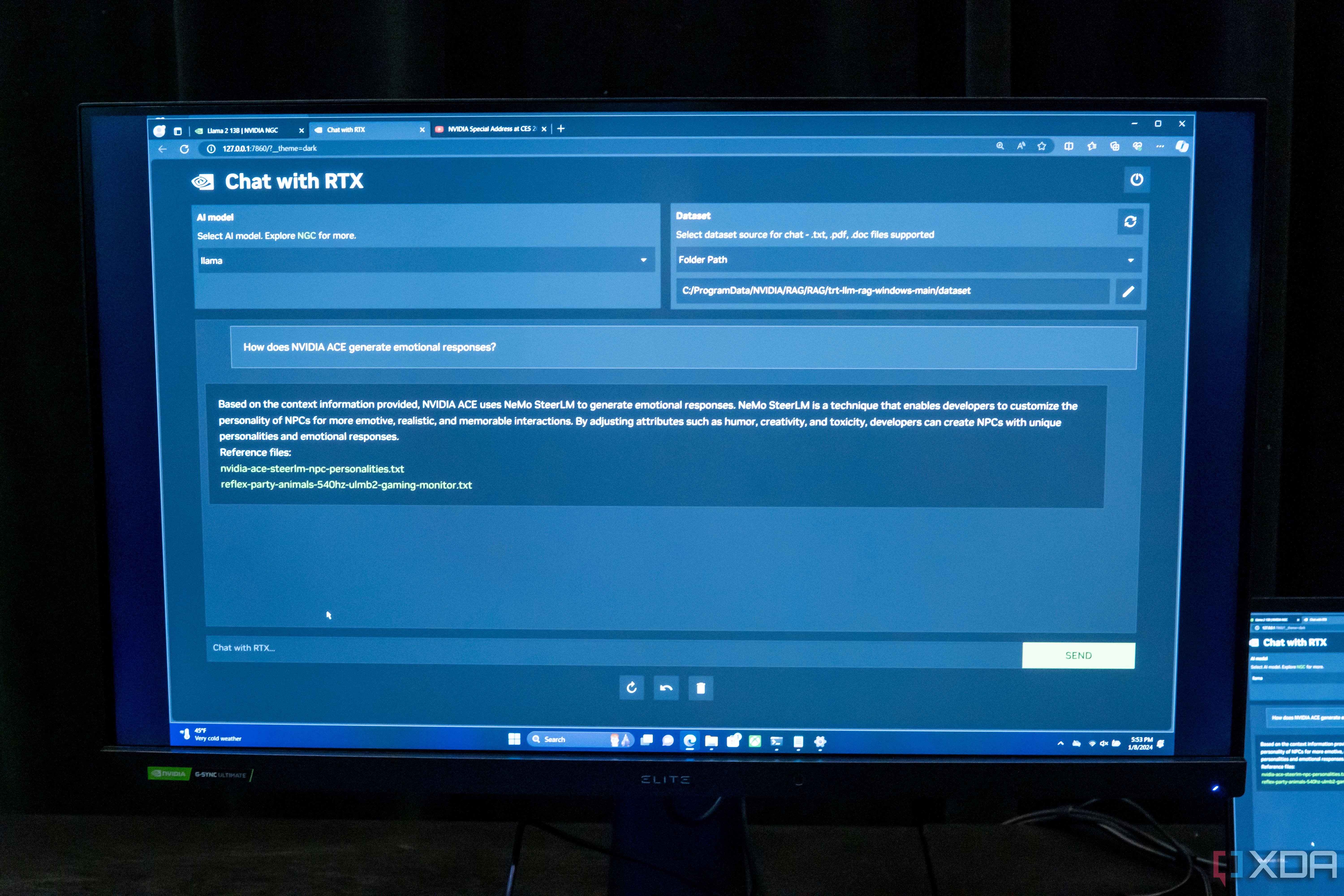

El otro beneficio de los modelos más pequeños es que hay muchos menos requisitos y prohibiciones de costos para las empresas más grandes que buscan construir su propio modelo de lenguaje. Con un conjunto de datos más pequeño e hiperenfocado en un puñado de temas, hay una barrera de entrada significativamente menor. Para llevar las cosas un paso más allá, Retrieval-Augmented Generation (RAG), como Chat with RTX de Nvidia, permite la implementación de un modelo de lenguaje más pequeño que ni siquiera necesita ser entrenado en ningún dato en particular. En cambio, puede simplemente extraer respuestas de la documentación e incluso decirle al usuario en qué documento exacto encontró la respuesta, solo para que el usuario pueda verificar que la respuesta es correcta.

Por lo tanto, si bien ChatGPT y otros tienen su lugar, es poco probable que esos modelos sean el futuro de la IA. Son de propósito general, pero si buscamos usar los LLM como herramienta, entonces esas herramientas deben ser expertas en las cosas para las que están entrenadas. GPT-4 nunca será experto en todo, pero un modelo de lenguaje creado para la codificación puede serlo. Además de eso, tampoconecesitasalgo tan poderoso como GPT-4 para muchas tareas, y es más barato y menos intensivo usar algo mucho más simple.

Como ejemplo, imaginemos un modelo de lenguaje que se utiliza para gestionar una casa inteligente. ¿Por qué ese modelo de lenguaje necesita tener parámetros llenos de información sobre programación? Si se implementara en la casa de alguien, un modelo de lenguaje así se podría entrenar con un conjunto de datos mucho más pequeño y con parámetros que sí son relevantes. Se podría convertir en un maestro de la gestión de casas inteligentes sin desperdiciar recursos valiosos en construir redes internas para temas que no son relevantes.

El Chat con RTX de Nvidia conectará un LLM con videos y documentos de YouTube localmente en tu PC

Nvidia está haciendo que sea aún más fácil ejecutar un LLM local con Chat con RTX, y también es bastante potente.

El futuro de la IA es especializado

Los LLM de propósito general todavía tienen su lugar

En general, los LLM de propósito general tendrán su lugar, pero el futuro de la IA de alto impacto está verdaderamente en el espacio más pequeño y especializado. Ya tenemos modelos de lenguaje más pequeños como Vicuna-7B capaces de ejecutarse en dispositivos que caben en nuestros bolsillos. Un modelo de 7 mil millones de parámetros es capaz de mucho cuando se especializa en un uso particular, y eso es exactamente hacia donde creo que se dirige la industria. StarCoder2 es un ejemplo de eso, y con RAG comenzando a despegar también, sospecho que veremos menos modelos pesados y muchos más modelos más pequeños pero precisos en su lugar.

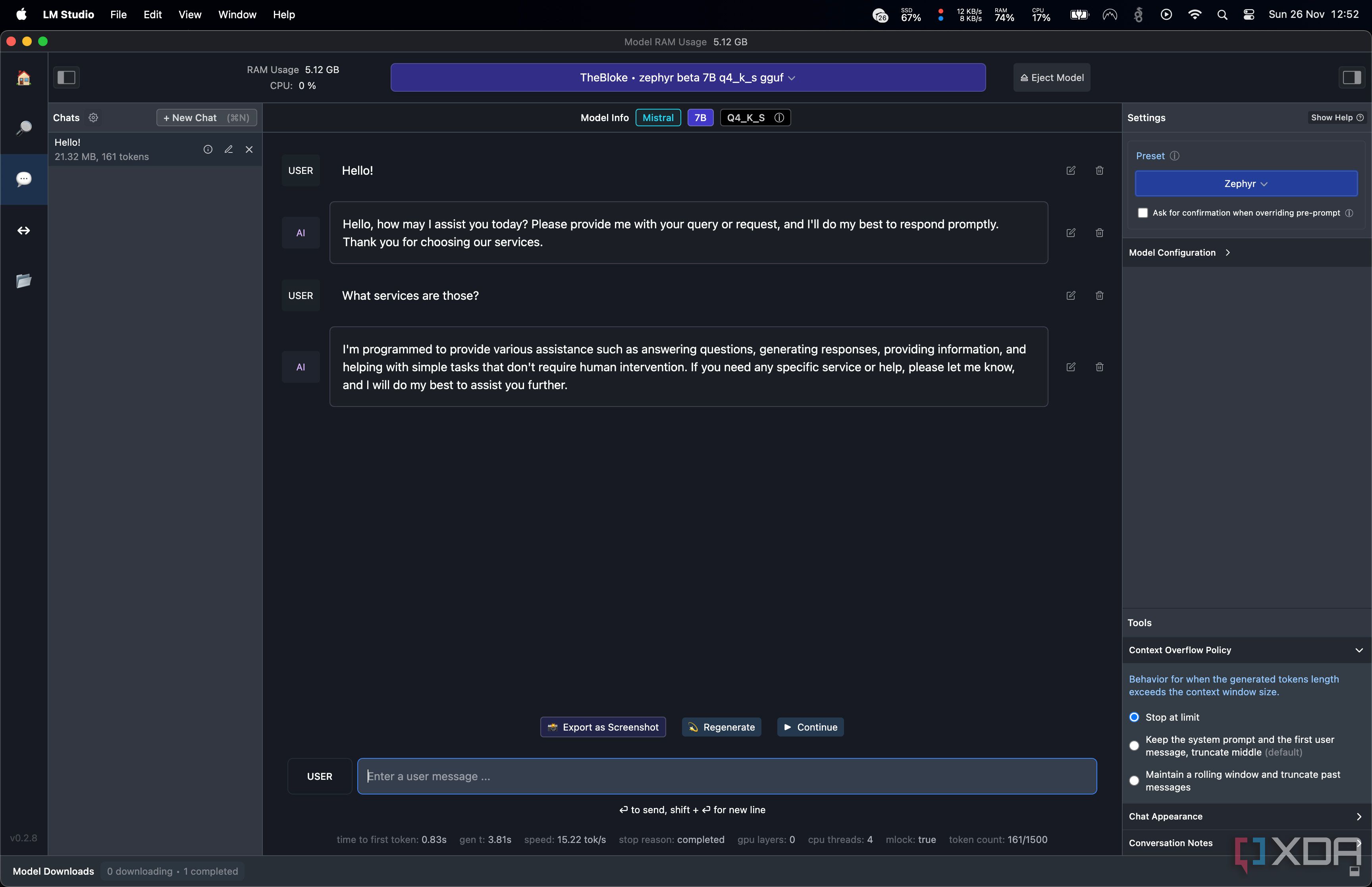

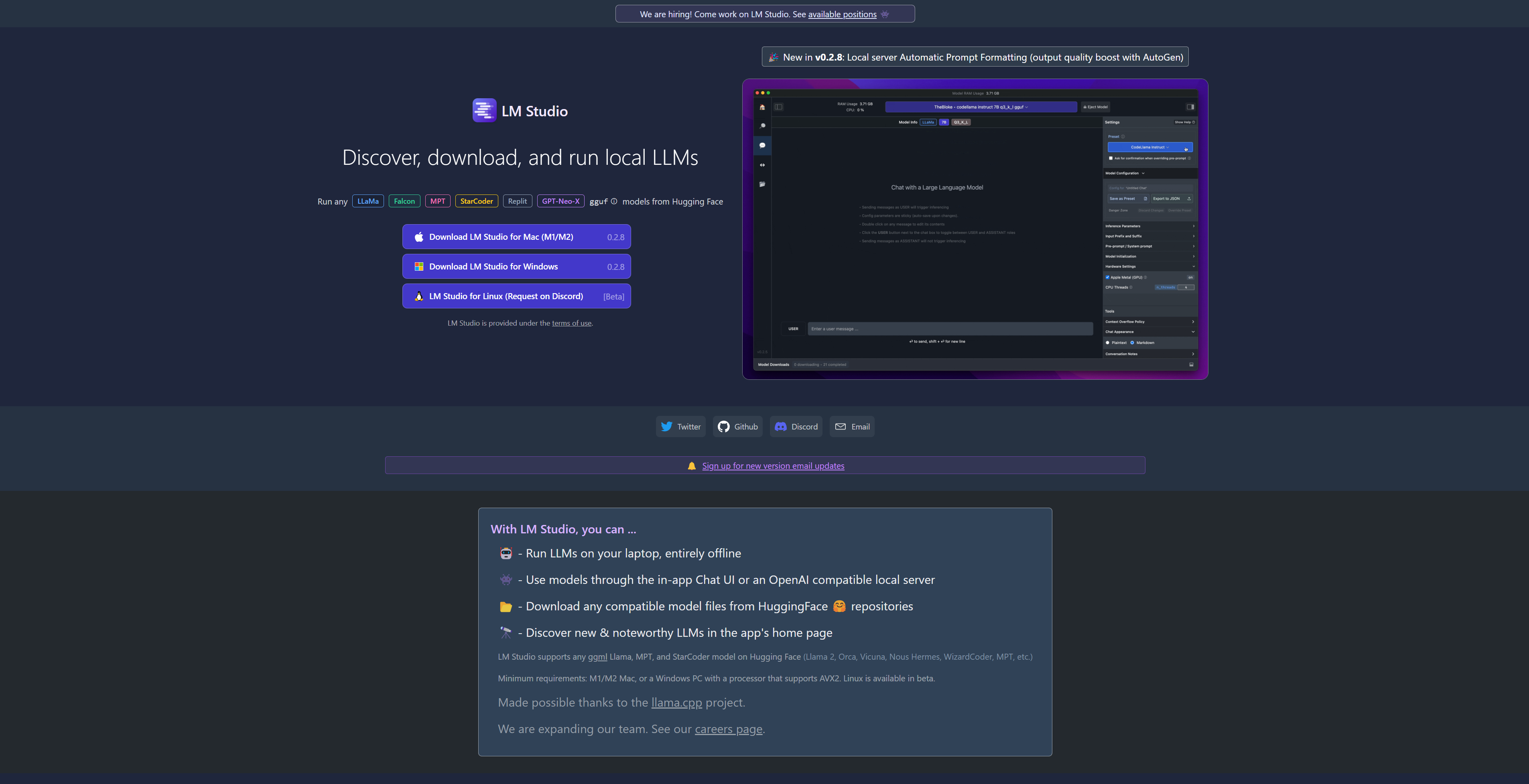

Si quieres probar algunos de esos LLM más pequeños, puedes usar herramientas como LM Studio y unaGPU potente. No es tan difícil de ejecutar siempre que tengas mucha vRAM, y hay muchos modelos especializados para todo tipo de usos que puedes probar. Hay algo para todos y, una vez que los hayas probado, comprenderás por qué el futuro de la IA serán estos modelos que cualquiera puede ejecutar, en cualquier lugar y en cualquier momento.

Ejecute LLM locales con facilidad en Mac y Windows gracias a LM Studio

Si desea ejecutar LLM en su PC o portátil, nunca ha sido más fácil hacerlo gracias al potente y gratuito LM Studio. Aquí le mostramos cómo usarlo