Resumen

- Probar varios modelos de IA para la generación de texto a video fue un desastre, y el resultado fueron imágenes inconsistentes y de mala calidad.

- Stable Video, Runway Gen 2 y Dream Machine de LumaLab no lograron producir resultados satisfactorios para el proyecto de cortometraje.

- Las herramientas impulsadas por IA pueden funcionar con equipos de primera línea y enfoques estilizados y animados, pero no son lo suficientemente buenas para lograr tomas realistas.

Cuando OpenAI mostró las capacidades de generación de texto a video deSoraa principios de este año, me quedé impresionado por los clips que el modelo de IA era capaz de crear. Hasta ese momento, me había costado pensar en escenarios de la vida real en los que necesitaría usar IA generativa. Pero las impresionantes capacidades de generación de video de Sora me llamaron la atención y me encontré vigilando regularmente la asombrosa construcción de IA de OpenAI. Verás, hacer películas siempre fue una de mis pasiones, que quedó relegada por mi obsesión con la tecnología.

Sora es el primer modelo verdadero de texto a video, pero no será el último

Sora es el primero y no será el último, especialmente si la historia sirve de referencia.

Así que hace unos días decidí dirigir mi primer cortometraje basado en IA, pero como la plataforma de generación de vídeo de última generación de OpenAI todavía no está disponible, tuve que buscar otras formas de crear el metraje. Como es de esperar, todo el proyecto estaba condenado al fracaso desde el principio y lo único que obtuve fueron vídeos a medio hacer que tenían mucha menos coherencia que losesquemas de nombres utilizados por los fabricantes de hardware.

Trabajando en el guión

Como quería que los modelos de IA generaran toda la película, tuve que idear un guion simple que pudiera convertir en indicaciones fácilmente comprensibles. Elegí el tema de la vida diaria de un hombre de unos 20 años. Quería darle mi propio toque al asunto, ya que cerca del final se revela que nuestro protagonista es una IA que hace todo lo posible por fingir ser un humano normal.

Sé que es un poco descarado para alguien que usa IA, pero como más del 90 % del metraje incluiría escenas de la vida cotidiana, los modelos de IA no deberían alucinar demasiado al crear los videos. O eso pensaba hasta que me sumergí de lleno en las herramientas de IA. Olvídate de grabar la narración/voces para la película, ni siquiera pude llegar a tres tomas sin que la IA arruinara algo. Diablos, terminé abandonando la idea después de horas de crear indicaciones que llevaron a resultados horrendos. Pero si te interesa mi desventura, aquí tienes una cronología de cómo sucedió todo:

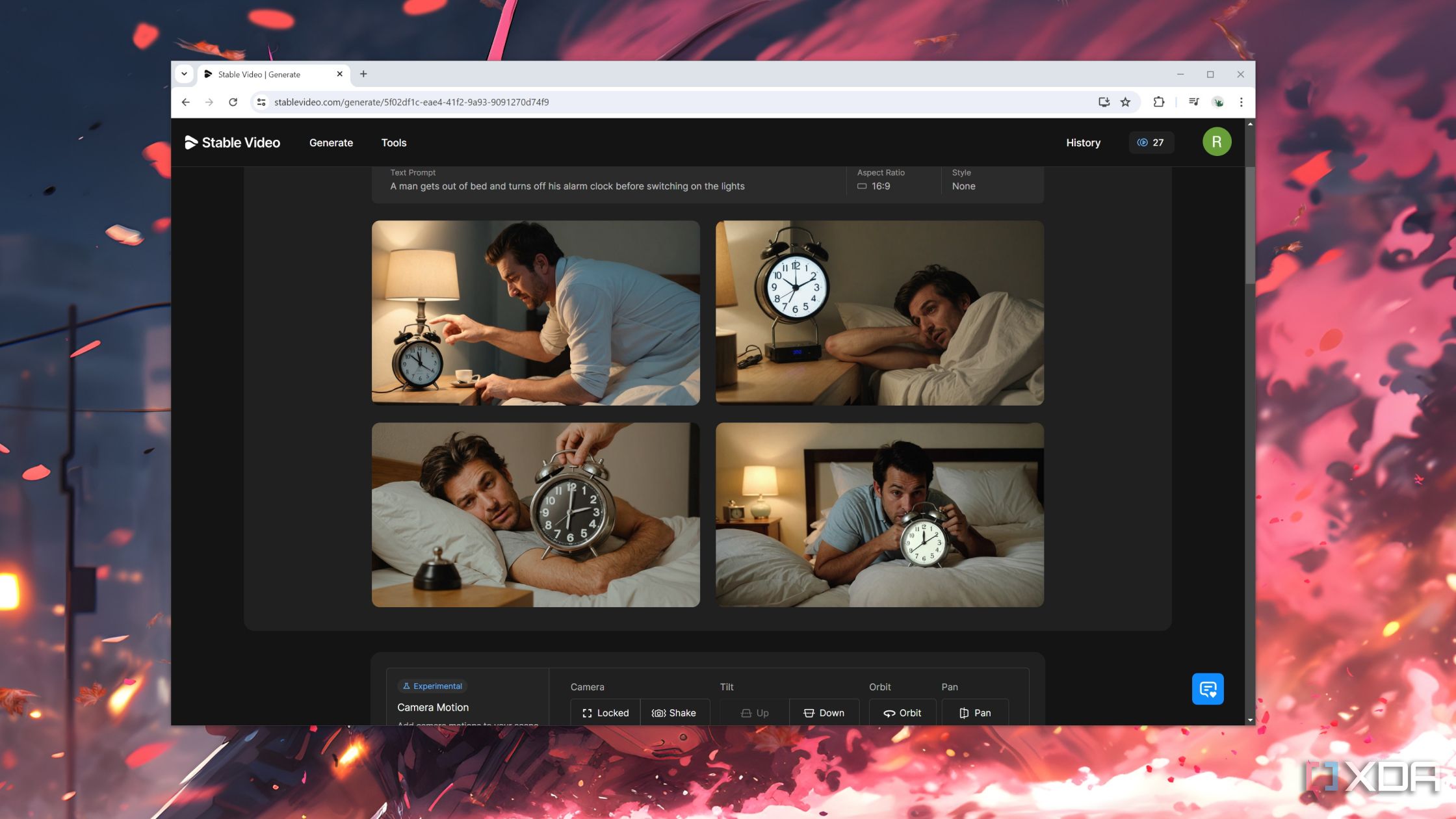

Stable Video produjo clips que parecían bastante reales

Pero el metraje no siguió en absoluto el guión.

Comencé con la función de conversión de texto a vídeo de Stable Video para crear el primer fotograma, que incluía a un hombre levantándose de la cama, apagando el despertador y encendiendo las luces. Para aquellos que no lo sepan, la opción de conversión de texto a vídeo de Stable Video genera primero un conjunto de imágenes. Una vez que eliges la imagen ideal, el modelo la usa como referencia para el resto del clip. Al final, mi mensaje fue demasiado para que Stable Video lo comprendiera, ya que ninguna de las tres imágenes se acercaba ni remotamente a lo que tenía en mente.

Pero opté por el que parecía más o menos correcto y lo utilicé para generar el vídeo. Lo que obtuve fue un clip de un hombre murmurando en voz baja mientras apartaba la mano del despertador, lo cual ni siquiera encajaba con el contenido del guion.

Acorté el mensaje y repetí el procedimiento, pero el resultado seguía siendo el mismo. Por eso, decidí cambiar un poco las cosas para mi próximo intento. En lugar de usar Stable Video para generar tanto la imagen como el metraje, dividí la carga de trabajo usando otro modelo de IA para crear una imagen de referencia que se ajustara más a lo que quería.

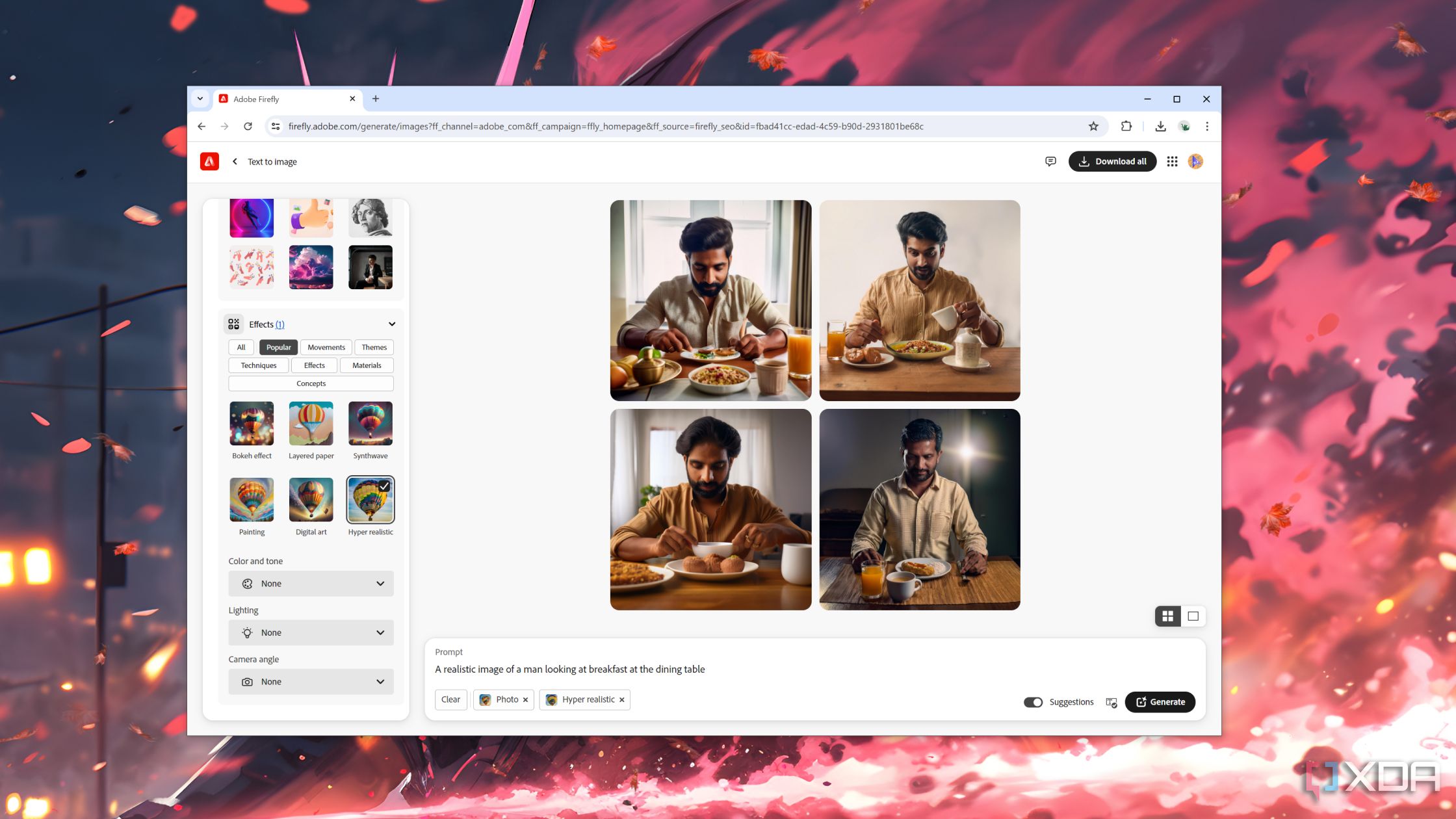

Los resultados fueron un poco mejores al utilizar Adobe Firefly y Stable Video

Sin embargo, me encontré con un problema importante después de generar la primera escena.

Como ya me había suscrito aCreative Cloudde Adobe , utilicé Firefly para generar la imagen para Stable Video. Esta vez, di una indicación concisa y seleccioné los filtros necesarios para darle a la imagen un aspecto más realista. Después de un par de intentos, Firefly logró crear una imagen que solo puedo describir como adecuada.

Le envié esta imagen a Stable Video y lo único que hizo fue mover la cámara. Sin embargo, finalmente terminé la primera toma de la película y me topé con un gran obstáculo: asegurarme de que el mismo personaje apareciera en todas las escenas.

Como en la segunda toma aparecía un hombre desayunando, generé algunas indicaciones que lo mostraban comiendo en la mesa del comedor. En las primeras dos imágenes, Firefly creó un hombre (diferente) mirando a la cámara, por lo que tuve que modificar la indicación para crear un escenario algo realista. Pero el protagonista de la escena anterior no seveíapor ningún lado . Después de varios intentos, finalmente obtuve una imagen en la que el tipo se parecía un poco a nuestro protagonista y la subí a Stable Video.

Lamentablemente, Stable Video destrozó la animación y, cerca del final del clip, la cara del personaje parecía sacada de una película de terror de bajo presupuesto. Otra cosa que vale la pena mencionar es que Stable Video utiliza créditos para generar videos y, a esta altura, yo ya había agotado todos los míos. Así que esperé otro día antes de subir otras imágenes de Firefly al modelo de IA.

La transición a la siguiente escena siempre fue un problema y, una vez que intenté generar clips con otro personaje en la toma, las cosas se vinieron abajo rápidamente y terminé abandonando el proyecto después de quedarme sin créditos una vez más. Por lo tanto, era hora de buscar otras alternativas.

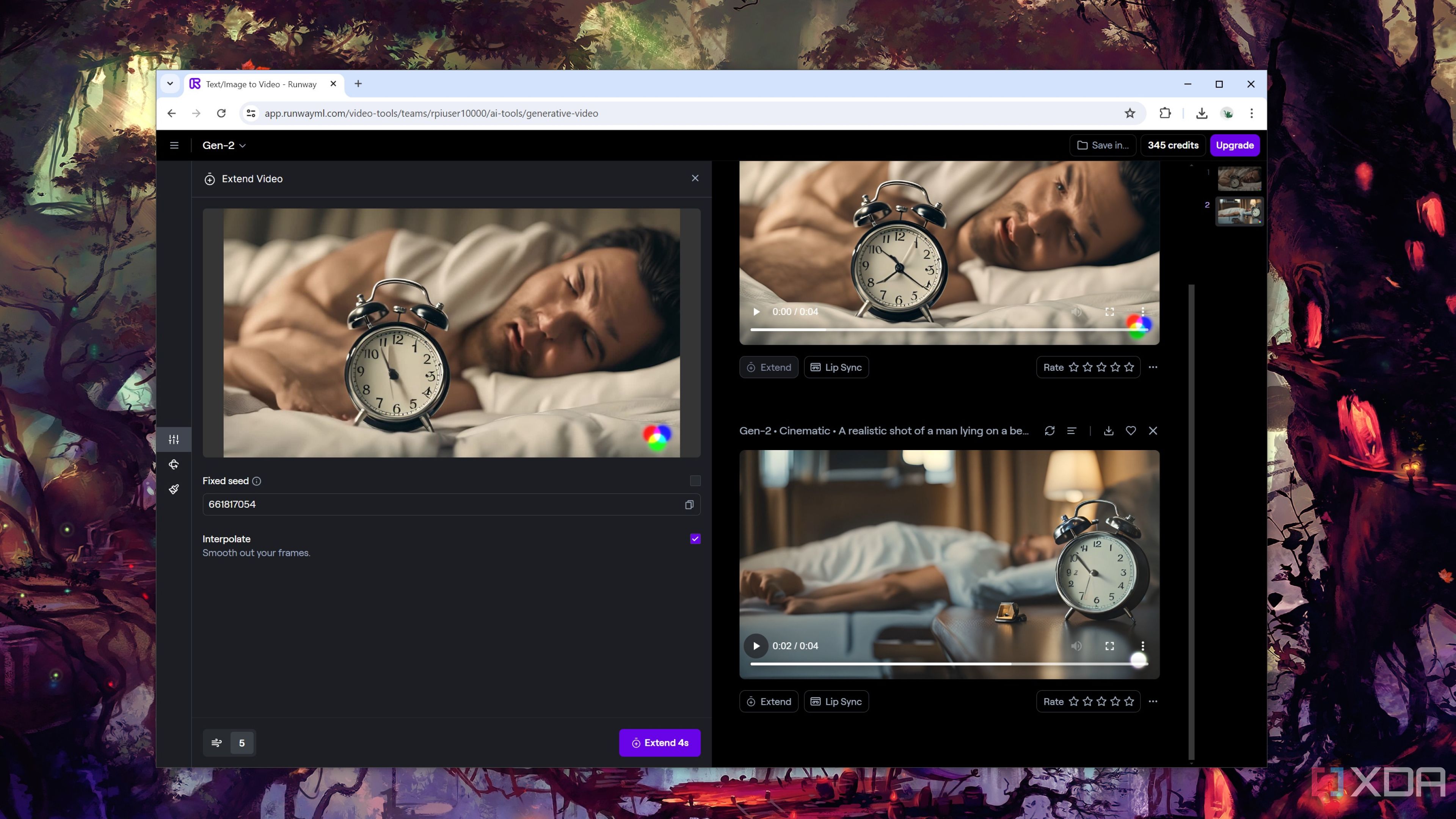

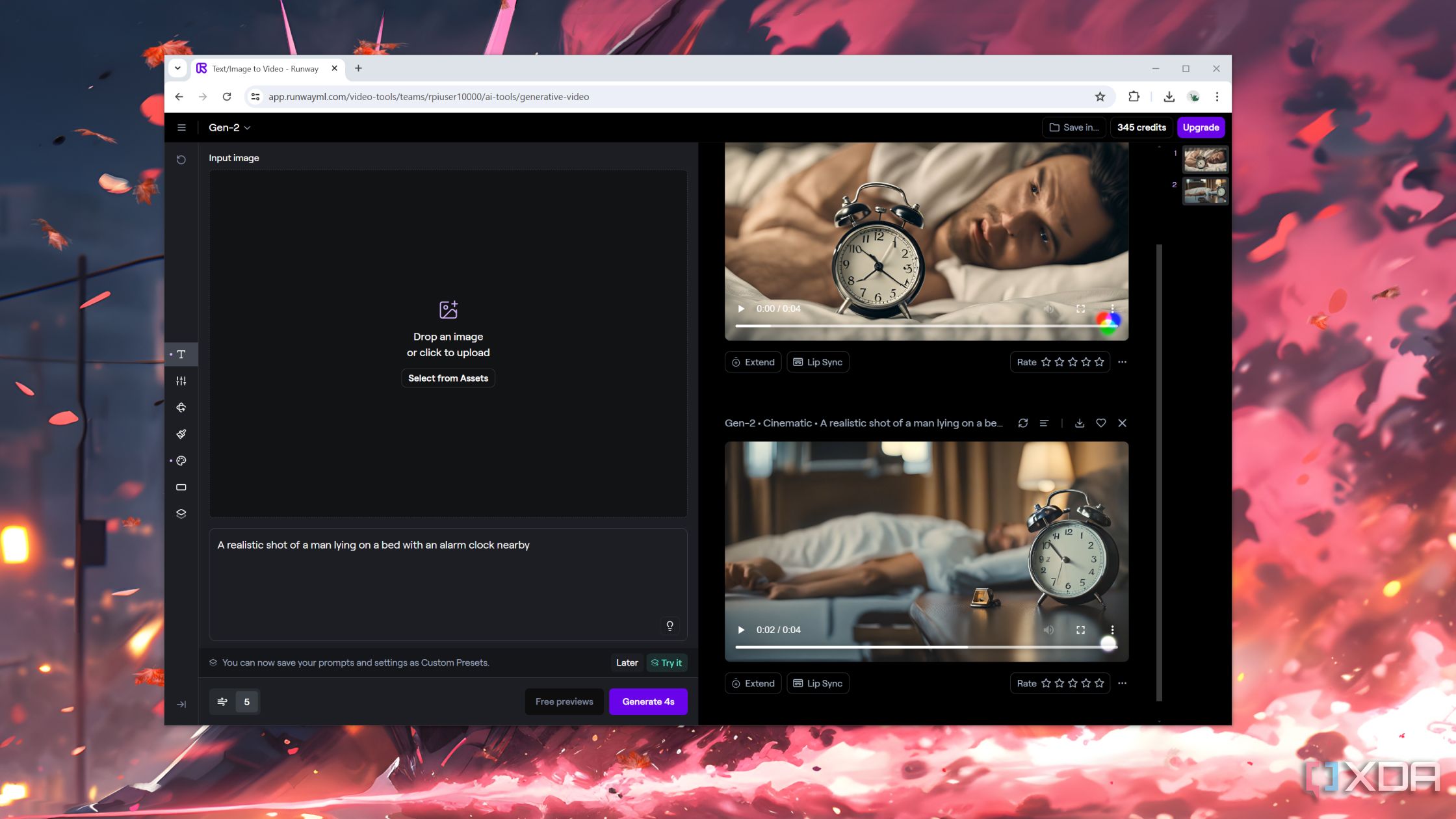

Runway Gen 2 produjo resultados mixtos

Al menos tiene tiempos de carga más rápidos.

Como Stable Video no logró producir nada decente, centré mi atención en Runway Gen 2. En lugar de usar directamente las imágenes que creé con Firefly, opté por generar tanto la foto de referencia como el video en Runway ML y, bueno, esto es lo que obtuve.

Entonces, volví a esa decisión y envié la imagen de Firefly a Runway ML. Lamentablemente, los videos fueron incluso peores que la última vez, e incluso después de crear cinco clips diferentes con otras imágenes de referencia, no pude completar el segundo fotograma del cortometraje. El problema se agravó aún más una vez que se agregó la falta de consistencia de Firefly al crear las imágenes. El único clip decente que obtuve fue de nuestro personaje principal escribiendo algo en su cuaderno para la escena cuatro.

Sin embargo, no todo estaba perdido, ya que había un modelo que aún no había utilizado: la Dream Machine de LumaLab.

La máquina de los sueños creó contenido que alimenta las pesadillas

También fue una prueba de paciencia, en más de un sentido.

Una de las mejores características de Dream Machine de LumaLabs es que te permite crear clips de cinco segundos y extenderlos aún más usando más indicaciones. En teoría, esto debería evitar que el modelo de IA cambie la cara del protagonista en cada toma. La palabra clave aquí esteóricamente, porque, en la práctica, Dream Machine me dio más dolores de cabeza de todas las aplicaciones que había probado hasta ahora.

Una vez más, comencé con el primer mensaje de un hombre que se despertaba y apagaba un despertador. Después de ingresar el mensaje en la barra de búsqueda, esperé más de una hora antes de recibir los primeros cinco segundos del video. Dejando de lado las expresiones extrañas del hombre, el primer clip fue sorprendentemente decente y me emocioné un poco de que el proyecto finalmente despegara.

Sin embargo, todo se vino abajo después de hacer clic en el botón Extender e ingresar el segundo mensaje sobre el protagonista levantándose de la cama y dirigiéndose hacia la puerta. Después de esperar lo que pareció una eternidad, todo lo que obtuve fue esta monstruosidad:

Intenté generar el resto del metraje, pero mis otros intentos fracasaron de manera igual de espectacular, lo que me obligó a terminar el final de la película. Desafortunadamente, la escena en la que el protagonista se recuesta y se inserta un cable USB en el cuello no se pudo crear porque Firefly no logró generar la imagen correcta ni siquiera después de 20 intentos. Como puedes adivinar, las herramientas de generación de texto a video produjeron abominaciones absolutas cuando les permití generar tanto la imagen de referencia como el video para la secuencia final. Dicho esto, me quité el sombrero de director mientras me reía de lo absurdo de las tomas de mi cortometraje.

Pasará mucho tiempo antes de que la IA asuma algún trabajo en el ámbito cinematográfico.

A pesar de que el proyecto terminó en un fracaso rotundo, aprendí un par de cosas. Por un lado, las herramientas impulsadas por IA como Stable Video pueden producir resultados bastante decentes si les proporcionas imágenes de referencia de generadores de texto a imagen decentes. Además, hacer una panorámica y hacer zoom en la foto es mucho mejor que pedirle al modelo generativo que anime o agregue movimiento a un personaje. En el caso de los modelos de IA actuales, también debes recordar que no podrás usar el mismo personaje en más de un video.

Por supuesto, tampoco estoy descartando por completo la IA. Incluso en su estado actual, podría funcionar si tienes una PC de alta gama que ejecute el mejor generador de imágenes con tecnologíaStable Diffusionjunto con las versiones pagas de las aplicaciones que usé. En retrospectiva, tampoco debería haber apuntado a una película realista para empezar. En cambio, debería haber optado por clips animados y estilizados con diferentes personajes y un par de imágenes fijas para hacer la transición entre cada toma.

Pero ese es un proyecto para otro momento. Por ahora, estoy perfectamente satisfecho con componer secuencias de personas y editarlas con After Effects y DaVinci Resolve.

A pesar de todo el bombo publicitario, la IA no ha cambiado mi vida

Para la mayoría de las personas, dudo que la IA generativa haya tenido un impacto real en sus vidas.