Enlaces rápidos

Resumen

- Las tarjetas gráficas son hardware especializado diseñado para el procesamiento paralelo en tareas como la representación de gráficos y la investigación científica.

- Los componentes clave de una tarjeta gráfica incluyen el núcleo de la GPU, la memoria de la GPU, el VRM, las interfaces de pantalla y el sistema de refrigeración.

- Las GPU modernas tienen arquitecturas avanzadas que permiten un procesamiento eficiente, incluida una arquitectura de sombreado unificada, canalización de instrucciones, jerarquía de caché y paralelismo de múltiples niveles.

Para entender cómo funciona unatarjeta gráfica, es fundamental profundizar en los componentes y procesos que permiten a estos dispositivos reproducir imágenes, vídeos y animaciones en nuestras pantallas. Una tarjeta gráfica, a menudo denominada GPU (unidad de procesamiento gráfico), es un hardware especializado diseñado para acelerar la creación y la reproducción de imágenes, vídeos y animaciones. Funciona de forma diferente a laCPU (unidad central de procesamiento), y se destaca en el procesamiento en paralelo. Esto es clave para tareas como la reproducción de gráficos y otros cálculos que requieren el manejo de muchas operaciones a la vez.

3 razones por las que 2023 fue una decepción colosal para las tarjetas gráficas

Se suponía que 2023 traería un soplo de aire fresco después de la crisis de las GPU. Trajo algo nuevo, pero no lo que esperábamos

Componentes principales de una tarjeta gráfica

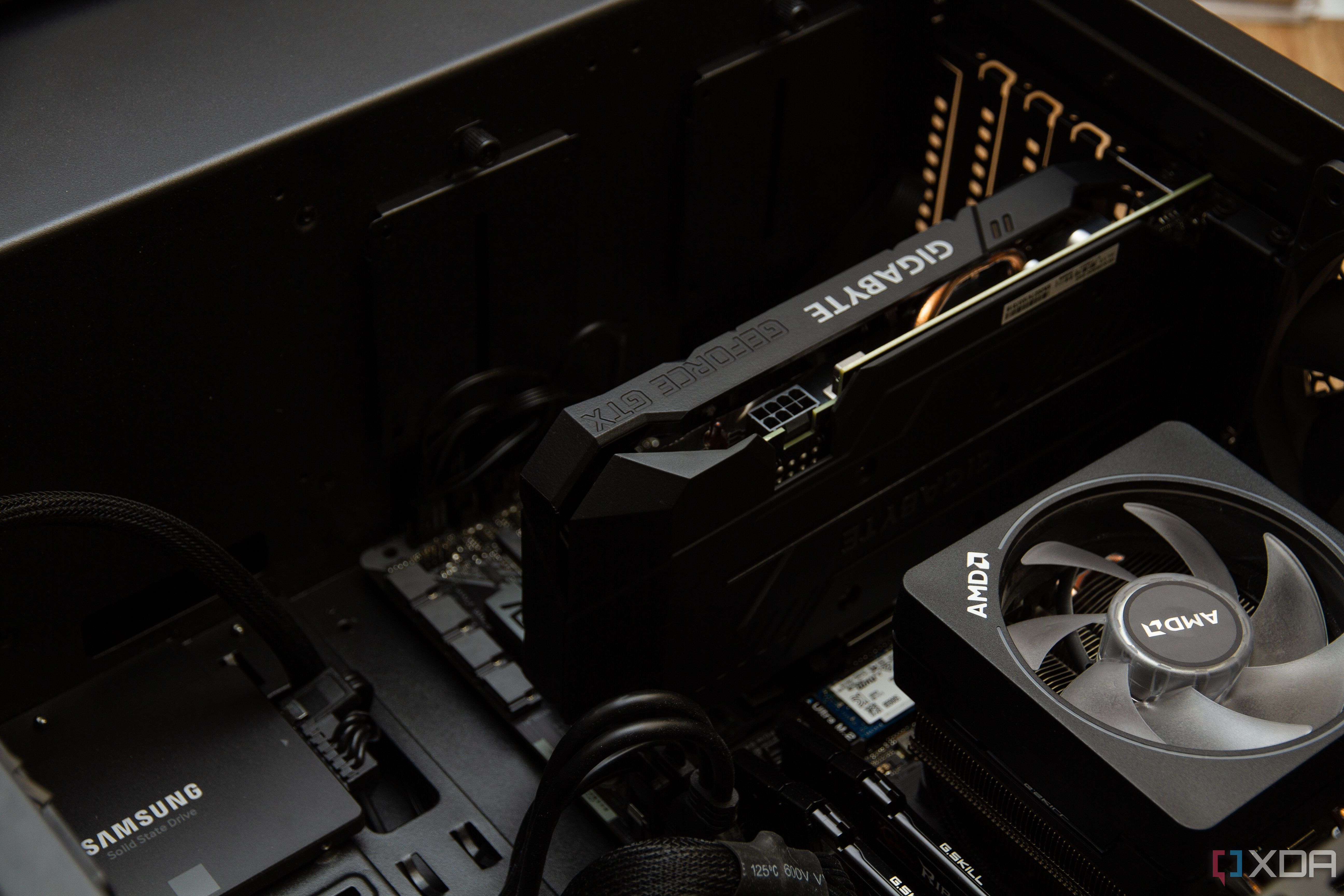

Una tarjeta gráfica es un componente esencial del hardware de cualquier ordenador, sin el cual la salida de imágenes sería imposible. Convierte los datos de la CPU en imágenes que se pueden visualizar en el monitor. El rendimiento y las capacidades de una tarjeta gráfica dependen en gran medida de sus componentes principales, que son:

- Núcleo de la GPU (unidad de procesamiento gráfico):en el núcleo de cada tarjeta gráfica, la GPU es un procesador dedicado optimizado para acelerar la representación de gráficos. Con su capacidad para procesar miles de operaciones simultáneamente, la GPU se destaca en tareas que requieren procesamiento en paralelo. Esto la hace indispensable no solo para juegos y aplicaciones visuales, sino también para tareas computacionales específicas en áreas como la investigación científica y el aprendizaje automático.

- Memoria GPU:Las tarjetas gráficas están equipadas con un tipo de memoria especializada, conocida como RAM de video (VRAM), que está optimizada para satisfacer las demandas de alta velocidad y gran ancho de banda del procesamiento y la representación de imágenes. La VRAM se utiliza para almacenar texturas, búferes de cuadros y otros datos esenciales necesarios para la representación de imágenes, lo que contribuye directamente a la velocidad y la calidad de los gráficos producidos.

- VRM:Para satisfacer sus altos consumos de energía, las tarjetas gráficas de gama alta suelen requerir más energía de la que puede suministrar la placa base. Esto genera la necesidad de conexiones de alimentación directas desde la fuente de alimentación (PSU) del ordenador a través de uno o más conectores dedicados de 8 pines. La PSU proporciona la energía adicional a través de un riel de 12 V que luego se convierte en el ~1 V requerido por la matriz de la GPU, así como en varios otros voltajes necesarios para componentes como la memoria de la tarjeta. Esta conversión la gestiona el módulo de regulación de voltaje (VRM).

- Interfaces de visualización:El objetivo principal de las tarjetas gráficas es enviar las imágenes renderizadas a dispositivos de visualización. Están equipadas con varias interfaces de salida, como puertos HDMI, DisplayPort, DVI y VGA. Estas interfaces permiten la conectividad con una amplia gama de dispositivos de visualización, incluidos monitores, televisores y proyectores, lo que satisface diferentes necesidades y garantiza la compatibilidad con varias tecnologías de visualización.

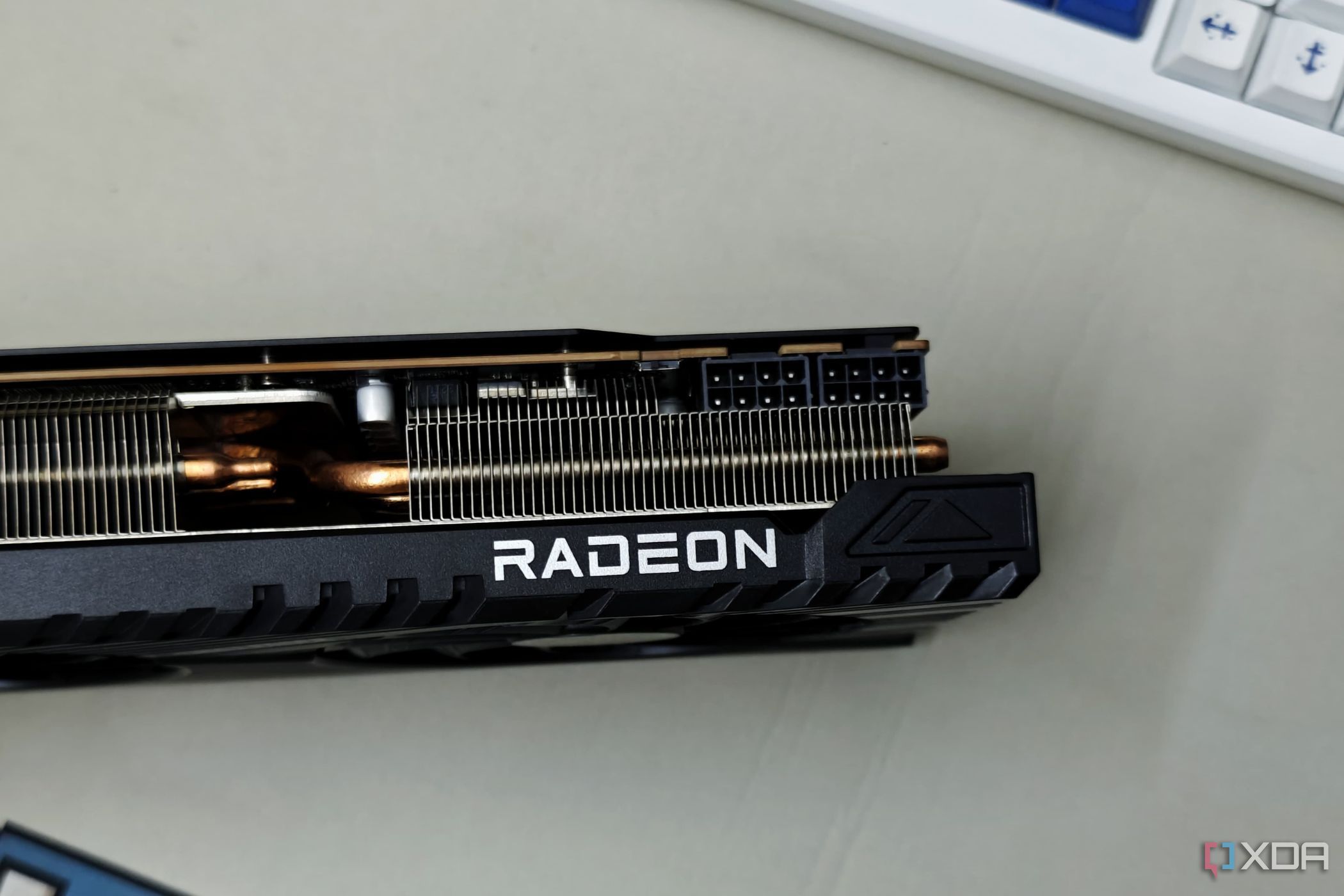

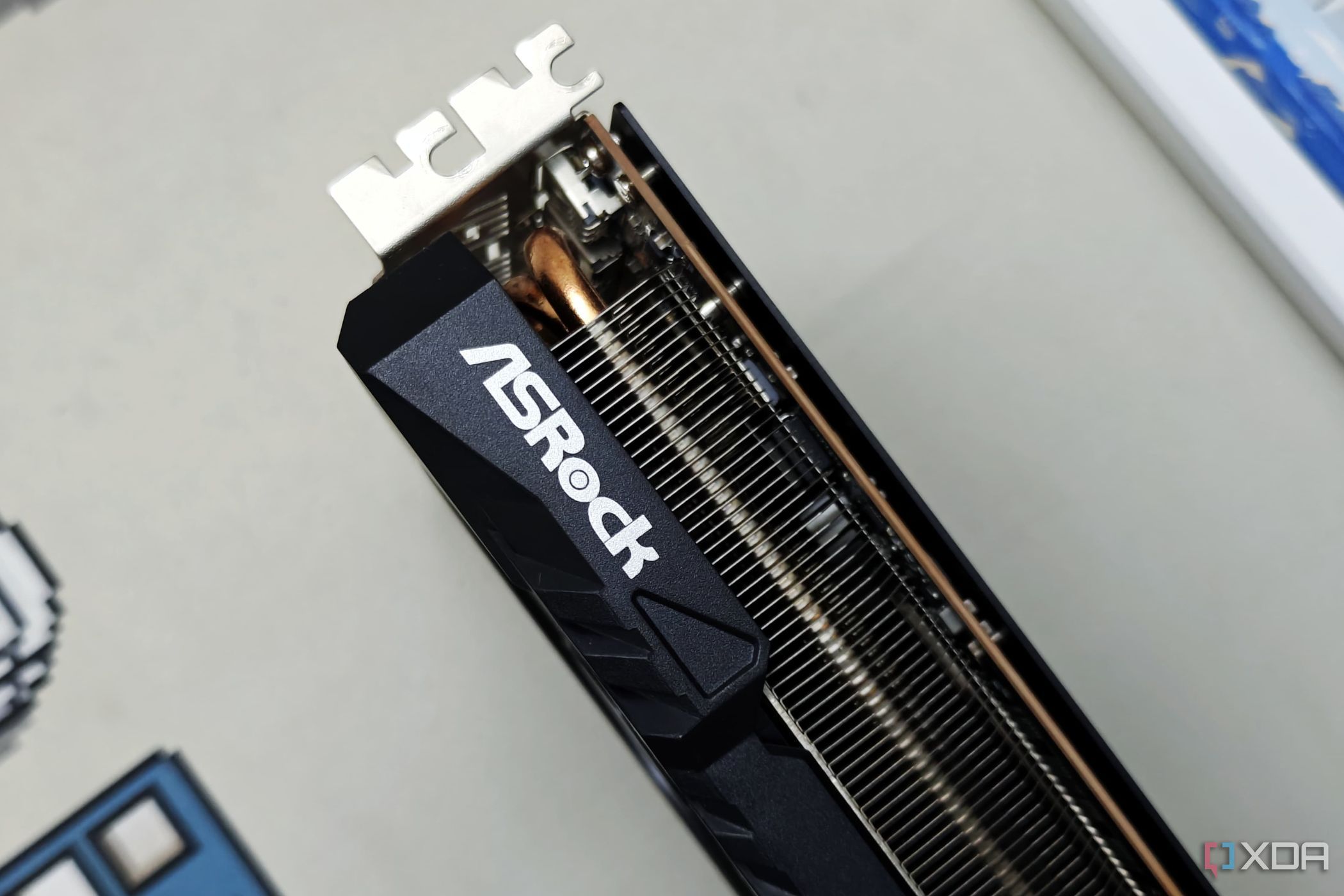

- Refrigeración:Las tarjetas gráficas de alto rendimiento generan una cantidad considerable de calor debido a sus intensas tareas de procesamiento. Para contrarrestar esto, se utiliza un sistema de refrigeración robusto, que puede incluir disipadores de calor para disipar el calor, ventiladores para hacer circular el aire y, en algunos casos, soluciones de refrigeración líquida. Estos sistemas funcionan en conjunto para garantizar que la GPU funcione dentro de rangos de temperatura seguros, manteniendo así el rendimiento y la longevidad.

¿Cuáles son los componentes del núcleo de la unidad de procesamiento gráfico (GPU)?

El núcleo de la GPU es el cerebro de todo el funcionamiento gráfico de su PC y hay algunos componentes clave de la GPU que lo ayudan a realizar su trabajo con éxito.

- Los procesadores de flujo o núcleos CUDAson las unidades de trabajo funcionales dentro de un núcleo de GPU, dedicadas a realizar las operaciones de sombreado FP32 y el trabajo computacional requerido para la representación de gráficos y otras tareas de procesamiento en paralelo. La abundancia de procesadores de flujo o núcleos CUDA (según la GPU) permite que la GPU maneje múltiples operaciones simultáneamente. Cuanto mayor sea la cantidad de estos núcleos, más rápida será la GPU.

- Interfaz de memoria:el ancho de banda de la memoria de la GPU determina la velocidad de transferencia de datos entre el núcleo de la GPU y la VRAM. Esto depende de dos factores: el ancho de la interfaz de memoria (bits) y la velocidad de transferencia de la VRAM (medida en Gbps). El ancho de banda, que se mide en GB/s, se calcula multiplicando el ancho del bus por la velocidad de transferencia y luego dividiéndolo por 8 bits por byte. Por ejemplo, una GPU con un ancho de bus de 320 bits y una velocidad de transferencia de la VRAM de 14 Gbps produce un ancho de banda de 560 GB/s.

- ROP (Raster Operations Pipelines) y TMU (Texture Mapping Units):los ROP desempeñan un papel muy importante en la producción de la salida de píxeles final en la pantalla, ejecutando tareas como el antialiasing para mejorar la calidad de la imagen. Las TMU, por otro lado, son responsables de aplicar texturas a los modelos 3D. Ambos componentes son vitales para lograr efectos visuales de alta calidad y un rendimiento de renderizado, lo que contribuye significativamente a la experiencia visual general.

- Núcleos RT:estas unidades dedicadas aceleran las tareas de trazado de rayos en tiempo real, como el recorrido de la jerarquía de volúmenes delimitadores y las intersecciones de rayos y triángulos. Al delegar estos cálculos específicos en hardware especializado, las GPU logran una reducción significativa de la carga para la representación de efectos de iluminación complejos.

- Núcleos Tensor:especializados para acelerar las multiplicaciones de matrices, estos núcleos son cruciales en el aprendizaje profundo y los cálculos de redes neuronales. Aprovechan la computación de precisión mixta para mejorar el rendimiento al tiempo que incorporan mecanismos (FP16 para el cálculo, FP32 para la acumulación) para aumentar el rendimiento sin sacrificar la precisión para garantizar la precisión.

La arquitectura avanzada de las GPU modernas

- Arquitectura de sombreado unificada:las GPU modernas adoptan una arquitectura de sombreado unificada. Este marco flexible permite que las mismas unidades de sombreado procesen varios tipos de sombreadores, ya sean de vértices, píxeles o geometría. Los sombreadores se adaptan a la tarea en cuestión. Esta adaptabilidad aumenta la eficiencia de procesamiento.

- Instruction pipelining and parallelism:At the heart of a GPU's speed and efficiency is its ability to execute multiple instructions simultaneously through instruction pipelining. This method layers the execution stages, keeping each core active and engaged, speeding up data processing and rendering times.

- Cache hierarchy and memory management:Effective memory management is important to maintain a GPU's performance. With a proper cache hierarchy, including L1 and L2 caches, GPUs minimize latency and make efficient use of bandwidth. This design ensures quick access to frequently used data, which ensures smooth rendering.

- Multi-Level Parallelism:By using parallelism in multiple layers, hardware, thread, and instruction, GPUs achieve a level of efficiency that's unparalleled. This multi-tiered approach allows for a large number of operations to be conducted in unison.

- SIMD and SIMT Architectures:The concepts of SIMD (Single Instruction, Multiple Data) and SIMT (Single Instruction, Multiple Threads) are central to a GPU's capability to process multiple data points or threads simultaneously. This is especially effective for vector operations.

- Execution Units and Warp Scheduling:The way GPUs manage threads and execution units is through something called warp schedulers. These schedulers organize threads into groups known as warps or wavefronts (depending on your GPU). These schedulers ensure that each execution unit is utilized efficiently.

- Register files and shared memory:The inclusion of expansive register files and shared memory within each compute unit provides a fast, accessible storage solution for threads. This design facilitates swift variable access and inter-thread communication, cutting down on the need for global memory access and, thereby, enhancing processing speeds.

- Asynchronous compute engines: The integration of asynchronous compute engines in some GPUs allows for the simultaneous execution of graphics and compute tasks. This dual-processing capability is especially crucial in applications requiring complex simulations alongside graphics rendering, providing a more streamlined and efficient use of resources.

How do memory architecture and optimization work on a GPU?

The memory interface width (e.g., 256-bit, 384-bit) and the type ofVRAMused (GDDR6X, GDDR7, HBM) are critical factors in determining the GPU's memory bandwidth. Higher bandwidth enables faster data transfer rates between the GPU and memory, is crucial for high-resolution textures, detailed 3D models, and complex scenes. GDDR7 and HBM2E memory technologies stand out for their innovative approaches to increasing bandwidth and reducing latency. Here’s how these technologies are shaping the future of graphics memory:

- GDDR6X and GDDR7: GDDR6X introduced PAM4 (Pulse Amplitude Modulation with 4 levels) signaling, effectively doubling the data rate per pin compared to the NRZ (Non-Return to Zero) signaling used by earlier versions. This was tailored to meet the increasing demands for high-resolution gaming and intricate graphic rendering. However, taking a new direction, GDDR7 shifts to PAM3 (3 signal levels) signaling. This change positions PAM3 as an intermediary between the complexity of PAM4 and the simplicity of NRZ, optimizing for both speed and signal integrity, as well as enhancing power efficiency. Samsung's GDDR7 DRAM, as the industry's first, promises unprecedented performance with speeds up to 37Gbps per pin on a 384-bit bus reaching a bandwidth of 1.8 terabytes-per-second (TBps)—a substantial improvement over GDDR6’s 1.0TBps. Additionally, it introduces a 20% improvement in energy efficiency and significantly reduces heat generation.

- HBM2E Memory:HBM2E (High Bandwidth Memory 2E) takes a different approach by stacking memory dies vertically and utilizing a wide interface, connected by through-silicon vias (TSVs), and placing them on the same package as the GPU. This design reduces the physical distance data must travel, drastically increasing bandwidth and reducing power consumption. This structure significantly increases bandwidth by providing a direct pathway for data to travel between the memory and the GPU, making it especially beneficial for applications that handle vast amounts of data.

- Cache coherency and memory compression: As GPUs grow faster, efficient cache management becomes increasingly crucial. Modern GPUs tackle this challenge with advanced cache coherency protocols, ensuring that data across all cache levels remains consistent and quickly accessible. This coherency is critical for multithreaded operations where the same data might be accessed and modified by different processes simultaneously. Additionally, memory compression techniques optimize data transfer by compressing the data before it moves between the GPU and memory. These algorithms significantly reduce the bandwidth needed for data transfer, enhancing overall performance while also conserving power.

- Challenges in Cache coherency:Ensuring cache coherency across a GPU's complex memory hierarchy presents significant challenges. With multiple cores accessing and modifying shared data, maintaining a consistent state across all caches is essential to prevent data corruption and performance degradation. GPUs address these challenges through sophisticated cache coherency protocols like MOESI (Modified, Owner, Exclusive, Shared, Invalid) that manage the state of data in caches, ensuring consistency and minimizing latency. Implementing these protocols requires careful balancing to avoid overhead that could negate the benefits of coherency.

- Data Compression Algorithms in GPUs: Data compression plays a vital role in optimizing the bandwidth and storage efficiency of GPUs. Techniques like delta color compression (DCC) and block compression (BC) are commonly used. DCC works by storing only the differences in color values between adjacent pixels rather than the full-color data, which is particularly effective for images with gradual color changes. BC, on the other hand, compresses blocks of pixels into smaller data sets based on similar patterns and colors. These algorithms reduce the amount of data that needs to be transferred and stored, significantly improving performance and reducing power consumption.

Semiconductor Fabrication and Process Nodes

The architecture of modern GPUs showcases the advancements in semiconductor manufacturing processes and microarchitecture design, resulting in the development of specialized processing units for specific tasks. This evolution reflects a continuous effort to balance performance, power efficiency, and thermal management.

Semiconductor manufacturing processes

The foundation of today's GPU performance lies in the semiconductor manufacturing process, often quantified in nanometers (nm). As the industry has moved to smaller process nodes from 7nm, 5nm, and now approaching 3nm, the potential for packing more transistors into the same die space has surged. This miniaturization boosts both performance and energy efficiency while mitigating heat production. Two major developments in transistor design, FinFET (Fin Field-Effect Transistor) and the more recent GAAFET (Gate-All-Around Field-Effect Transistor) have been instrumental in these developments. They enhance control over the transistor's channel, diminishing leakage current and improving switching performance.

While the shrinkage of process nodes brings about significant advantages, it's not without its complications. As we push the boundaries of miniaturization, yield issues become more prominent, and manufacturing complexities escalate. The precision required for developing chips at these scales introduces a higher probability of defects, which can affect the overall yield of viable chips from each wafer.

Microarchitecture Design: The Role of SMs and CUs

At the microarchitectural level, GPUs are organized into Streaming Multiprocessors (SMs) and Compute Units (CUs), which are clusters of cores executing instructions in tandem. The architecture of each SM/CU is balanced to optimize throughput for a wide array of tasks. An easy fix for this situation would be to just increase the core density, but that brings on issues with power efficiency. The trade-off between increasing the number of cores for parallel processing and managing the resultant rise in power consumption and heat is a critical consideration. Achieving an optimal performance-per-watt ratio is a primary goal for GPU architects. The efficiency of executing threads in groups, which is known as warps in NVIDIA and wavefronts in AMD, is crucial for maximizing core utilization. GPUs use scheduling algorithms to adapt dynamically to varying demands, enhancing overall efficiency.

Parallel processing & Compute shaders

Parallelism is achieved through an architectural design vastly different from that of traditional CPUs. GPUs differentiate themselves by their architecture, featuring thousands of smaller, efficient cores designed for parallel processing, as opposed to CPUs, which are optimized for sequential execution with a far lower number of cores. This design enables GPUs to handle numerous tasks simultaneously, making them ideally suited for applications requiring high computational power. The GPU cores operate in a multithreaded manner, allowing for the simultaneous processing of multiple data streams. This is particularly effective for tasks that can be broken down into smaller, independent tasks, such as pixel or vertex processing in graphics rendering, or parallelizable computations in scientific research.

How does a GPU work: Rendering pipeline

- Application Stage:The journey begins with the CPU preparing and sending instructions along with 3D scene data (comprising geometric shapes, usually triangles or polygons, and textures) to the GPU. This stage sets the groundwork for rendering by defining the objects and their properties within the scene.

- Vertex Processing:At this stage, vertex shaders process each vertex's attributes, such as position, color, and texture coordinates. The vertices are transformed from their original 3D space (world space) to a 2D projection on the screen (screen space) through a series of transformations. Lighting calculations are also performed to determine how light sources within the scene affect the color and brightness of vertices.

- Tessellation: An optional but powerful stage in GPUs that dynamically adds detail to objects based on the viewer's distance. It subdivides coarse mesh into finer polygons, enabling higher visual fidelity without excessively burdening the GPU with complex models that are far away and less noticeable.

- Geometry Shading:This stage allows for the manipulation of geometry. Geometry shaders can add or modify vertices and primitives (the basic shapes that form 3D models), enabling effects like an explosion, grass swaying in the wind, or even the generation of complex shapes on the fly without burdening the CPU.

- Rasterization:A conversion process that transforms the 3D geometric representations into pixels (or fragments) on a 2D screen. It determines which pixels on the screen are covered by each primitive, preparing them for further processing. This stage also involves clipping, where only the parts of the scene within the camera's view are processed.

- Fragment Processing:Also known as pixel shading, this stage calculates the final color of each pixel by applying textures, shading effects, and lighting models. Advanced effects like bump mapping, reflections, shadows, and transparency are applied here, significantly contributing to the realism of the scene.

- Output Merger:The concluding stage of the pipeline, where all the processed fragments are combined to form the final image. It resolves which fragments are visible (through depth testing) and how they blend with others (alpha blending), producing the pixels that will be displayed on the screen. Throughout these stages, the GPU employs parallel processing, allowing vast numbers of vertices and pixels to be processed simultaneously.

- Enhanced realism: Utilizing RT cores, GPUs can now trace the paths of individual light rays in real time, allowing for the creation of highly realistic images with accurate shadows, reflections, and refractions. This method mimics the physical properties of light, significantly enhancing the visual quality of 3D environments.

- Global Illumination:Complementing real-time ray tracing, global illumination algorithms simulate the complex behavior of light as it bounces off multiple surfaces before reaching the observer. This technique adds depth and realism to scenes by accurately portraying how light diffuses across different materials and textures.

- Tensor Cores:Specialized Tensor Cores expedite matrix operations, crucial in deep learning and AI applications. By performing mixed-precision arithmetic, these cores enable rapid computation and efficient power usage, which is important for processing large neural networks and other AI models.

- Deep Learning Super Sampling (DLSS): DLSS employs AI to intelligently upscale lower-resolution images in real time. This process allows for smoother frame rates and enhanced visual quality, showcasing how AI can revolutionize rendering techniques by optimizing performance without compromising on image detail.

- Raster Operations Pipelines (ROPs): ROPs are critical in the final image composition. They manage the last stage of rendering, where fragment shader outputs are merged, depth and stencil testing are conducted, and the final pixel values are written to the frame buffer. Operations like blending and anti-aliasing are handled here, ensuring the visual output is both accurate and aesthetically pleasing.

- Texture Mapping Units (TMUs):TMUs are responsible for applying textures to the 3D models, a process that involves filtering and mapping texture data onto the surfaces of objects. This stage is vital for adding detail and realism to the scene, as textures give objects their color, appearance, and surface qualities.

Additional features

- Adaptive Shading:This technology optimizes rendering workload by varying shading rates across different areas of the scene, focusing on processing power where it's most needed. This can lead to performance improvements without noticeable loss in visual quality.

- Mesh Shading:A newer approach that allows the GPU to more efficiently process large amounts of geometry. By offloading complex culling and geometry processing tasks to the GPU, mesh shading can significantly improve performance in scenes with dense geometric detail.

- Variable Rate Shading (VRS):VRS allows GPUs to allocate varying amounts of shading resources to different areas of the frame based on their visual complexity or importance, optimizing performance by reducing the detail in less noticeable areas.

Software and algorithmic optimizations

El hardware no explica por completo el proceso completo del funcionamiento interno de una GPU. El resultado que se ve en la pantalla proviene de la sinergia entre el hardware y el software.

API de gráficos y lenguajes de sombreado

DirectX 12, Vulkan y CUDA:estas API proporcionan acceso de bajo nivel a los recursos de la GPU, lo que permite a los desarrolladores crear código altamente optimizado que aprovecha todo el potencial de la GPU. DirectX 12 y Vulkan, en particular, ofrecen un control detallado de los recursos de hardware, lo que facilita una ejecución más eficiente de las tareas de gráficos y computación. CUDA, si bien se centra en las GPU NVIDIA, proporciona un amplio conjunto de herramientas y bibliotecas de programación diseñadas específicamente para aplicaciones aceleradas por GPU.

Bibliotecas y marcos de computación paralela

- CUDA y OpenCL: CUDA (Compute Unified Device Architecture) es la plataforma de computación paralela y el modelo de programación de NVIDIA que extiende la potencia de sus GPU a la computación de propósito general. Permite a los desarrolladores utilizar C, C++ y Fortran para desarrollar software que pueda ejecutarse en las GPU de NVIDIA. OpenCL (Open Computing Language) es un estándar abierto para la programación paralela multiplataforma de diversos procesadores que se encuentran en computadoras personales, servidores, dispositivos móviles y plataformas integradas. OpenCL proporciona un marco para escribir programas que se ejecutan en plataformas heterogéneas, incluidas CPU, GPU, DSP (procesadores de señal digital) y más.

- TensorFlow y otras bibliotecas: TensorFlow es una biblioteca de aprendizaje automático de código abierto desarrollada por Google, que puede aprovechar las GPU para acelerar el entrenamiento y la inferencia de redes neuronales. Considera las complejidades de la computación paralela, lo que facilita a los desarrolladores la implementación y el escalado de modelos de aprendizaje automático. Otras bibliotecas y marcos, como PyTorch y CNTK de Microsoft, también admiten la aceleración de GPU, lo que aumenta aún más el acceso a recursos informáticos de alto rendimiento para la investigación y el desarrollo de IA.

Uniendo las cosas

La versatilidad de las GPU se ha expandido significativamente, lo que ha impactado en el aprendizaje automático, la computación científica y más allá. Diseñadas originalmente para acelerar los gráficos 3D, las GPU ahora desempeñan un papel crucial en el aprendizaje profundo al paralelizar de manera eficiente las multiplicaciones de matrices y reducir significativamente los tiempos de entrenamiento de las redes neuronales. Los avances tecnológicos recientes han introducido funciones como eltrazado de rayosen tiempo real para una iluminación realista en los gráficos y optimizaciones impulsadas por IA para tareas como el aumento de escala de imágenes y la reducción de ruido. Esta evolución subraya la transición de la GPU de una unidad centrada en los gráficos a un procesador multifacético que impulsa avances en varios campos, incluida la inteligencia artificial y la investigación científica, lo que destaca su papel esencial en la computación moderna.