Resumen

- El Proyecto Astra de Google fue un gran foco de atención en Google I/O 2024, pero puede que no supere al GPT-4o de OpenAI.

- El Proyecto Astra tiene características interesantes como memoria y minijuegos, pero OpenAI está a la vanguardia en el desarrollo de interfaces de IA multimodales.

- Si bien el Proyecto Astra mostró potencial en una demostración, es posible que aún necesite más trabajo y tiempo para competir con GPT-4o.

La inteligencia artificial fue el foco principal de Google I/O 2024, y Google incluso se burló de sí mismo al contar la cantidad de veces que dijo "IA" en la presentación (121). De las innumerables funciones de IA que se anunciaron en Google I/O, la más importante fueProject Astra. Es una interfaz de IA multimodal con la que puedes interactuar mediante visión y audio. Vimos una demostración pregrabada de lo que Project Astra puede hacer durante la presentación de Google I/O, pero pasé unos 10 minutos con Project Astra en acción después. Mi conclusión fue esta: Project Astra se ve realmente genial, pero dudo que vaya a reemplazar al Asistente de Google o incluso al clásico Gemini enlos teléfonos Androiden un futuro cercano.

Google ha estado intentando ponerse al día en la carrera de la IA desde el principio, y eso sigue siendo así en este caso. Hace apenas unos días, OpenAI presentó GPT-4o, un nuevo modelo de IA multimodal que puede gestionar entradas simultáneas de visión, audio y texto. Si bien la funcionalidad multimodal aún no está completamente implementada en ChatGPT, el conjunto de características principales del modelo y las mejoras de velocidad ya están disponibles en ChatGPT y las API. Aunque todavía no he pasado tiempo práctico con GPT-4o y su interfaz multimodal, sospecho firmemente que el modelo de OpenAI está por delante del Proyecto Astra de Google.

¿Qué es GPT-4o? Todo lo que necesitas saber sobre el nuevo modelo OpenAI que todos pueden usar de forma gratuita

Se acaba de anunciar GPT-4o, un sucesor más rápido y mejor de GPT-4 Turbo que todo el mundo puede usar. ¡Aquí tienes todo lo que necesitas saber!

Lo que aprendí de mi demostración del Proyecto Astra

El Proyecto Astra parece limitado por ahora y podría pasar un tiempo antes de que se implemente

La versión demo de Project Astra viene en dos variantes: un Pixel 8 Pro con Astra y una pantalla táctil grande con cámara superior y micrófono con Astra. Google me dijo que no había ningún hardware especial en la unidad de demostración más grande; era básicamente una versión ampliada de cómo se vería Project Astra ejecutándose en un teléfono inteligente. Hay al menos tres formas de interactuar con Project Astra: a través de la pantalla táctil, con el micrófono y la voz, y a través de la señal de la cámara.

La parte más interesante de la demostración fue la versión "libre" de Project Astra, donde se puede interactuar con la interfaz de IA de forma casual y conversacional. Project Astra tiene memoria y, a partir de ahora, puede recordar cosas que ve y escucha durante un minuto. Por ejemplo, cuando se le muestran animales de peluche y después de que le dicen sus nombres, Project Astra puede identificar qué raza de perro está sobre la mesa y recordar su nombre. Un representante de Google dijo que la memoria de IA es algo que sus equipos de investigación están explorando, pero agregó que la memoria de Project Astra probablemente podría ampliarse aún más para recordar más cosas.

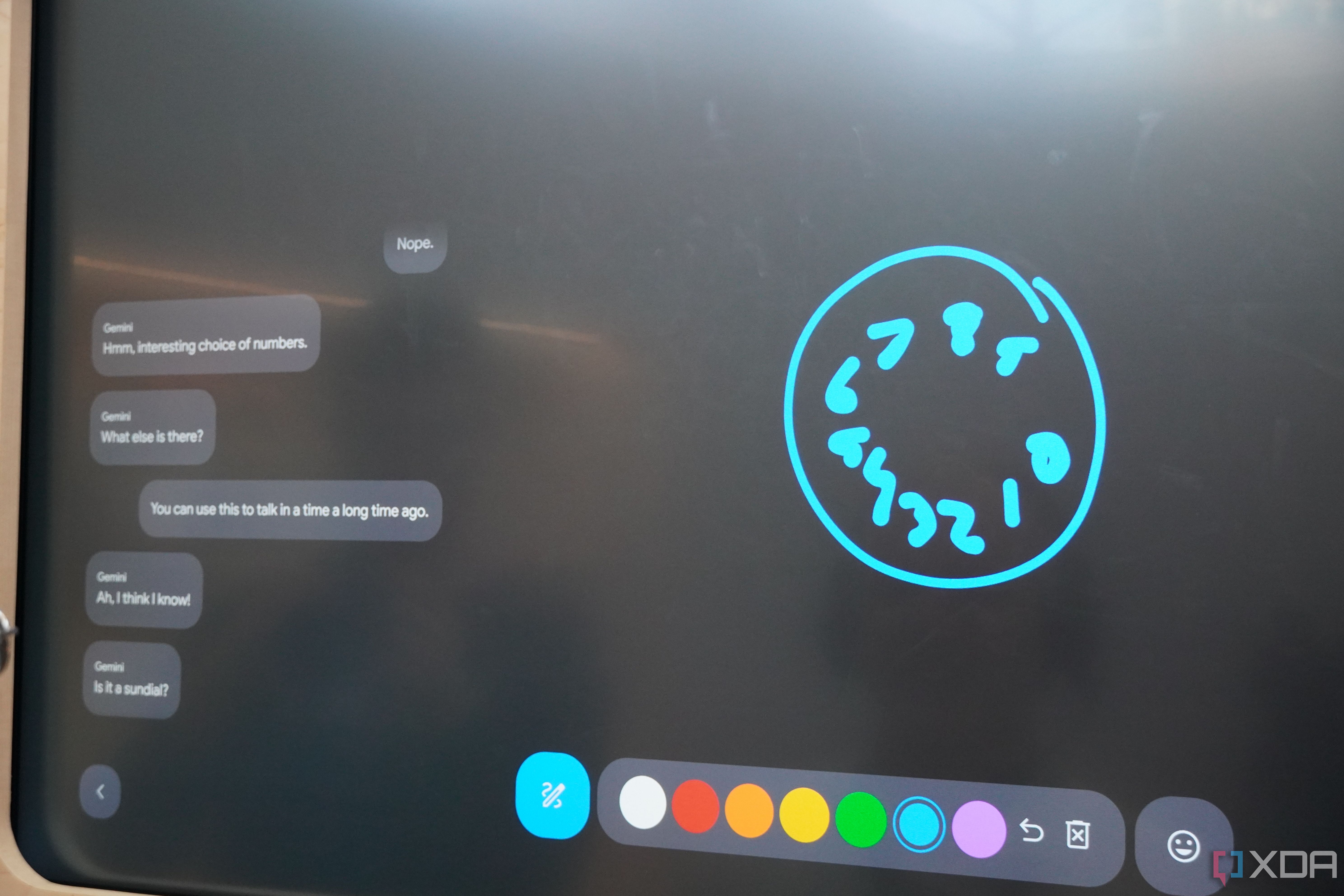

Además del componente de forma libre, la demostración de Project Astra incluyó algunos minijuegos para mostrar lo que puede hacer la interfaz de IA multimodal. Uno de ellos era Pictionary, que era como jugar al clásico juego con IA. Después de dibujar algo en la pantalla táctil, Project Astra intentaba adivinar de qué se trataba y siempre lo hacía bien. Project Astra no lo reconocía de inmediato todas las veces, pero utilizaba la conversación con el jugador de Pictionary para averiguarlo. En una ocasión, Project Astra nombró correctamente la película en la que se basaba un dibujo de Pictionary después de recibir instrucciones de audio. Fue el ejemplo perfecto de IA multimodal: utilizó la visión para detectar el dibujo, el audio para recibir instrucciones del usuario y su base de conocimientos para hacer coincidir ese dibujo con la historia de una película.

Otras demostraciones que vi incluyeron aliteración, que creaba una historia basada en los objetos que podía ver usando aliteración, y narración, que creaba una historia completa sobre lo que podía ver en el cuadro.

La experiencia completa habría sido impresionante en un vacío, pero parecía mucho menos innovadora que la GPT-4o de OpenAI o incluso la demostración pregrabada del Proyecto Astra de Google. En el video a continuación, puede ver lo que Google mostró que hacía el Proyecto Astra en la presentación de Google I/O. Era una interfaz de IA completa con un montón de conocimiento, e incluso podía detectar líneas de código y decirle al usuario exactamente lo que debía hacer.

Decir que no fue así como se utilizó Project Astra en la demostración práctica sería quedarse corto. Algunas cosas eran iguales, como los elementos de comparación visual y el componente de aliteración. Pero las partes realmente innovadoras de Project Astra (como la capacidad de nombrar y explicar partes específicas de un altavoz o diseccionar líneas de código) no formaban parte de la demostración.

¿Cómo se compara con GPT-4o?

OpenAI mostró con confianza más funciones funcionales que Google

Parece que cada nueva función de IA tiene estos casos de uso ambiciosos, pero que cuando se lanzan realmente resultan decepcionantes. Por eso, dudo en decir que GPT-4o definitivamente será mejor que Project Astra. Por ejemplo, el tiempo de respuesta de Project Astra en la demostración parecía estar a la par con el tiempo de respuesta de GPT-4o. Sin embargo, puedo decir que parece que OpenAI está por delante de Google en el desarrollo de interfaces de IA multimodales.

Probamos GPT-4o y es mucho más rápido que GPT-4

Si tienes curiosidad por saber cuánto más rápido es GPT-4o, la diferencia entre este y GPT-4 es asombrosa.

OpenAI mostró innumerables demostraciones en tiempo real de GPT-4o en ChatGPT en sus presentaciones, y eso es una señal de su confianza en el modelo. La idea de que Google está detrás de OpenAI tampoco es una especulación:ChatGPTtendrá visión, audio y entrada de texto en las próximas semanas, mientras que "algunas de estas capacidades" en Project Astra llegarán a la aplicación Gemini a finales de este año, según Google. Hasta que no veamos a Project Astra haciendo más cosas en teléfonos de consumo reales, es difícil creer que Project Astra esté listo para vencer a GPT-4o todavía.