Con la creciente popularidad de los modelos de lenguajes complejos y las aplicaciones basadas en IA, prácticamente todas las empresas tecnológicas importantes han comenzado a crear hardware capaz de proporcionar el mejor rendimiento en cargas de trabajo de IA. Incluso las computadoras portátiles de consumo han comenzado a incorporar un tipo de unidad de procesamiento completamente nuevo, llamada NPU, para brindar un rendimiento superior en todas las tareas relacionadas con la IA.

Pero, ¿qué sucedería si pudieras ejecutar modelos de IA generativos localmente en unSBC diminuto? Resulta que puedes configurar la API de Ollama para ejecutar prácticamente todos los LLM populares, incluidos Orca Mini, Llama 2 y Phi-2, ¡directamente desde tu placa Raspberry Pi!

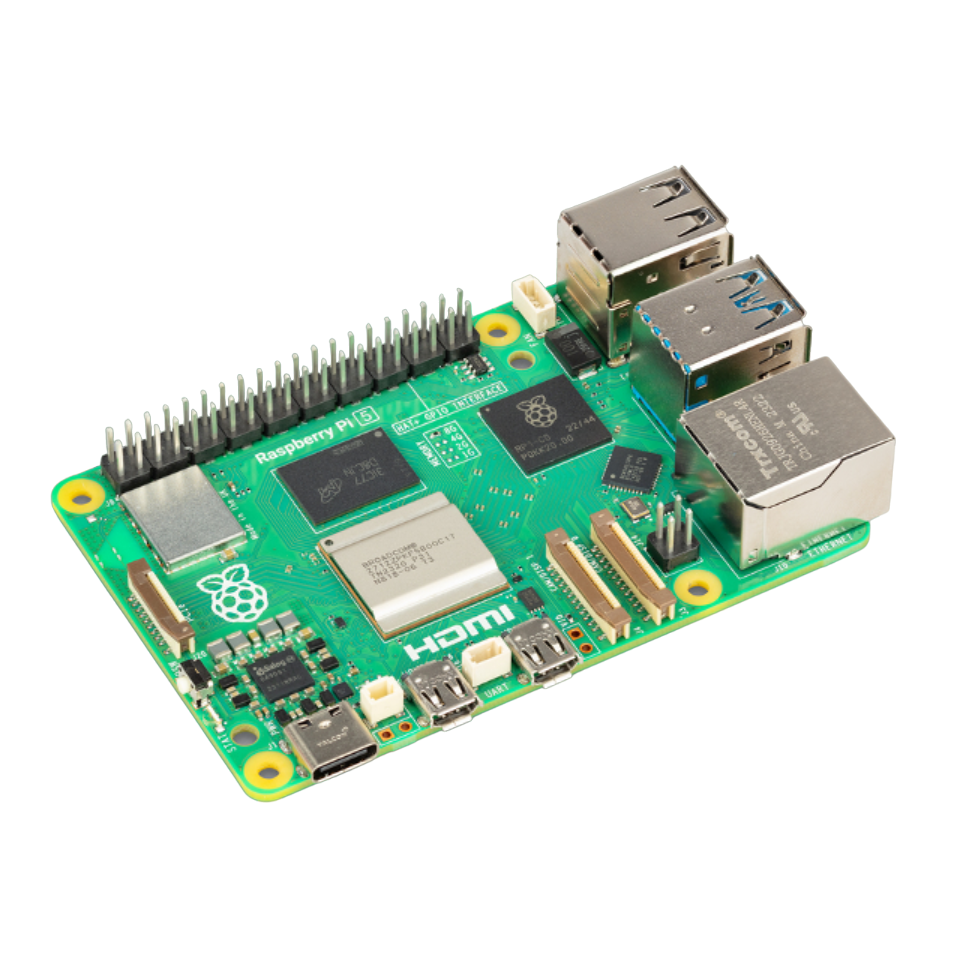

Reseña de Raspberry Pi 5: el santo grial de los proyectos DIY se volvió aún mejor (y más raro)

La Raspberry Pi 5 es una de las tarjetas de control de consumo más potentes que existen. Lamentablemente, su stock limitado significa que te resultará difícil encontrar una.

Lo que necesitarás

Una placa Raspberry Pi será el núcleo de este proyecto. También necesitarás una tarjeta microSD para almacenar el sistema operativo y los LLM. Dado que estos modelos pueden ocupar grandes cantidades de espacio, te sugiero que consigas una tarjeta microSD con al menos 32 GB de espacio. Es posible que quieras considerar la posibilidad de adquirir una variante de 8 GB de Raspberry Pi 4/5 porque Ollama recomienda un mínimo de 8 GB de RAM si quieres ejecutar 7B LLM sin retrasos significativos.

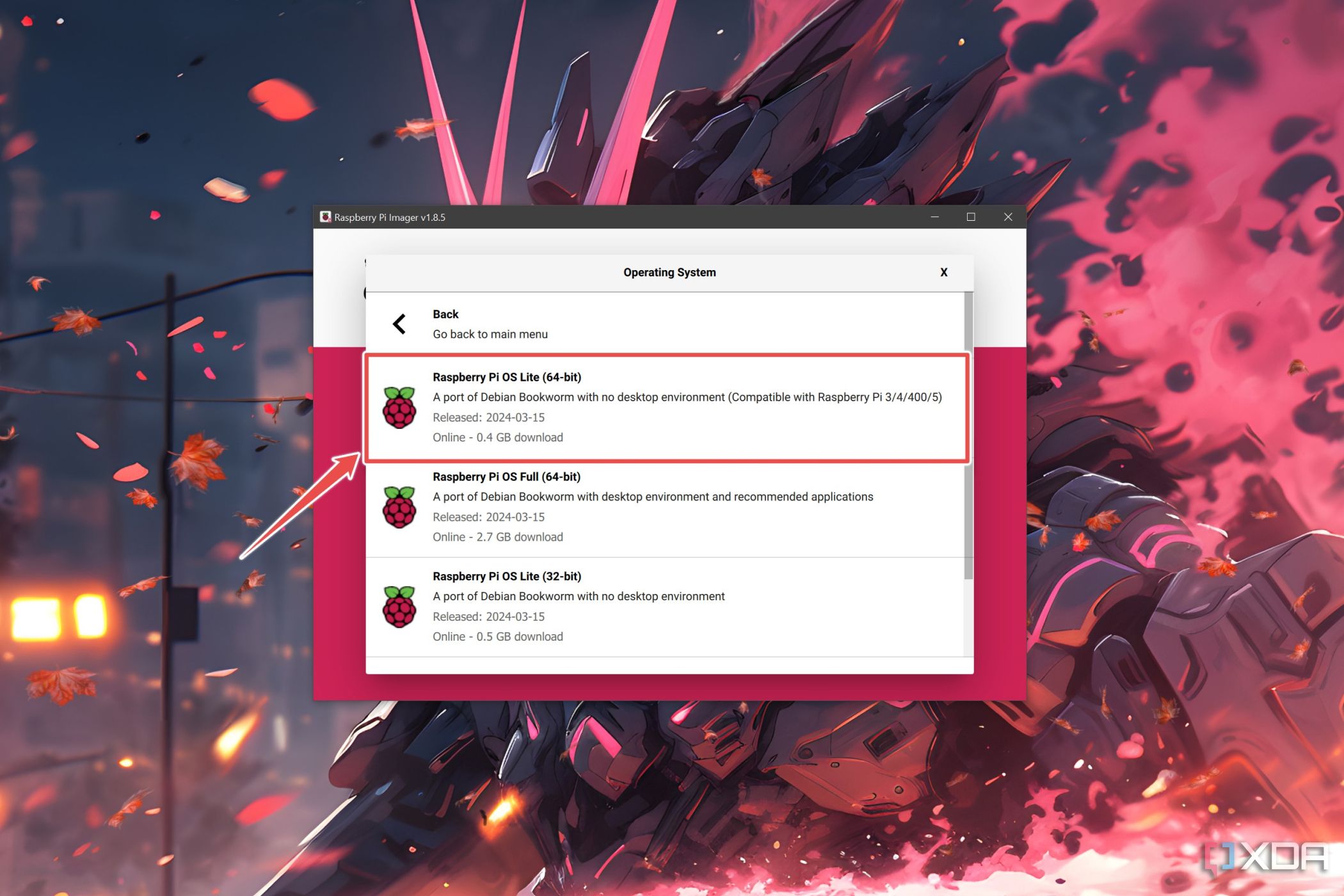

Por último, necesitarás un sistema operativo instalado en la Raspberry Pi. Aunque técnicamente puedes ejecutar los LLM en Raspberry Pi OS o Ubuntu, una instalación limpia de Raspberry Pi OS Lite es el camino a seguir. Esto se debe a que los modelos de IA generativos son muy exigentes con estos SBC y es mejor descartar la GUI en favor de una configuración de CLI liviana.

Instalación del sistema operativo Raspberry Pi Lite

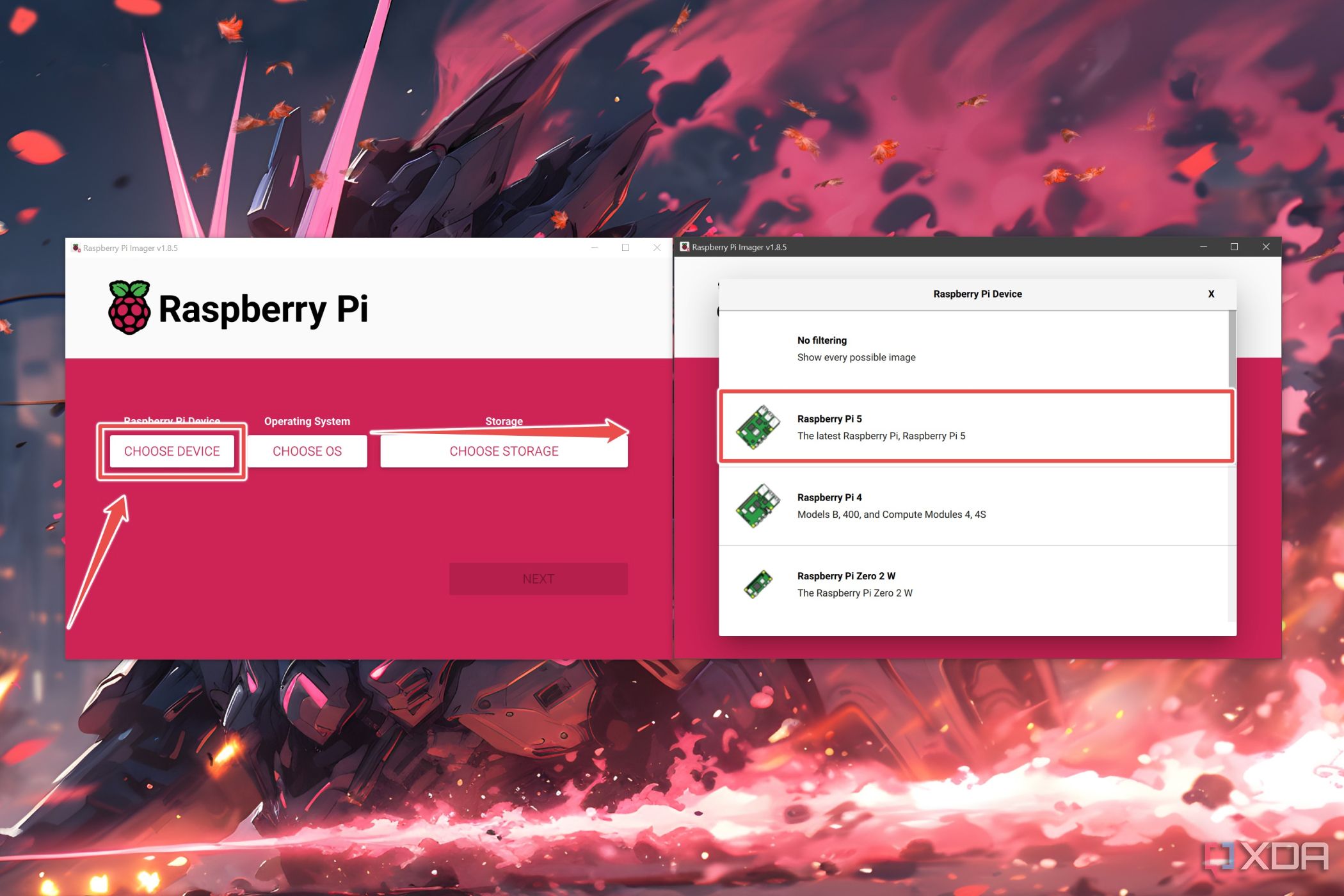

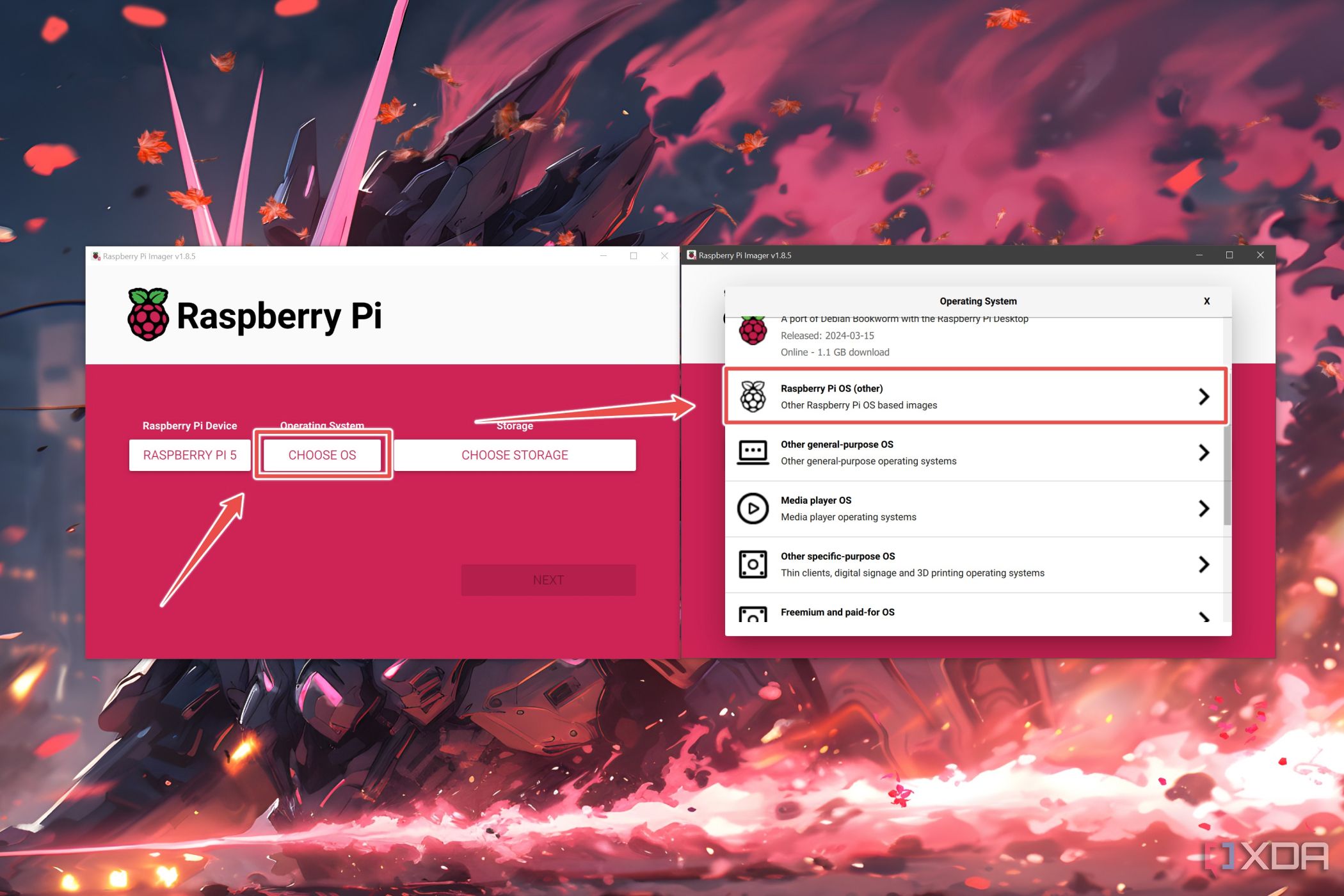

Primero, instalaremos el sistema operativo Raspberry Pi basado en CLI con la herramienta Raspberry Pi Imager. Si bien puedes usar otras herramientas de flasheo como Balena Etcher o Rufus, puedes utilizar la configuración de personalización del sistema operativo de la aplicación oficial de creación de imágenes para acceder fácilmente a Raspberry Pi desde tu PC por SSH.

- Descargue e instale Raspberry Pi Imager desde elenlace oficial.

- Ejecute la herramienta con privilegios de administrador.

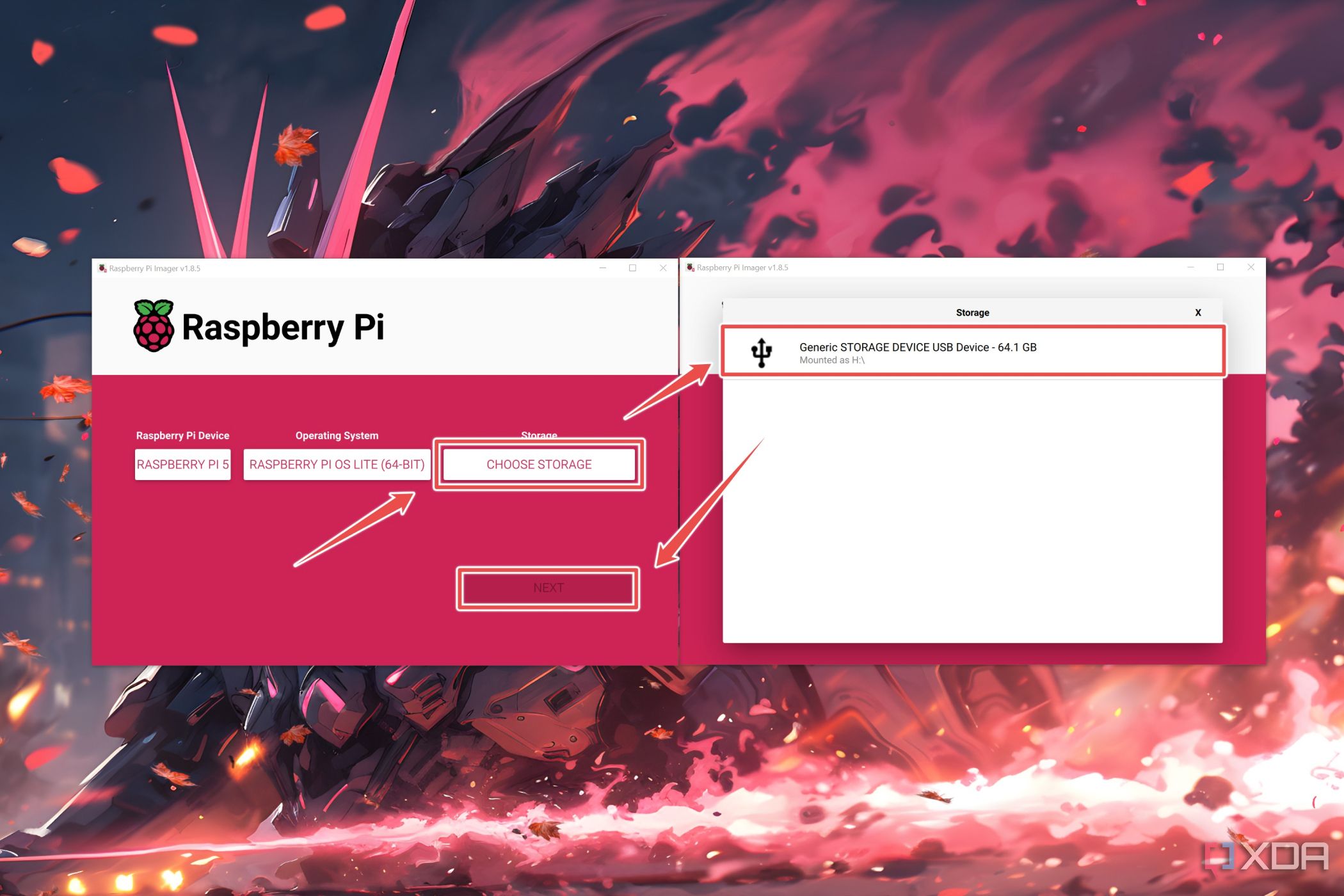

- Haga clic enElegir dispositivoy seleccione sumodelo de Raspberry Pi.

- SeleccioneElegir sistema operativoy diríjase aRaspberry Pi OS (Otro).

- ElijaRaspberry Pi OS Lite (64 bits).

- Haga clic enElegir almacenamiento, seleccione latarjeta microSDdonde desea flashear los archivos del sistema operativo y presioneSiguiente.

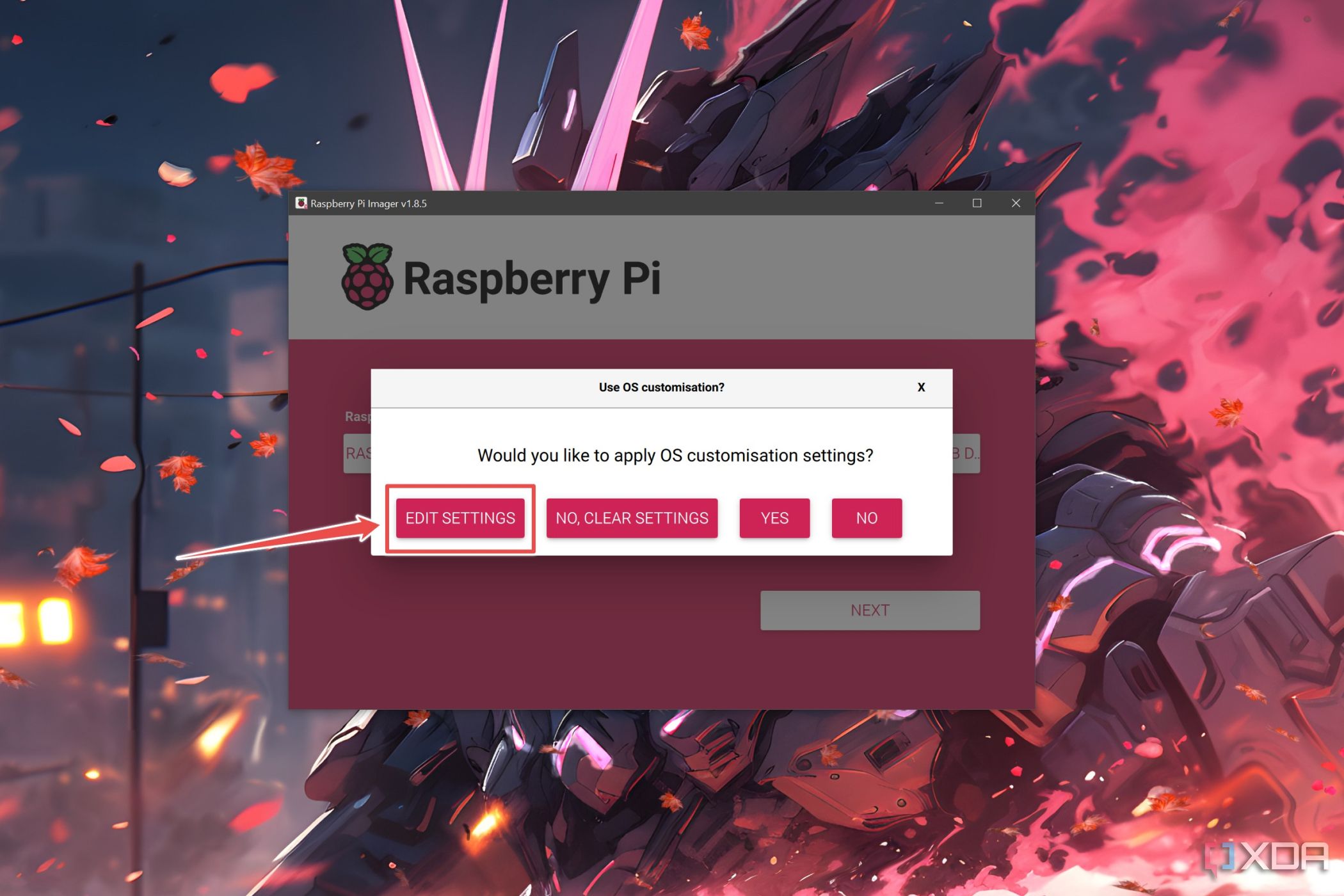

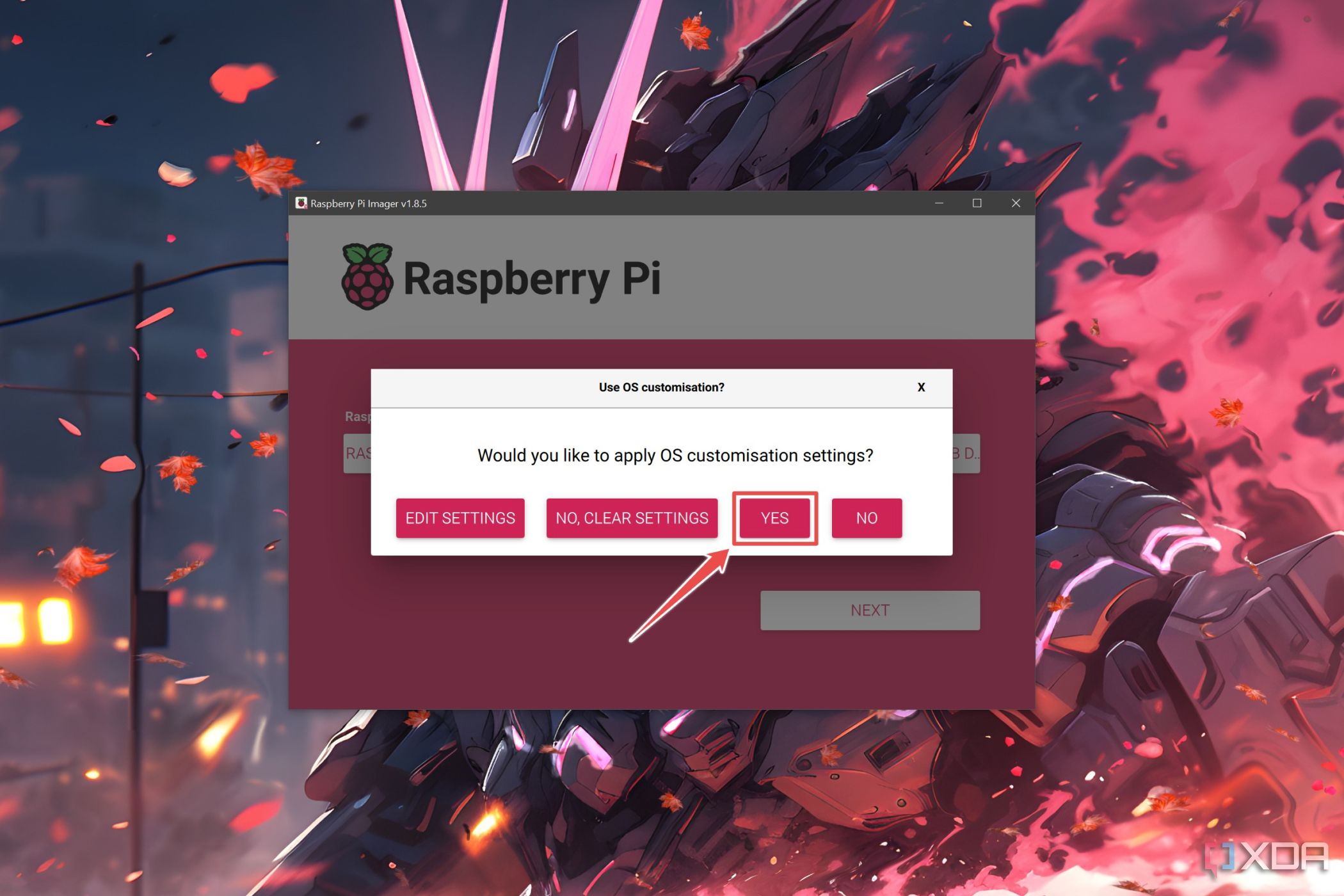

- PresioneEditar configuraciónen la ventana emergente.

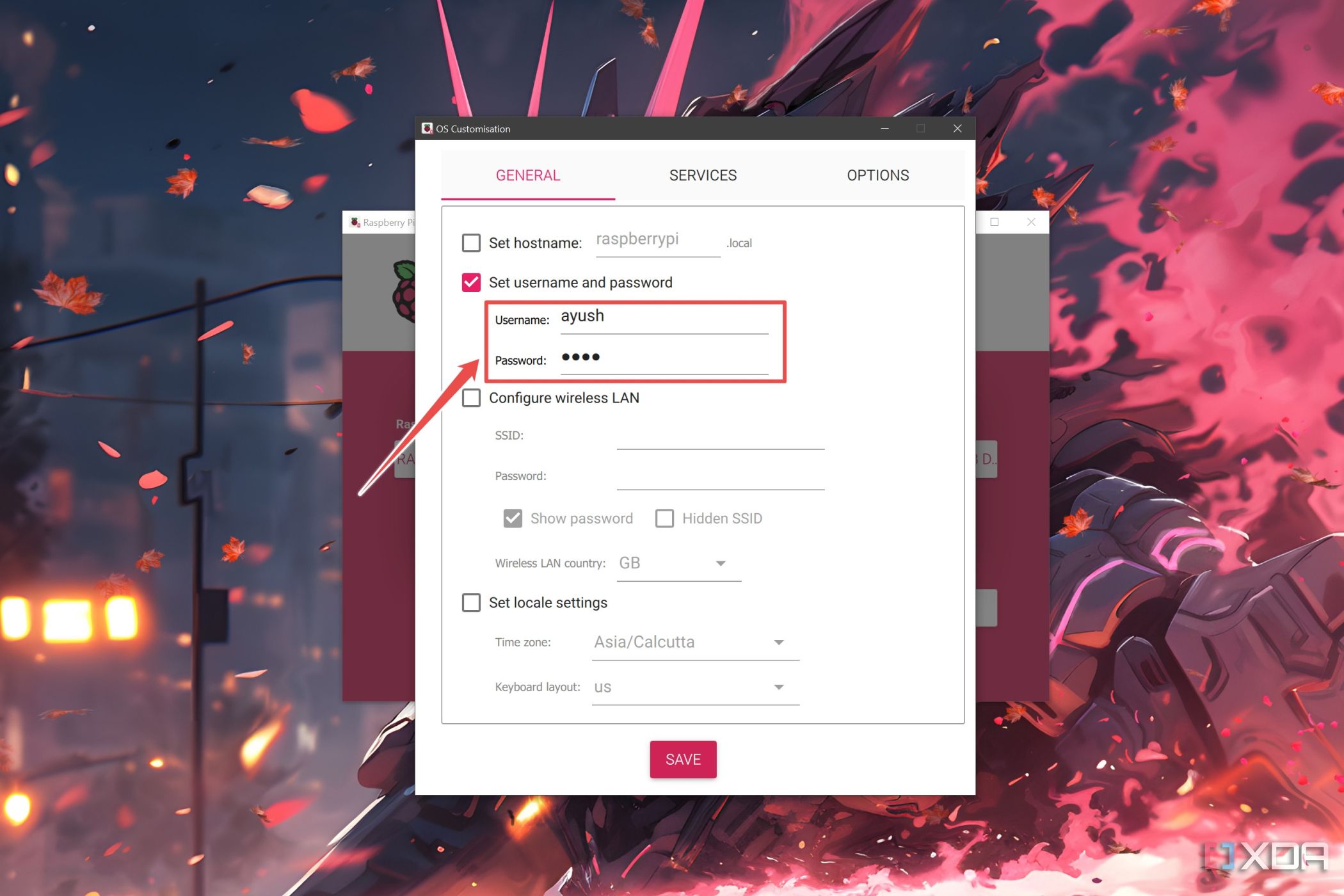

- Dentro de lapestaña General, ingrese elNombre de UsuarioyContraseña.

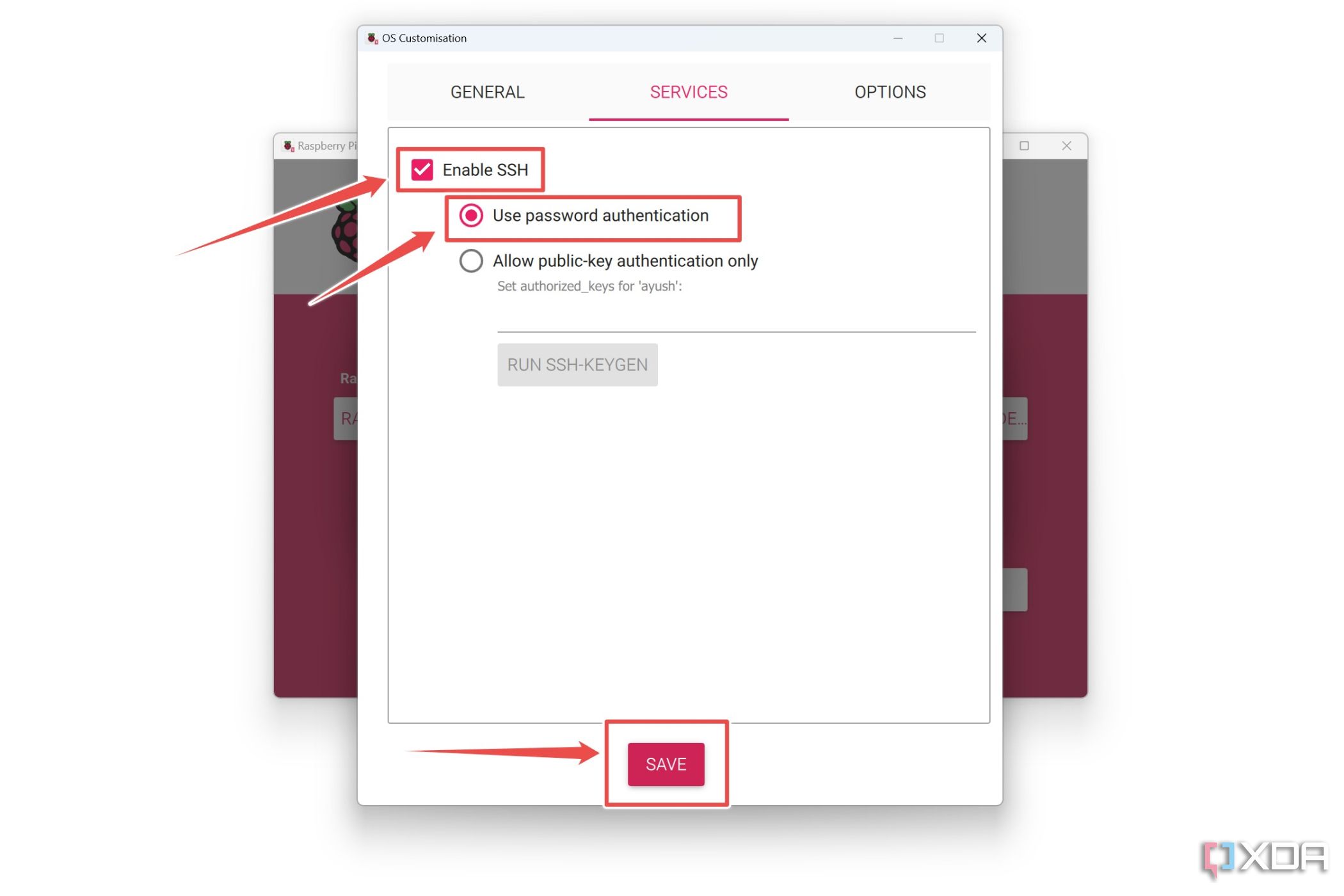

- Vaya a la pestañaServiciosy marque las opciones junto aHabilitar SSHyUsar autenticación de contraseñaantes de hacer clic enGuardar.

- ElijaSícuando Raspberry Pi Imager le solicite confirmación.

Una vez que hayas instalado Raspberry Pi OS Lite, puedes usarlo tal como está o acceder a él mediante SSH siguiendoesta guía.

Configurando Ollama en tu Raspberry Pi

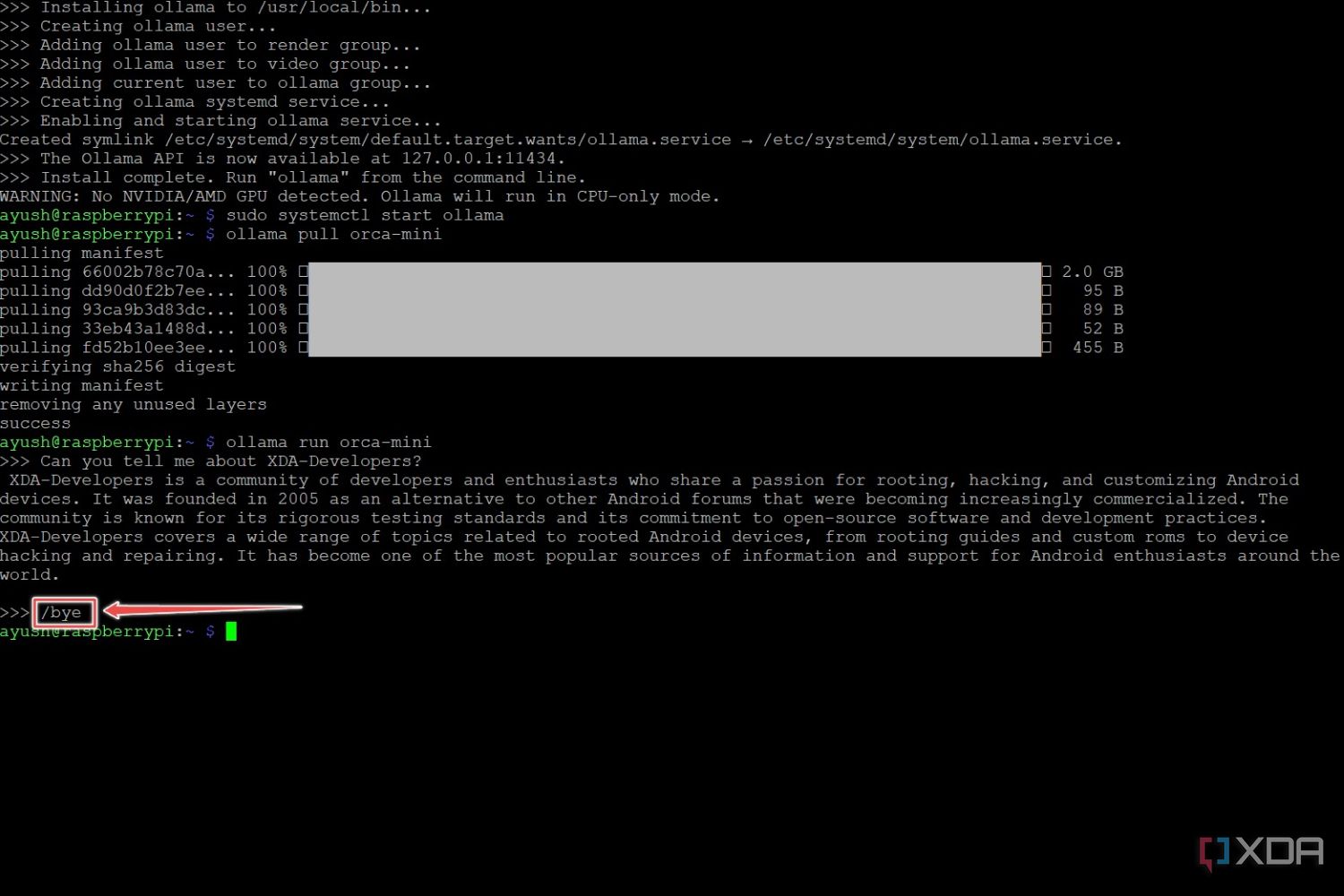

Afortunadamente, instalar Ollama es la parte más fácil de este artículo, ya que todo lo que tienes que hacer es escribir el siguiente comando y presionarEnter:

curl -fsSL https://ollama.com/install.sh | sh

A continuación, es el momento de configurar los LLM para que se ejecuten localmente en su Raspberry Pi.

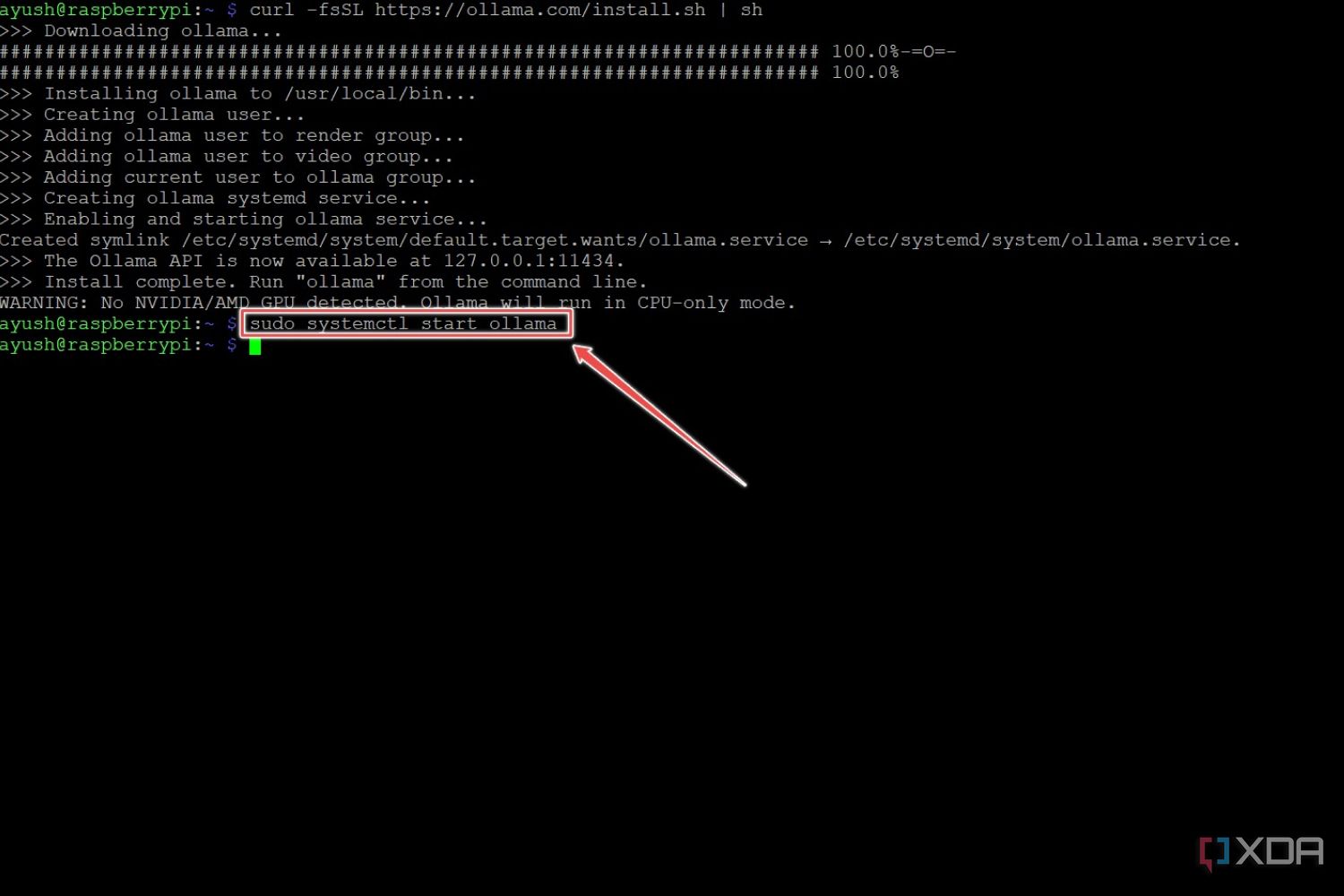

- Inicie Ollama usando este comando:

sudo systemctl start olama

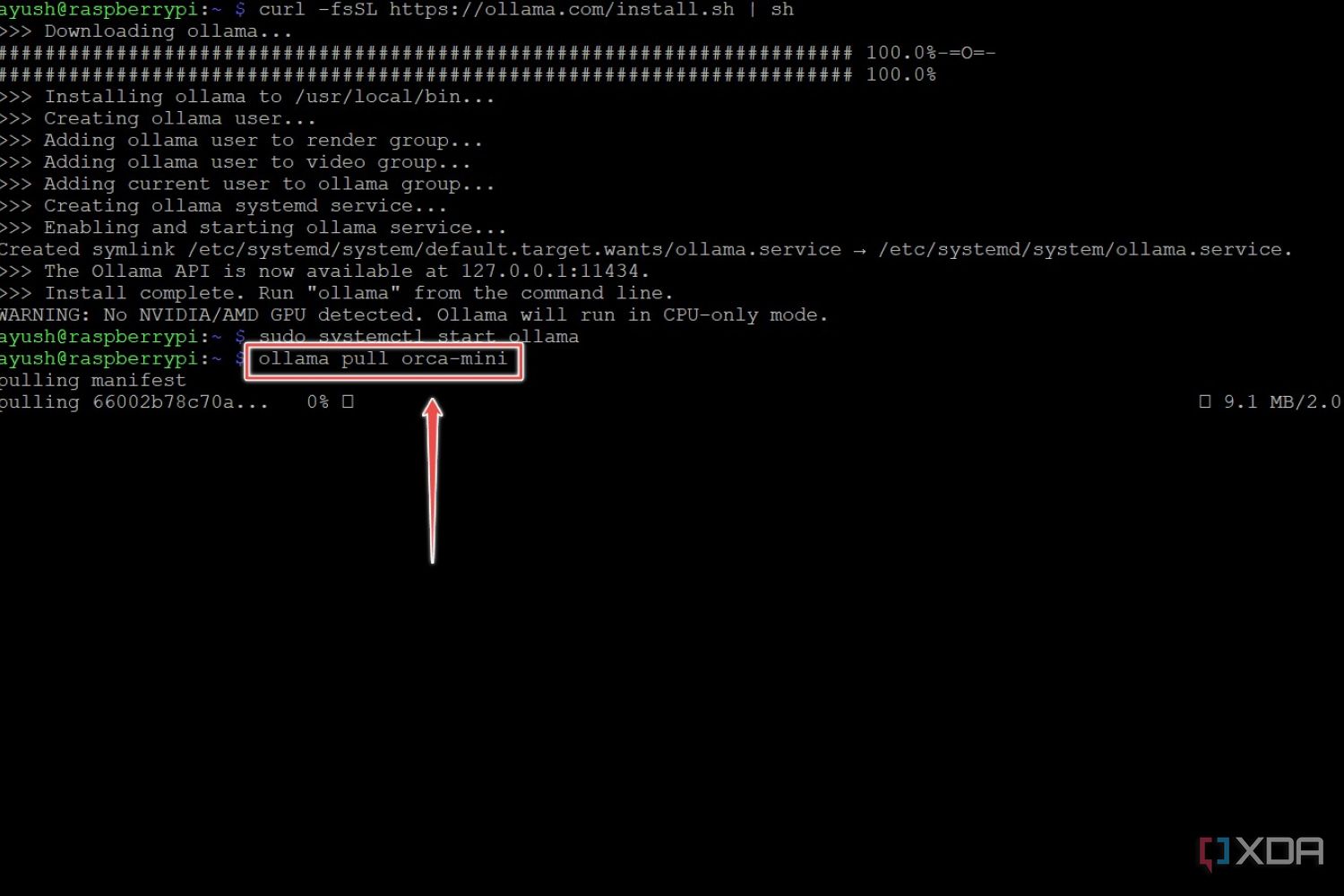

- Instala el modelo que elijas usando el comandopull. En esta guía, utilizaremos el modelo 3B LLM Orca Mini.

Ollama tira de llm_name

Asegúrese de reemplazarllm_namecon el LLM compatible con Ollama que desea descargar. - Ejecute el siguiente comando para ejecutar el LLM que acaba de descargar.

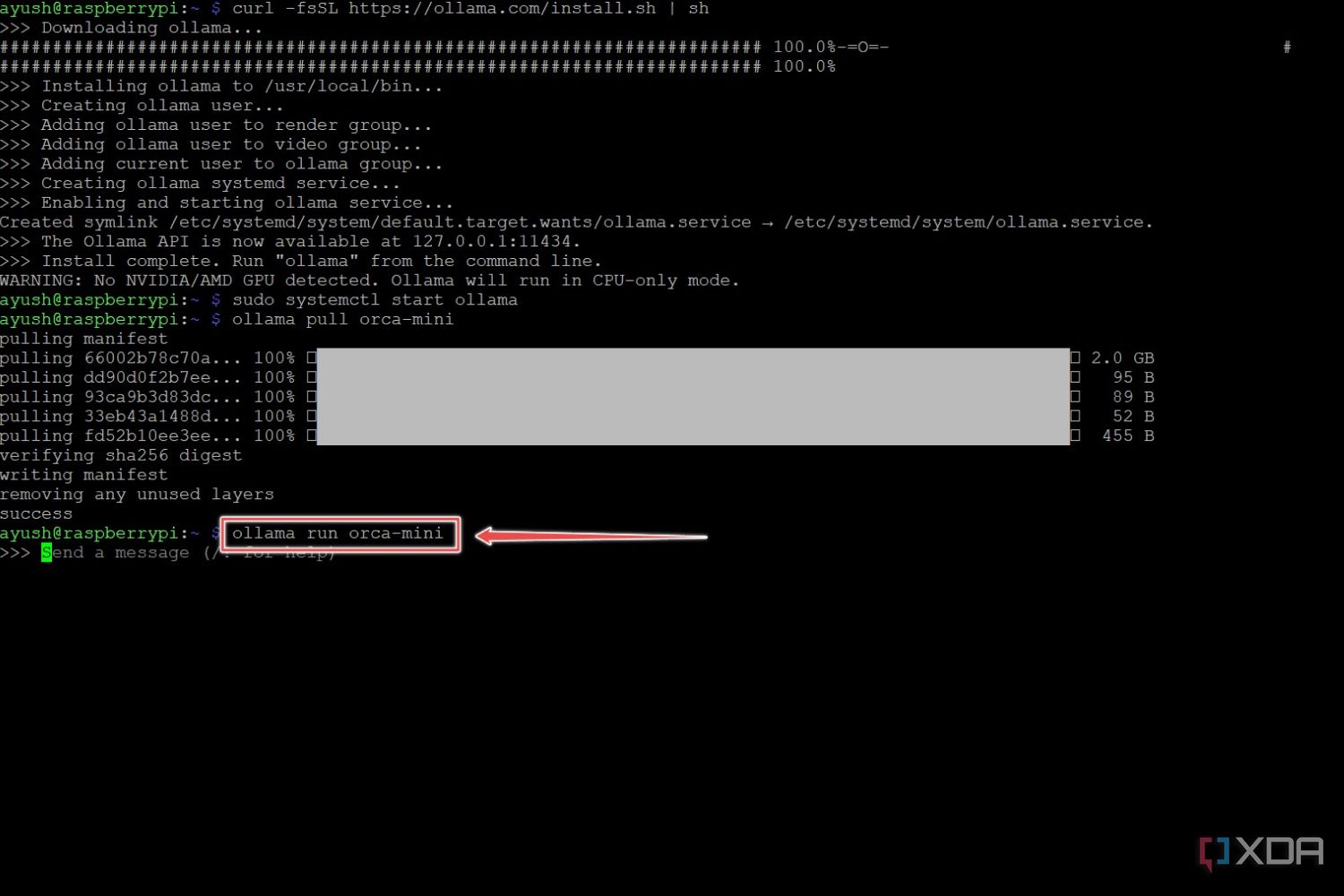

ollama ejecuta llm_name

- Cuando desee salir del LLM, ejecute el siguiente comando:

/adiós

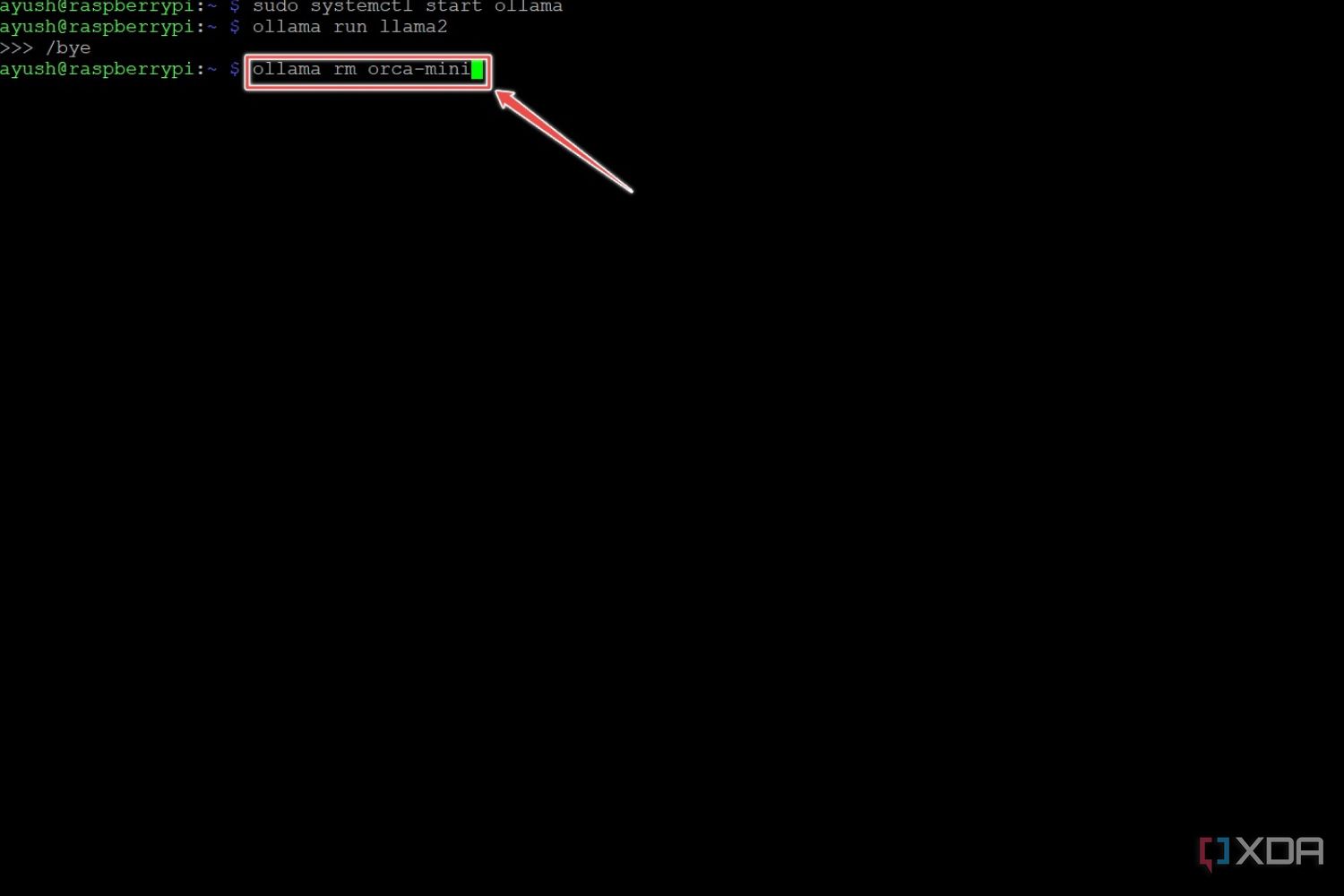

- (Opcional) Si se está quedando sin espacio, puede usar el comando rm para eliminar un modelo.

ollama rm llm_nombre

¿Qué LLM funcionan bien en Raspberry Pi?

Si bien Ollama admite varios modelos, debes limitarte a los más simples, como Gemma (2B), Dolphin Phi, Phi 2 y Orca Mini, ya que ejecutar LLM puede resultar bastante agotador para tu Raspberry Pi. Si tienes una placa Pi con 8 GB de RAM, puedes intentar ejecutar los LLM 7B, aunque el rendimiento no será muy impresionante.

Intenté usar Orca Mini y Phi 2 en mi Raspberry Pi 5 y funcionaron bastante bien. Sin embargo, las limitaciones del SBC se hicieron evidentes en el momento en que ejecuté modelos 7B como Mistral y Llama. Aparte de una larga demora después de ingresar un mensaje, los LLM eran bastante lentos al generar el texto, con una velocidad promedio de 1 a 2 tokens por segundo.

Aunque convertir tu placa Raspberry Pi en un generador de texto de IA es un proyecto divertido, el pequeño dispositivo apenas puede hacer su trabajo cuando se ejecutan los LLM más complejos. Por lo tanto, deberías considerar buscarPC de IA potentessi quieres respuestas más rápidas de tus LLM favoritos.

Cómo ejecutar Llama 2 localmente en tu Mac o PC

Si has oído hablar de Llama 2 y quieres ejecutarlo en tu PC, puedes hacerlo fácilmente con algunos programas gratuitos.