Nuestros teléfonos inteligentes son básicamente computadoras de bolsillo, y con eso vienen las capacidades que se equiparan a las computadoras de muchas maneras diferentes. Desde usar nuestros teléfonos inteligentes para la productividad hasta usarlos para juegos, hay muchas cosas que puedes hacer para aprovechar todo el potencial de tu teléfono. Una de esas cosas que puedes hacer es ejecutar un LLM completamente en tu teléfono inteligente, sin una conexión a Internet. La única desventaja es que necesitarás uno de losmejores teléfonospara ejecutar uno de estos modelos.

Si desea ejecutar cualquier modelo de IA en un teléfono inteligente, lo primero que debe saber es que, para ejecutar básicamente cualquier modelo, necesita muchaRAM. Esa filosofía es la razón por la que necesita muchaVRAMcuando trabaja con aplicaciones como Stable Diffusion, y también se aplica a los modelos basados en texto. Básicamente, estos modelos generalmente se cargarán en la RAM durante la carga de trabajo y esmuchomás rápido que ejecutarlos desde el almacenamiento.

La RAM es más rápida por un par de razones, pero las dos más importantes son que tiene una latencia más baja, ya que está más cerca de la CPU, y tiene un mayor ancho de banda. Es necesario cargar modelos de lenguaje grandes (LLM) en la RAM debido a estas propiedades, pero la siguiente pregunta que suele surgir es exactamentecuántaRAM utilizan estos modelos. Vicuna-7B es uno de los modelos más populares que cualquiera puede ejecutar, y es un LLM entrenado en un conjunto de datos de 7 mil millones de parámetros que se pueden implementar en un teléfono inteligente Android a través de MLC LLM, una aplicación universal que ayuda en la implementación de LLM. Se necesitan alrededor de 6 GB de RAM para interactuar con él en un teléfono inteligente Android, lo que no es un listón muy alto para superar en estos días.

Si estás interesado en realizar un LLM en tu teléfono inteligente, sigue leyendo, porque te sorprenderá lo fácil que es.

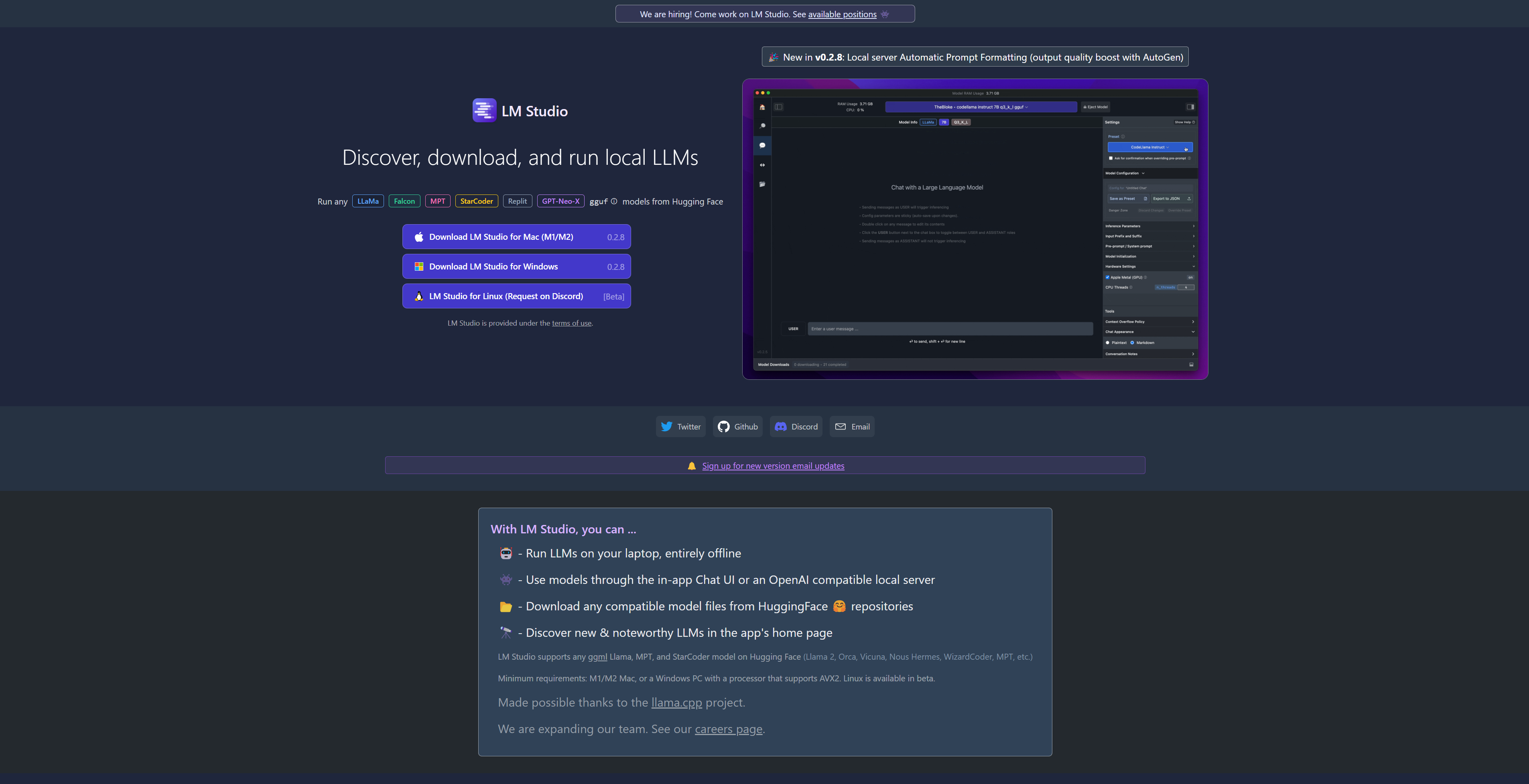

Ejecute LLM locales con facilidad en Mac y Windows gracias a LM Studio

Si desea ejecutar LLM en su PC o portátil, nunca ha sido más fácil hacerlo gracias al potente y gratuito LM Studio. Aquí le mostramos cómo usarlo

Cómo utilizar MLC para ejecutar LLM en su teléfono inteligente

Es una aplicación muy básica.

Para descargar y ejecutar LLM en su teléfono inteligente, puede descargar MLC LLM, un programa que implementará y cargará modelos para usted. Esos modelos pueden luego ejecutarse dentro de la aplicación, y la aplicación se encargará de cargar esos modelos en la RAM y ejecutarlos por usted. En cierto sentido, es un poco como LM Studio, aunque solo para su teléfono inteligente.

De fábrica, MLC LLM admite la instalación de Vicuna 7B y RedPajama 3B, pero puedes darle una URL para cargar un modelo manualmente si quieres probar otro. Hay muchos modelos diferentes que puedes encontrar en Hugging Face que podrían valer la pena probar y que varían en tamaño, pero lo mejor es asegurarte de no superar un modelo de parámetros 7B. De lo contrario, pueden ser demasiado grandes para que tu teléfono los maneje, ya que pueden requerir mucha RAM.

Para configurar un LLM en su teléfono inteligente, haga lo siguiente:

- Descargue e instale MLC LLM

- Descarga uno de los modelos que te muestra, o añádelo manualmente desde Hugging Face

- Ábrelo y espera a que se cargue.

¡Eso es todo! Hace que el proceso sea increíblemente sencillo de instalar y poner en funcionamiento un LLM en tu teléfono inteligente. Si quieres probarlo, esta es, sin duda, la mejor manera. MLC también tiene una aplicación en iOS y la aplicación está disponible en la App Store. Hay cientos de modelos en Hugging Face, así que échales un vistazo y ve lo que puedes encontrar.

Las mejores aplicaciones de IA: herramientas que puedes ejecutar en Windows, macOS o Linux

Si quieres jugar con algunas herramientas de IA en tu computadora, puedes usar algunas de estas herramientas de IA para hacer precisamente eso.