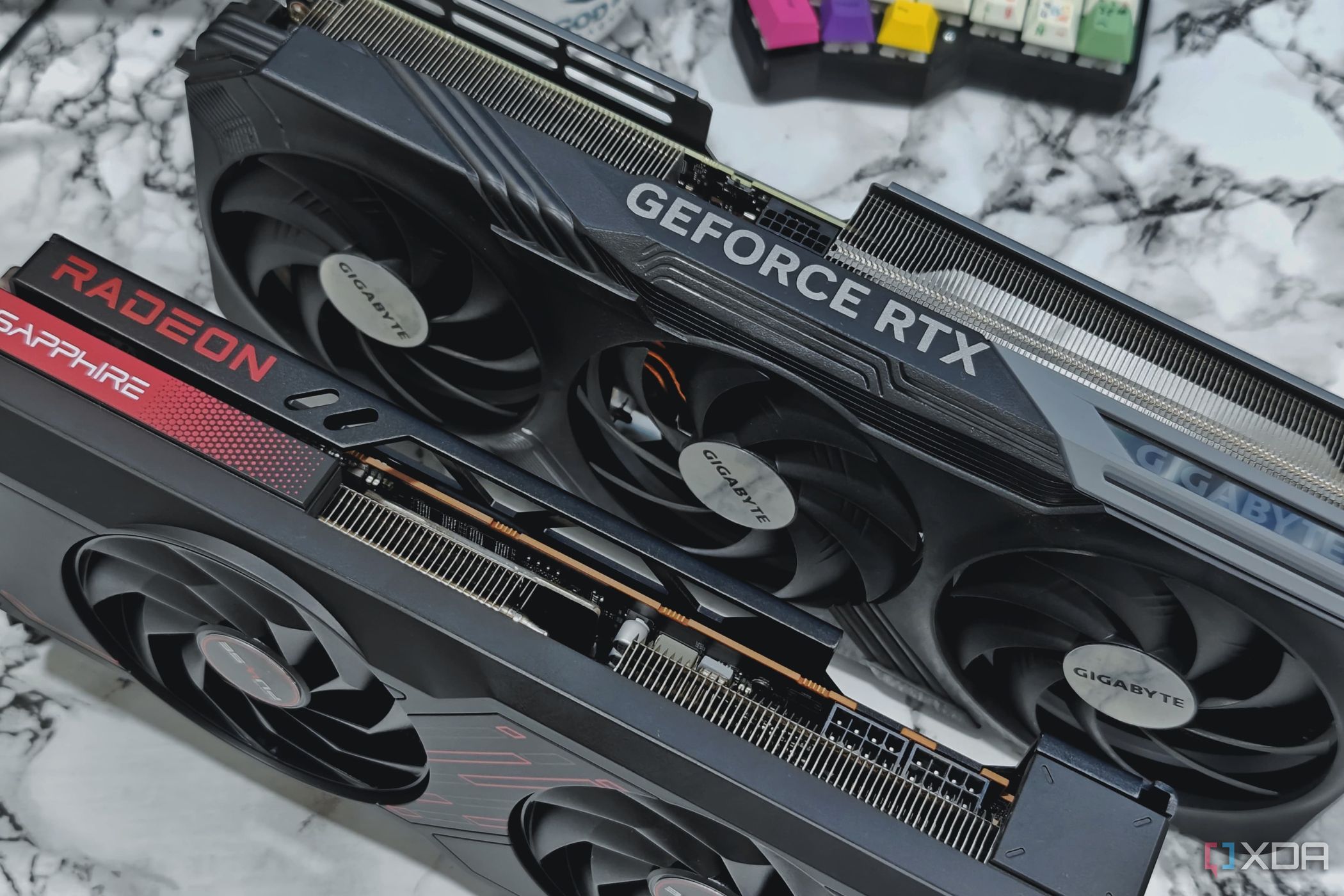

Hasta mediados de la década de 2010, las PC para juegos más rápidas usaban varias tarjetas gráficas, normalmente dos, pero a veces hasta cuatro. Luego, algunas de lasmejores tarjetas gráficas para juegosusaban dos chips GPU en lugar de uno solo, lo que ayudó con la consolidación. Las tecnologías multi-GPU SLI de Nvidia y CrossFire de AMD se consideraban la cumbre de cualquier PC para juegos de alta gama y podían elevar tu experiencia de juego al siguiente nivel.

Hoy en día, las GPU múltiples son cosa del pasado, prácticamente una reliquia en el mundo de la informática. El hecho de que la mayoría de las GPU nuevas de hoy ni siquiera sean compatibles con SLI o CrossFire es sin duda un problema, pero la popularidad de las GPU múltiples estaba decayendo mucho antes de que Nvidia y AMD descontinuaran esas tecnologías. Aquí se cuenta la historia de los juegos con GPU múltiples y por qué no resistieron la prueba del tiempo.

Una breve historia de las GPU múltiples, desde 3dfx hasta su declive

Aunque las tarjetas gráficas modernas surgieron a principios de la década de 2000 a partir de la rivalidad entre Nvidia y AMD, hubo muchos más participantes durante los años 90. Una de esas empresas fue 3dfx Interactive, que produjo la nostálgica línea de tarjetas gráficas Voodoo. Para obtener una ventaja competitiva, la empresa decidió que dos tarjetas gráficas podían ser mejores que una y, en 1998, presentó su tecnología Scan-Line Interleave (SLI). Fue una jugada bastante ingeniosa por parte de 3dfx, ya que fomentó más ventas de GPU y disuadió a los propietarios de Voodoo de cambiarse a otra tarjeta.

Sin embargo, SLI se introdujo justo cuando 3dfx se encaminaba hacia la quiebra y la empresa fue finalmente adquirida por Nvidia, que obtuvo los derechos de propiedad intelectual de todo lo que poseía 3dfx. La tecnología Multi-GPU dejó de existir brevemente después de la adquisición de 3dfx, pero Nvidia reintrodujo SLI (cambiando el nombre oficial a Scalable Link Interface) en 2004 con su serie GeForce 6. Básicamente funcionó de la misma manera que antes: agregar más GPU, obtener más rendimiento. Pero hubo algunas innovaciones con la propuesta de Nvidia.

Mientras que el antiguo SLI de 3dfx hacía que cada GPU renderizara una línea de píxeles de a uno por vez (la "línea de escaneo" en SLI), el nuevo SLI de Nvidia introdujo dos nuevos métodos de renderizado: el renderizado de fotogramas divididos (SFR) y el renderizado de fotogramas alternativos (AFR). Con SFR, cada GPU renderiza una parte de un único fotograma, no dividiendo el fotograma por la mitad, sino dándole a cada GPU un trozo igualmente intensivo para renderizar. Por otro lado, con AFR, cada GPU produce un fotograma a su vez. Si bien SFR es excelente para reducir la latencia, AFR tiende a obtener el mayor rendimiento, aunque con un ritmo de fotogramas mucho más pobre y tartamudeo.

De manera similar, en 2005, ATI (que pronto sería adquirida por AMD) presentó su propia tecnología multi-GPU, llamada CrossFire, pero al principio fue un poco confusa. Con las tarjetas 3dfx y Nvidia, todo lo que necesitabas eran dos GPU iguales y un cable o puente para conectarlas, pero CrossFire requería que compraras una tarjeta "maestra" especial además de una tarjeta gráfica normal. Entonces, en lugar de usar un puente, usabas un extraño cable DVI que se conectaba a ambas tarjetas. Baste decir que la primera generación de CrossFire estuvo mal ejecutada. No ayudó que, en ese momento, sus GPU no fueran increíbles.

Pero CrossFire realmente alcanzó su máximo esplendor con la introducción de la serie Radeon 3000 de AMD (antes ATI), que incluía la Radeon HD 3870 X2, la primera tarjeta gráfica del mundo con dos chips GPU. AMD fue muy lejos con todo este concepto de doble GPU; sus chips de las series Radeon 4000 y 5000 eran en realidad bastante pequeños, por lo que las tarjetas gráficas de doble GPU tenían mucho sentido. La HD 5970 en 2009,una de las mejores GPU de AMD de todos los tiempos, a menudo se describía como demasiado rápida para ser factible. Después de esto, Nvidia también comenzó a fabricar sus propias tarjetas de doble GPU.

Sin embargo, después de este punto, la popularidad de las GPU múltiples comenzó a declinar. Nvidia abandonó el concepto de GPU dual para sus GPU convencionales después de la GTX 690 en 2012, y lo abandonó por completo después de la GTX Titan Z en 2014. Nvidia hizo que SLI fuera exclusivo solo dos años después para sus GPU GTX 1070, 1080 y 1080 Ti, y también redujo el soporte de cuatro tarjetas gráficas a dos. SLI estuvo en soporte vital después de esto, pero finalmente se eliminó en 2020 con el lanzamiento de la serie RTX 30, de la cual solo la 3090 admitía SLI. Pero eso no importó, ya que Nvidia dejó de brindar soporte para controladores SLI a partir de 2021.

Mientras tanto, AMD siguió fabricando tarjetas con doble GPU durante años, y solo dejó de fabricarlas en 2019 con la Pro Vega II, una tarjeta exclusiva para Apple Mac. AMD incluso dijo en 2016 que dos RX 480 en CrossFire eran una buena alternativa a la GTX 1080 de Nvidia. Sin embargo, AMD finalmente abandonó CrossFire después del lanzamiento de RX Vega en 2017, que fue la última tarjeta AMD compatible. Parece que AMD también dejó de fabricar controladores con compatibilidad con CrossFire por juego en algún momento de 2017.

Las muchas razones por las que las GPU múltiples desaparecieron

Teniendo en cuenta todo esto, los juegos con múltiples GPU llegaron y desaparecieron con bastante rapidez. Solo se convirtieron en una fuerza significativa después de 2004 con SLI y CrossFire, pero en la década de 2010 ya estaban en declive. En última instancia, lo que acabó con su vida fue la dirección que estaba tomando la industria gráfica y el hecho de que los jugadores encontraran las soluciones con una sola GPU mucho más atractivas.

Las GPU se hicieron más grandes con cada generación y finalmente superaron a las GPU múltiples.

Cuando 3dfx introdujo SLI, las tarjetas gráficas eran dispositivos diminutos con un consumo de energía realmente bajo, nada que ver con los gigantes que vemos hoy. Los chips gráficos tendían a tener un tamaño de unos 100 mm2 en los años 90 y principios de los 2000, pero todo esto cambió cuando ATI lanzó su serie Radeon 9000, que incluía un chip de más de 200 mm2, el doble del tamaño de cualquier otro que el mundo hubiera visto antes. Esto dio inicio a una carrera armamentista de GPU que ATI/AMD y Nvidia siguieron intensificando con cada generación.

El problema es que los chips más grandes requieren más potencia y mejor refrigeración, y aunque al principio el aumento del consumo de energía no afectó demasiado a las configuraciones multi-GPU, con el tiempo resultó ser un problema importante. Incluso en la GTX 480, las tarjetas gráficas habían llegado a la marca de los 250 W, y dos 480 en SLI consumían una cantidad increíble de energía. Aunque AMD puso un énfasis significativo en el multi-GPU con sus series HD 4000 y 5000, en realidad fue solo porque necesitaba algo de gama alta para competir con los 480 y 580 de Nvidia, ya que los chips gráficos de AMD eran demasiado de gama media.

Desde finales de la década de 2000, casi todos los productos estrella fabricados por Nvidia y AMD consumían al menos 200 W, a menudo 250 W. Puede que no sea una coincidencia que la última tarjeta de doble GPU de Nvidia, la 690, utilizara dos chips GTX 680, que tenían un TDP de solo 195 W. El simple hecho de que las GPU individuales fueran cada vez más grandes y mejores hizo que SLI y CrossFire fueran más difíciles y menos atractivos para los usuarios, que por lo general no querían que su PC para juegos fuera también un calentador de ambiente y un motor a reacción.

El sistema Multi-GPU tenía errores y requería que los desarrolladores, Nvidia y AMD invirtieran recursos en él.

Las tendencias de hardware fueron un problema para la viabilidad de las GPU múltiples, y también lo fueron las tendencias de software. Cuando se introdujo SLI por primera vez, los juegos eran mucho más simples, e incluso los mejores juegos de 2004, comoHalf-Life 2,son bastante comunes en comparación con los juegos de hoy, aunque podemos apreciar lo geniales que eran cuando salieron. SLI y CrossFire requerían que Nvidia y AMD crearan optimizaciones especiales para GPU múltiples en sus controladores para lograr un buen rendimiento, y en ese entonces, esto no era un gran problema.

Pero con el tiempo, los juegos (y, por extensión, las GPU) se volvieron más complicados y cada año era más difícil optimizarlos. Incluso en los títulos que tenían soporte oficial para múltiples GPU, la experiencia a menudo era deficiente debido a un rendimiento inferior al normal o a errores. Durante un breve período en 2016, tuve dos Radeon R9 380 y, cuando jugué aThe Witcher 3,a menudo vi fallas gráficas extrañas que a veces incluso cubrían características importantes como las entradas a las cuevas, lo que hacía que el juego no solo fuera peculiar sino que tuviera errores hasta el punto de ser injugable.

En última instancia, fue la dirección que estaba tomando la industria gráfica y el hecho de que los jugadores encontraban las soluciones de GPU única mucho más atractivas lo que supuso su sentencia de muerte.

El único atisbo de esperanza para un mejor soporte de software para multi-GPU fue DX12 y Vulkan, que se jactaban de un soporte multi-GPU tan poderoso que incluso se podían usar múltiples GPU de diferentes proveedores en un solo juego. Sin embargo, esto simplemente delegó el trabajo que solían hacer Nvidia y AMD en manos de los desarrolladores, quienes no ganaron nada al admitir la tecnología multi-GPU, especialmente porque Nvidia y AMD la estaban eliminando gradualmente. Por lo tanto, el aspecto del software tampoco funcionó para los juegos multi-GPU.

Los jugadores simplemente no necesitaban configuraciones multi-GPU de alta gama

Incluso si las cosas en el lado del hardware y el software de la ecuación hubieran funcionado, los juegos con múltiples GPU podrían haber estado condenados simplemente porque eran excesivos. Incluso la HD 5970 fue descrita como exagerada, y eso fue solo con dos chips GPU de gama media. Aún así, la tecnología multi-GPU fue lo suficientemente popular como para seguir funcionando durante años, pero creo que su destino se decidió por un solo evento: el lanzamiento de la GTX 1080 en 2016.

La serie GTX 10 de Nvidia era en realidad solo la serie GTX 9 en el nuevo 16nm de TSMC, pero eso por sí solo fue un gran logro ya que Nvidia había pasado tres generaciones completas en 28nm debido aldeclive de la Ley de Moore. Pasar de 28nm a 16nm resultó en que la GTX 1080 fuera más del 50% más rápida que la GTX 980 y un 30% más rápida que la GTX 980 Ti. La 1080 también admitía SLI y su TDP era relativamente bajo a 180W, pero el rendimiento bruto con una sola 1080 era una locura en 2016.

Si bien los juegos de PC que utilizan múltiples gráficos aparentemente nunca volverán, la puerta para las GPU múltiples en realidad está abierta.

Esto se mejoró aún más con la GTX 1080 Ti del año siguiente, lo que aumentó el rendimiento en casi otro 30 %. Una sola 1080Ti era casi el doble de rápida que una 980 Ti y, sin duda, habría sido una solución superior a dos 980 Ti en SLI. Nadie en su sano juicio querría realmente dos 1080 Ti en SLI, no solo porque habría sido caliente y ruidoso, sino también porque el doble de rendimiento de una 1080 Ti habría sido completamente excesivo (y también inviable para la mayoría de los juegos con soporte oficial para SLI). Imagínese lo loco que sería tener dos RTX 4090 en SLI.

Los juegos con múltiples GPU podrían volver a estar de moda

Aunque los juegos de PC con múltiples gráficos aparentemente nunca volverán, la puerta a las GPU múltiples está abierta. Si estás familiarizado con las CPU de AMD, sabrás que sus chips de escritorio de gama alta y todas sus CPU para estaciones de trabajo y servidores usan varios chips de CPU juntos en lugar de una CPU grande. El uso de muchos chips más pequeños (también conocidos como chiplets) es una tecnología que AMD comenzó a usar en 2019, aunque recién en 2022 comenzó a usar chiplets para sus GPU con la introducción de la serie RX 7000 de gama alta.

Sin embargo, las tarjetas RX 7000, como la RX 7900 XTX, solo tienen varios chiplets de memoria y caché, y usan un solo chip GPU. Aun así, hay motivos para creer que AMD podría comenzar a usar varios chiplets gráficos, ya que reduciría los costos de desarrollo y producción y, al mismo tiempo, simplificaría la fabricación de nuevas tarjetas (solo agregaría o quitaría un chiplet y listo, nueva GPU). Intel también podría seguir la misma dirección, ya que también está haciendo la transición a chiplets.

Aunque parece que Nvidia no tiene ningún interés en los chiplets, sería sorprendente que AMD e Intel no estuvieran interesados en recuperar la tecnología multi-GPU con chiplets. Tal vez veamos el regreso de los juegos multi-GPU con tecnología moderna en los próximos años si funciona lo suficientemente bien.