Resumen

- Las GPU duales cayeron en desuso debido a problemas de compatibilidad con la representación diferida, lo que causaba brechas de comunicación y un uso ineficiente de la VRAM.

- Los problemas de rendimiento, incluidos microtartamudeos, y el soporte mediocre de los desarrolladores de juegos contribuyeron al declive de las configuraciones multi-GPU.

- Las GPU de un solo chip mejoraron rápidamente, lo que hizo que las GPU duales fueran una inversión poco práctica y costosa en comparación con la actualización regular de las GPU.

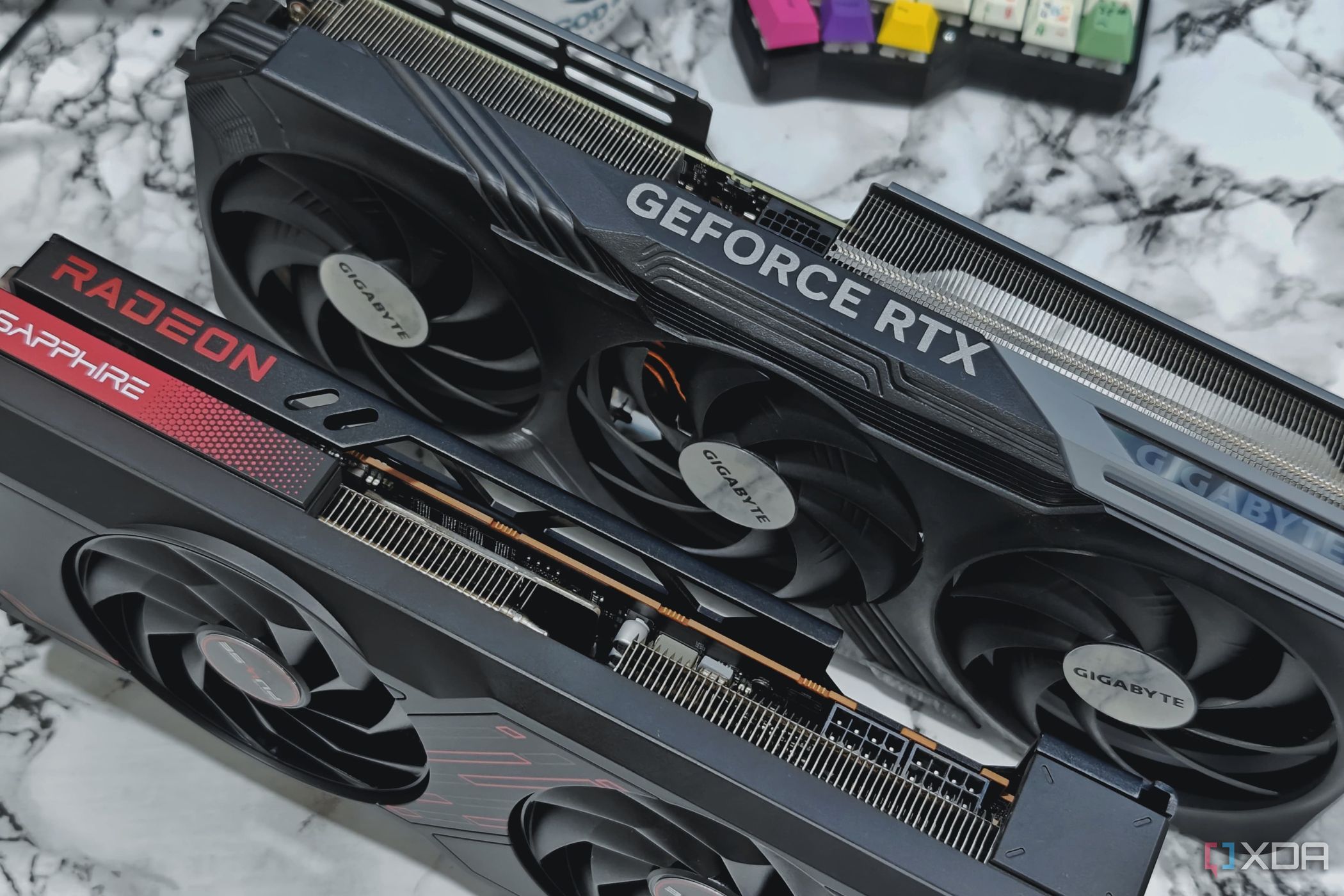

Todo el mundo conocelas configuraciones de juegos con múltiples GPU, que fueron el espectáculo de la década anterior. Pero, ¿sabías que antes existían GPU convencionales que tenían más de un chip en su PCB? Estas bestias de renderizado existen desde 1997, y la Dynamic Pictures Oxygen 402 fue una de las primeras con no dos, sino cuatro chips GPU en una sola PCB.

Empresas como 3dfx dieron fama a las GPU duales y, después, su lugar lo ocuparon ATI (que más tarde sería sustituida por AMD) y Nvidia, que siguió fabricando GPU duales hasta gran parte de la última década. Lamentablemente, ya no se encuentran GPU duales para consumo. ¿Qué hizo que la fórmula de GPU dual, que en su día fue revolucionaria, se convirtiera en un mero recuerdo de una era ya pasada?

4Representación diferida

Las GPU duales simplemente no funcionaron bien con la renderización diferida

Con la rapidez con la que mejoraron los gráficos de los videojuegos después del año 2000, los desarrolladores comenzaron a optar por el renderizado diferido. A diferencia de la técnica de renderizado avanzado, que ya estaba obsoleta, el renderizado diferido era más eficiente para manejar una escena con múltiples fuentes de luz y exigía menos a la tarjeta gráfica, sin afectar demasiado a la calidad visual. Esto se logra dividiendo el proceso de renderizado en varias etapas y utilizando la información de las etapas anteriores para evitar cualquier renderizado innecesario.

El problema entre el renderizado diferido y las GPU múltiples o duales era que, dado que el cuadro final dependía de las etapas anteriores de su renderizado, los datos relativos a esas etapas debían pasarse de una GPU a la otra. Inicialmente, se utilizó la interfaz PCIe para pasar esos datos y, con el tiempo, se añadieron los conectores SLI y Crossfire, pero ni siquiera estos eran suficientes para el gran ancho de banda que requería la comunicación. Otro problema se presentó en forma de uso ineficiente de la VRAM. Dado que ambas GPU tenían acceso solo a sus propias VRAM, cada VRAM tenía que almacenar el mismo conjunto de texturas para permitir que ambas GPU renderizaran la misma escena. Esto significaba que tener 2 GPU de 4 GB solo te daría 4 GB de VRAM efectiva.

Ambos problemas existían también en las GPU duales. A pesar de que ambos chips estaban en la misma placa de circuito impreso, existía una brecha de comunicación entre los chips y sus VRAM. Esta brecha podría haberse reducido con suficiente esfuerzo, al menos en las tarjetas gráficas con ambos chips en la misma placa de circuito impreso. Sin embargo, debido a la falta de incentivos, Nvidia y AMD no le prestaron mucha atención.

3Problemas de rendimiento

El omnipresente e infame microtartamudeo

Entre los problemas que presentaban las GPU múltiples y duales, el más notorio era el micro-stuttering. Esto se debía a la forma en que ambas GPU dividían la carga de trabajo de renderizado de cuadros y, a menos que agregaras una tercera o cuarta GPU a tu configuración sin el apoyo adecuado de los desarrolladores, no había solución alternativa.

Con el lanzamiento de DirectX12, la compatibilidad con varias GPU mejoró. Sin embargo, a esta API se le atribuye a menudo el mérito de ser el último clavo en el ataúd de las configuraciones multi-GPU. Esto se debe a que, si bien DirectX12 podía aumentar significativamente el rendimiento de las configuraciones multi-GPU en los juegos, todo el trabajo debía ser realizado por los desarrolladores de juegos. Con solo un pequeño porcentaje de jugadores con configuraciones que podían aprovechar esto, los desarrolladores no tenían ningún incentivo para invertir horas y dinero adicionales en agregar una función que solo unas pocas personas podían aprovechar. Los pocos juegos DX12 que agregaron compatibilidad con varias GPU, comoAshes of the SingularityyShadow of the Tomb Raider, funcionaron bien en dichas compilaciones.

Incluso si ignoramos el alto precio y el consumo de energía que supone una configuración multi-GPU, el fracaso de la comunidad de jugadores a la hora de adoptar esta tecnología condujo a un apoyo mediocre por parte de los desarrolladores de juegos, lo que generó problemas de rendimiento y compatibilidad, lo que llevó a la gente a evitar por completo las configuraciones multi-GPU. Fue un círculo vicioso que solo terminaría con la muerte de las tarjetas gráficas multi-GPU y, en consecuencia, de las de doble GPU.

2Mejoras e innovaciones rápidas en las GPU de un solo chip

Las GPU de un solo chip fueron la compra más inteligente

En 2014, Nvidia lanzó su última GPU dual, la Titan Z, por 3000 dólares. Esta era una tarjeta de ensueño para muchos, con 5 TFLOPS de velocidad de cálculo FP32 y 336 GB/s de ancho de banda de memoria. Apenas cuatro años después, en 2018, se lanzó la RTX 2080 Ti por menos de la mitad del precio de la Titan Z, con 13,45 TFLOPS de FP32 y 616 GB/s de ancho de banda de memoria, y tenía funciones revolucionarias comoDLSSytrazado de rayos.

Con las GPU de un solo chip mejorando tan rápidamente, no tiene sentido invertir una cantidad tan absurda de dinero en una GPU dual que podría no seguir siendo relevante durante más de unos pocos años, por lo que actualizar periódicamente las GPU es la mejor opción. Por lo tanto, incluso si los fabricantes de GPU fabricaran GPU duales, solo los entusiastas de los juegos de PC las comprarían, lo que no generaría muchas ventas ni sería suficiente para incentivar a los desarrolladores de juegos a optimizar sus juegos para dichas tarjetas gráficas.

Las mejores GPU en 2025: nuestras mejores tarjetas gráficas

Elegir la tarjeta gráfica adecuada puede resultar difícil dada la gran cantidad de opciones que hay en el mercado. Estas son las mejores tarjetas gráficas que debes tener en cuenta.

1Las GPU duales dejaron de ser relevantes

Perdieron la ventaja que una vez tuvo su legado.

Si bien las GPU de doble chip alguna vez tuvieron un precio competitivo y proporcionaron un aumento de rendimiento, pronto se convirtió en una carrera para ver qué empresa podía crear la GPU más cara y con mayor consumo de energía. Durante su apogeo, las GPU duales brindaron un rendimiento mucho mejor por su dinero. Por ejemplo, la GTX 295 (una GPU dual cuyo precio de venta sugerido por el fabricante era de $499 y combinaba características de GTX 260 y GTX 280) brindó un mejor rendimiento que 2x GTX 260 en SLI, una apuesta que costaría $900.

La Titan Z de Nvidia en 2014 no fue más que un ejercicio de arrogancia. Con un precio de 3000 dólares y un rendimiento peor que dos GTX 780 en SLI, cada una de las cuales costaba solo 650 dólares, fue un completo fracaso. La R9 380x2 de AMD fue una historia similar: requería cuatro conectores de 8 pines y un TDP de 580 W, estaba destinada al fracaso. Si bien estas tarjetas llamaron la atención, casi nadie las compró. El mal soporte multi-GPU significaba que solo un chip en estas GPU haría el trabajo pesado en la mayoría de los juegos, lo que hacía que estas tarjetas tuvieran una muy mala relación calidad-precio, y dado que las GPU de un solo chip de esas generaciones eran lo suficientemente potentes, funcionaban de manera más silenciosa mientras consumían menos energía y eran menos costosas, todos optaron por esa dirección. La única ventaja real que tenía la doble GPU era el espacio que ocupaban, ya que en lugar de usar dos GPU separadas, una en cada ranura PCIe, se obtenía la misma funcionalidad a través de una sola ranura PCIe.

¿Volverán las GPU duales?

Te sorprenderá saber que hoy en día todavía se fabrican GPU duales. La Radeon Pro Vega II Duo de AMD utilizada en el Mac Pro de Apple es un ejemplo. También existen configuraciones multi-GPU, pero no como las conocíamos y amábamos antes. Solo los profesionales y las industrias que requieren este tipo de GPU y configuraciones las utilizan, y gracias a la compatibilidad con mGPU de AMD, los pocos jugadores que aún quieren utilizar dos GPU pueden hacerlo.

Pero para los juegos, es seguro decir que las GPU de doble chip no volverán a estar de moda en el corto plazo. Es decir, no de la forma en que pensaríamos. La industria de las CPU y las GPU se dirige hacialos chiplets, con AMD a la cabeza. En su estado actual, esto no es de ninguna manera equivalente a tener dos GPU en el mismo chip, ya que el chip principal se divide en bloques funcionales para reducir los costos de producción. Pero tal vez en el futuro, los chiplets puedan evolucionar hasta un punto en el que podamos ver algo que realmente cuente como una GPU dual.